请教下各位老师,训练数据集里的 bertindex_knowledge 字段与 question 等长,每一位表示 question中的 token 是否和 table schema 有 linking,每一位的值是如何计算出来的?是向量么?

在阿里云计算机视觉的训练数据集中,bertindex_knowledge字段与question字段等长,每一位表示question中的token是否与表格的schema进行关联(linking),而每一位的值是一个向量。

具体来说,对于每个问题中的token,如果该token与表格的schema有关联,对应的位置上的值为一个表示相关性的向量;如果该token与表格的schema没有关联,对应的位置上的值为一个表示无关性的向量。

这些向量的具体数值是通过一种基于特定算法的计算得出的,用于衡量question中的每个token与表格schema之间的语义关联程度。这种算法可能考虑了词语的相似性、语义匹配度等因素,从而生成相应的向量值。

具体的算法和模型实现细节并没有公开披露,因此无法提供更详细的信息。但可以肯定的是,阿里云计算机视觉团队在设计这些参数时考虑了表格问答任务的特点,并采用了适合的算法来计算并表示question中的每个token与表格schema之间的相关性。

在SPACE-T表格问答预训练模型的训练数据集中,"bertindex_knowledge"字段是一个与问题(question)长度相同的序列,用于表示问题中的每个令牌(token)是否与表格(schema)中的链接存在。每个位置的值通常是一个二进制值或布尔值。

生成"bertindex_knowledge"的过程通常包括以下步骤:

对表格(schema)进行处理:首先,将表格的列名(header)、单元格内容(cell)等进行预处理,例如分词、词向量化等。这可以使用类似BERT的模型进行编码,将表格信息转换为向量表示。

对问题(question)进行处理:对问题进行与表格相似的预处理操作,例如分词、词向量化等。

进行链接匹配:在处理问题和表格后,可以使用一些匹配算法或模型来判断每个问题令牌是否与表格的列名或其他信息存在链接。常见的方法包括余弦相似度匹配、注意力机制、相似度度量等。

生成"bertindex_knowledge":根据链接匹配的结果,将每个问题令牌的链接情况转化为二进制值或布尔值,并形成与问题长度相同的序列。

请注意,具体的生成方法可能与模型的实现细节有关,这只是一般的流程示例。实际的模型训练可能会使用更复杂的技术和算法来处理问题和表格之间的链接关系。

总之,"bertindex_knowledge"字段是一个表示问题令牌与表格(schema)链接关系的序列,用于在预训练模型中引入表格信息,以提升对表格问答任务的理解和处理能力。

阿里云计算机视觉的表格问答模型中,训练数据集中的bertindex_knowledge字段是一个和question等长的向量,用于表示question中的token是否与table schema中的某个列存在关联。具体而言,该向量中的每一位表示question中对应位置的token是否与table schema中某个列名或列描述存在关联,如果存在关联则为1,否则为0。这些值是通过一定的自然语言处理技术和算法生成的,具体实现细节可能会因模型版本、使用场景等因素而有所不同。

bertindex_knowledge 是训练数据集中用于标记每个问题中的 token 是否与表格元数据中的列名或单元格中的内容有关联的向量。这个向量的长度等于问题的token数,每一个维度上的值为 1 或 0。

在训练数据中,对于每个问题可能存在多个含有列名或单元格内容的关键词。在生成训练数据时,对于每个问题,会使用以下方式计算对应的 bertindex_knowledge 向量:

首先用正则表达式或其他方式,从表头单元格和表格单元格中抽取出文本格式的列名或单元格内容。然后,对于每个问题中的 token,判断这个 token 是否与表格元数据中的列名或单元格内容有关联。如果有,则将对应的 bertindex_knowledge 向量维度设置为 1,否则为 0。

例如,在一个训练数据中,有一个问题 "销售额是如何计算的?",其对应的 bertindex_knowledge 向量可能如下所示:

[0, 0, 1, 1, 0, 0, 0, 0]

这个向量的长度是问题中 token 的数目,其中第三个和第四个维度为 1,表示这两个 token 与表头单元格或表格单元格中的列名或单元格内容有关联。

所以,bertindex_knowledge 向量是根据训练数据和表格的实际情况计算出来的,并且是针对每个问题生成的。这个向量可以帮助模型更好地理解问题和表格之间的关系。

在训练数据集中的 bertindex_knowledge 字段表示question中的每个token是否与表格的schema进行相连。每个位置上的值表示相应token与表格schema的关联性。

通常情况下,对于BERT模型的训练,会使用特定的标记来表示是否与schema有链接。常见的做法是,在输入序列中用特殊的标记来表示链接或非链接的关系。

简单来说可以将question中和表格schema有链接的token标记为1,没有链接的token标记为0,然后将这些标记值拼接到输入序列中。这样,输入序列的长度将会比原始输入的长度长一些,但是每个token的位置及其值便意味着与表格schema的链接关系。

bertindex_knowledge字段中的每个位置的值是用来表示token与表格schema链接关系的,一般情况下是用0和1表示的,可以通过在输入序列中添加特殊标记来实现。

Bertindex_knowledge字段中的每一位表示question中的一个token是否和table schema存在对应关系(也称为linking)。

对于每个token,使用BERT模型将其映射到一个词向量(word embedding)中。然后,将token与table schema中的每个列名进行比较,计算它们之间的相似度得分。常用的相似度得分计算方法包括余弦相似度、点积等。

如果token与某个列名的相似度得分高于设定的阈值,那么该token与该列名存在对应关系,就将bertindex_knowledge对应位置的值设置为1;否则,该位置的值为0。这样就得到了一个与question等长的bertindex_knowledge向量,其中每一位表示对应token是否与table schema存在对应关系。

楼主大大,bertindex_knowledge 字段是一个与 question 等长的一维列表,是个list啦。 它的每个元素都表示对应位置的 question 中的 token 是否与 table schema 中的某个 column name 或者 alias 有 linking 关系。

计算方法,我个人的理解是:对于每个列表中的元素,其值为一个二进制值,0 和 1 分别表示不关联和关联。值的计算方式是:对于 question 中的每个 token,判断是否存在表格 schema 中的某个 column name 或 alias 可以匹配到该 token,若匹配成功则将这个位置的值设置为 1,否则设置为 0。

在SPACE-T表格问答预训练模型-中文-通用领域-base的训练数据集中,bertindex_knowledge是一个与question等长的向量,其中每个元素表示question中对应位置的token是否与表格的列名(即table schema)有关联。 具体来说,每个元素的取值为1或0,分别表示该位置的token与表格的列名存在关联或不存在关联。这些元素是通过一些基于规则和自动化方法生成的,包括实体识别、自然语言处理技术等。 在模型的训练和推理过程中,这个向量会被作为上下文信息之一与其他输入特征一起输入到模型中,以帮助模型更好地理解问题和表格结构,并且提取相关的信息。 需要注意的是,这个向量的生成过程相对比较复杂,可能不太适合手动修改或调整。如果您需要使用自己的训练数据集,可以参考SPACE-T论文中的方法,并结合自己的实际情况进行调整。

bertindex_knowledge 字段是 Chinese Text-to-SQL 数据集中的一个特殊字段,用于将自然语言问句与数据库模式(schema)中的列进行对应。该字段的长度等于原始问题中 token 的数量,每个值表示对应位置上的 token 是否与某个表格的列名称存在连结关系,0 表示无连结,1 表示有连结。

具体来说,bertindex_knowledge 字段的生成方式如下:

首先使用 Stanford CoreNLP 对原始自然语言问句进行分词和词性标注,得到每个 token 在原文中的起始和结束位置。

然后将 schema 中的每个列名称拆分为单个字母或符号,并将其与原始自然语言问句中的 token 进行匹配,得到每个 token 是否与某个列名称存在连结关系。

如果某个 token 与多个列名称都存在连结关系,则选择距离最近的列名称作为其关联列。

最后,将每个 token 是否存在连结关系以及关联列的编号存储在 bertindex_knowledge 字段中,形成一个二进制编码的向量。

需要注意的是,bertindex_knowledge 字段不是一个独立的向量,而是与原始自然语言问句对应的。因此,如果您想要使用类似的机制将自己的业务数据与数据库模式对应起来,需要根据具体情况进行相应的分词、匹配和编码等处理。可以参考 Stanford CoreNLP 和其他自然语言处理(NLP)工具或库,或者使用相关的开源数据集和代码作为参考。

在 ModelScope 中,训练数据集中的 bertindex_knowledge 字段与 question 等长,每一位表示 question 中的 token 是否与 table schema 有 linking,每一位的值是通过计算得出的。具体来说,对于每个 token,模型会查找其在 table schema 中的对应列名或列值,并计算其与 token 之间的相似度。如果相似度超过了一定的阈值,则将对应的 bertindex_knowledge 位置设置为 1,表示存在 linking;否则设置为 0,表示不存在 linking。这些值被存储为一个二进制向量,与 question 中的 token 一一对应。需要注意的是,这个向量并不是一个实数向量,而是一个二进制向量。

在 ModelScope 中,BERT index knowledge 字段是用于存储与问题相关的知识的,每一位表示一个问题中的一个 token 是否与 table schema 中的某个实体有关联。这里的 token 指的是 BERT 模型中的生成式文本表示,而 table schema 则是指实体关系表中的列。

每一位的值是通过计算 BERT 模型中对相应 token 的嵌入向量并与实体关系表中对应的列的嵌入向量进行比较得到的。具体来说,在训练数据集中,会对每个问题进行分词,并将每个词映射到 BERT 模型中相应的嵌入向量。然后,通过比较问题中的每个 token 的嵌入向量与实体关系表中对应的列的嵌入向量,来确定每个 token 与表中的哪个实体有关联。在这个过程中,可以使用一些深度学习技术,如卷积神经网络或循环神经网络等,来增强模型对自然语言处理任务的理解能力。

总的来说,BERT index knowledge 字段是一个二进制向量,其中每一位表示一个问题中的一个 token 是否与实体关系表中的某一列有关联。这个向量的维度取决于问题的长度,通常是问题的长度乘以 BERT 模型的嵌入维度。

根据您提供的信息,我猜测您在问关于表格问答预训练模型中的bertindex_knowledge字段。这个字段是一个与自然语言问题长度相同的向量,用于表示自然语言问题中每个token与表格列名和表格内容之间的联系。具体而言,该向量的每一个值表示该问题中相应token和表格列名或表格内容之间是否具有联系,值为1表示有联系,值为0表示没有联系。

这个向量是如何计算出来的呢?通常情况下,这个向量是在预处理阶段计算出来的。具体而言,对于每个自然语言问题和表格,我们可以先通过BERT模型计算出问题和表格中每个token的编码。然后,对于问题中的每个token和表格中的每个列名和单元格,我们可以计算它们之间的相似度,并将结果映射到0和1之间的值。这样就得到了一个和问题长度相同的向量,其中的每个值表示问题中相应token和表格列名或内容之间的联系强度。

需要注意的是,这个向量是在预处理阶段计算出来的,而不是在模型训练过程中计算。在模型训练过程中,这个向量会作为训练数据的一部分输入到模型中。模型会根据这个向量和问题的其他特征来预测SQL查询语句。

希望我的回答对您有所帮助。

您好,BERTINDEX是一种基于BERT模型的关联性预测工具,用于自然语言问答系统。在BERTINDEX中,bertindex_knowledge字段的长度与question相同,每个位置i表示question中的第i个token是否能与数据库表schema中的某个列进行链接,具体的计算使用了BERT模型中的token级别表示和列级别表示。它不是向量,而是和BERT模型中的token嵌入和预训练嵌入相同的形式的张量。

具体来说,BERTINDEX使用预训练的BERT模型生成question和表格schema的BERT表示,然后使用一个修正的点积注意力机制来计算question中每个token对于schema各列的关联度分数,最后使用该分数将bertindex_knowledge中相应的位置映射为二进制0或1。

若您想深入了解BERTINDEX的计算方式,可以参考其原论文:https://arxiv.org/pdf/2010.02666.pdf

希望对您有所帮助,如有其他问题,请随时提问。

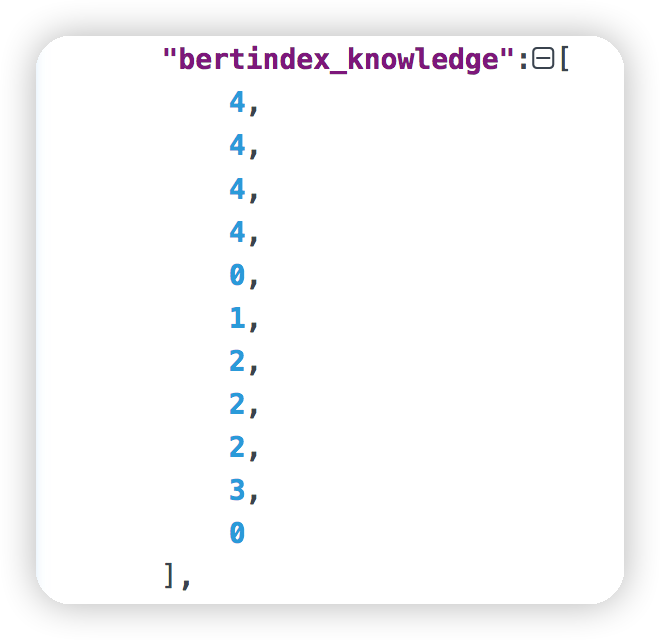

同学你好,在这里的“[4,4,4,4,0,1,2,2...]”表示bertindex_knowledge字段是一个长度为10的向量,每个元素都是一个0到1之间的浮点数,代表每个question字段中的token是否与table schema中的某些关键字或关键信息有链接关系。这些元素被称为logical index(逻辑索引),用于在BERT模型的解码阶段对question字段中的token进行编码。具体的计算方法需要根据您使用的训练机器学习算法或模型来确定。

例如,在使用PyTorch训练BERT模型时,可以使用PyTorch的nn.functional.logical_or函数来对bertindex_knowledge字段的每一位进行逻辑或操作,从而得到每个question字段中的token是否与table schema中的某些关键字或关键信息有链接关系的结果

在训练数据集中,bertindex_knowledge 字段是一个与 question 等长的二进制序列,每一位表示 question 中的标记是否与表格模式具有链接。具体来说,如果标记在表格模式中具有链接,则相应的位设置为 1,否则设置为 0。

这个二进制序列通常是通过将 question 中的标记与表格模式进行链接来计算的。链接通常是通过将标记映射到表格模式中的列来实现的。如果标记与表格模式中的列有链接,则该标记在该列上具有一个实体链接,例如,"John" 可能在 "name" 列上具有链接,"age" 可能在 "age" 列上具有链接。如果标记没有与表格模式中的列有链接,则该标记在该列上没有实体链接。

在计算 bertindex_knowledge 字段时,通常使用一个二元组表示标记和列之间的链接关系。例如,对于一个包含三列的表格模式,如果标记 "John" 与 "name" 列有链接,标记 "30" 与 "age" 列有链接,则可以将这个二元组表示为 [("John", "name"), ("30", "age")]。然后,可以使用这个二元组来计算 bertindex_knowledge 字段。例如,如果 question 中包含两个标记 "John" 和 "30",则可以将 bertindex_knowledge 字段设置为 [1, 0, 1]。

因此,bertindex_knowledge 字段不是一个向量,而是一个二进制序列。每个二进制位表示 question 中的标记是否与表格模式中的列有链接。

bertindex_knowledge 字段是一个二进制数组,长度与 question 中的 token 数量相同,每一位表示该 token 是否与 table schema 中的某一列存在 linking。具体来说,如果一个 token 在 table schema 中的某一列出现,则对应位置的值为 1,否则为 0。

这个二进制数组不是向量,是一个确定长度的数组,每一位表示一个特定的含义。这个数组信息是通过文本匹配的方法计算出来的,将 question 中的每一个 token 与 table schema 中的每一列进行相似度计算,如果相似度高于一定阈值,则认为两者存在 linking。具体的相似度计算方法可以是基于词向量的余弦相似度,也可以是基于字符串匹配的 jaccard 相似度等。

在训练数据集中,BERT index_knowledge字段和问题之间并不是对应的关系。每一位表示BERT模型中的一个token是否与表格的schema有关联。这意味着,在训练数据中,每个问题可能包含多个token,而一个token只能和一个表格的schema有关联。因此,BERT index_knowledge字段和问题之间不是一一对应的关系。

在训练数据集中,BERT模型学习到了每个单词在文本中的上下文信息,包括它前面和后面的单词,以及单词所在的句子的上下文信息。这些信息可以用来辅助理解文本,因此可以将BERT模型的输出作为特征来训练模型,例如使用BERT模型的输出作为一个向量来表示每个单词和问题之间的关系。这个向量可以用于模型的fine-tune过程中,用于表示每个问题和相应的token的关系。

根据您提供的信息,训练数据集中的bertindex_knowledge字段是一个与question等长的序列,用于表示question中的每个token是否与表格schema中的列名或内容存在联系。具体来说,bertindex_knowledge序列中每个元素的取值可能是以下两种情况之一:

0: 表示question中对应的token与表格schema中的列名或内容没有联系。 1: 表示question中对应的token与表格schema中的列名或内容存在联系。 bertindex_knowledge序列的计算过程是由预处理过程实现的。在预处理过程中,首先需要将表格schema中的列名和内容进行编码,并通过BERT模型将自然语言问题question进行编码。然后,可以使用一些启发式规则或基于相似度的方法来计算question中的每个token与表格schema中的列名或内容之间的联系。具体来说,可能会考虑使用词向量的相似度、编辑距离、正则表达式等方法来计算联系。

最后,将计算得到的bertindex_knowledge序列添加到训练数据集中,用于训练表格问答模型。

需要注意的是,bertindex_knowledge序列本身并不是一个向量,而是一个由0和1组成的序列。在模型训练和推理过程中,可以将bertindex_knowledge序列作为额外的输入特征,与BERT编码的自然语言问题question一起输入模型中。模型可以利用这些额外的输入特征来更好地理解自然语言问题和表格schema之间的联系,从而提高表格问答的准确率。

在训练数据集中,"bertindex_knowledge"字段是一个与"question"字段等长的数组,用于表示问题中的每个token是否与表格架构(table schema)中的列名或值相关联。具体来说,如果某个token与表格架构中的某个列名或值相关联,则该位置上的值为1;否则,该位置上的值为0。

这些值是作为二进制标记计算得出的,因此它们不是向量,而只是由0和1组成的一维数组。这些标记是通过匹配表格架构中的列名称和值与问题中的每个token进行计算的。如果表格架构中的列名称或值在问题中出现,则对应的标记为1,否则为0。

需要注意的是,这些标记是由人工创建的,并不是通过自动化方式生成的。因此,在使用这些数据训练模型时,需要确保模型能够正确理解这些标记的含义。

bertindex_knowledge 字段是一个与 question 等长的二进制向量,其中每一位表示 question 中的一个 token 是否与 table schema 中的某个列名或列类型相匹配。这个向量的值是通过在训练数据集中对每一个 question 的每一个 token 进行处理得到的。

具体来说,对于每个 token,会在 table schema 中的所有列名和列类型中查找是否包含该 token,如果包含则将对应的位置设为1,否则设为0。这样就得到了一个二进制向量,表示该 question 中每个 token 是否与 table schema 相关联。