哈罗,魔搭上api调用的方式有这几种哈:1 部分模型支持了社区的提前部署,且可以调用,如:https://modelscope.cn/models/damo/nlp_structbert_word-segmentation_chinese-base-ecommerce/summary

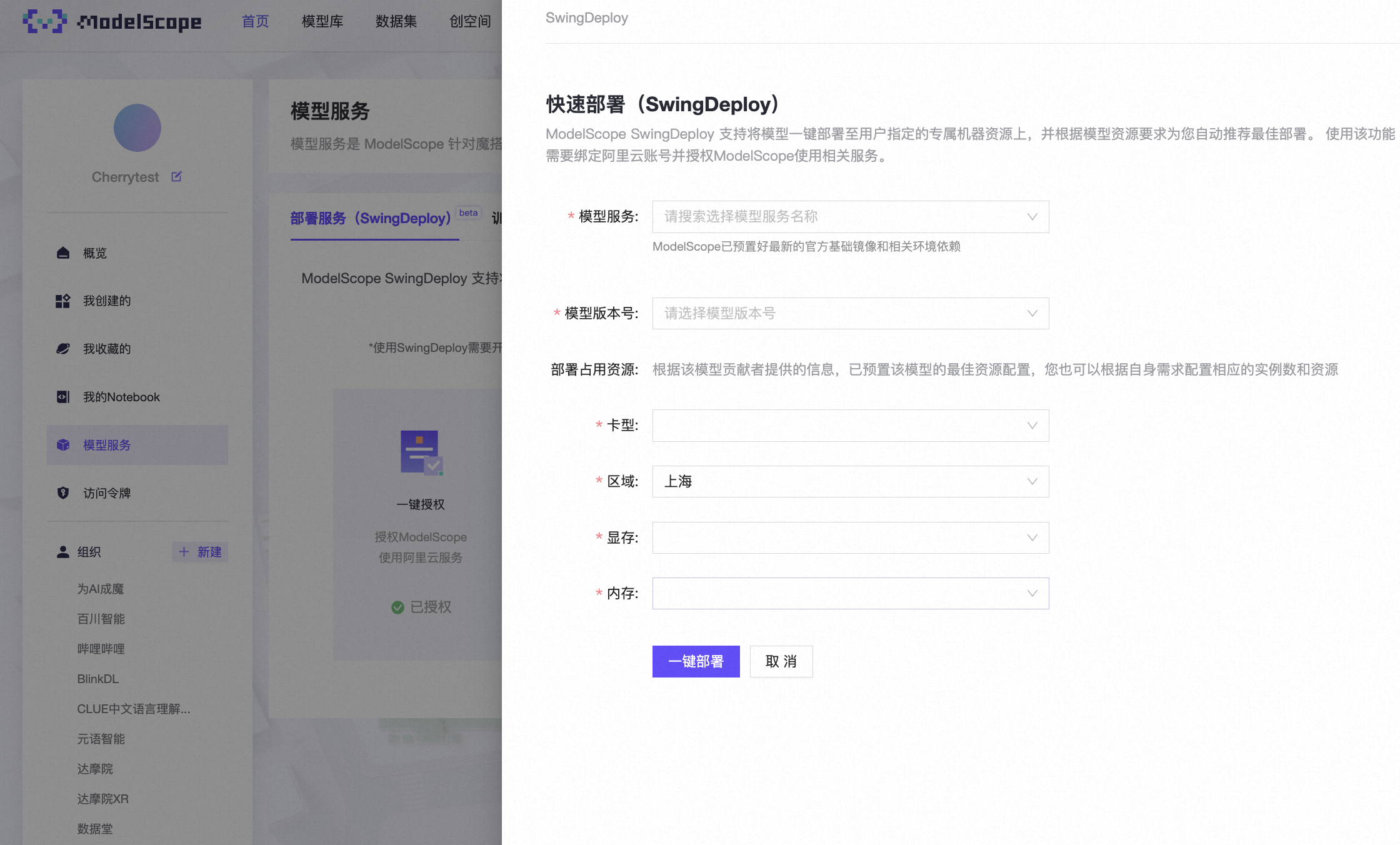

2 部分模型支持了可以在魔搭上用swingdeploy部署到阿里云函数服务:https://modelscope.cn/my/modelService/deploy-此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

ModelScope魔搭是一个用于模型部署和Serving的工具,可以将训练好的模型部署为API服务。你可以使用API调用来与已部署的模型进行交互。

一旦你使用ModelScope魔搭成功部署了模型,并启动了服务,你就可以通过HTTP或其他适当的通信协议发出API请求,以向模型发送输入并接收输出。

以下是使用ModelScope魔搭部署的模型的一般步骤:

部署模型:使用ModelScope魔搭的命令行工具或API,将模型部署为一个服务。这将在指定的主机和端口上启动一个服务器,准备接收API请求。

发送API请求:使用HTTP客户端(如Python的requests库)或其他适当的工具,向ModelScope部署的模型发送API请求。请求通常包括待处理的输入数据,以及其他任何参数或标志,具体取决于你的模型和任务需求。

处理API响应:解析模型返回的API响应,提取出预测结果或其他感兴趣的信息。响应的格式可能是JSON、图像文件、文本等,具体取决于你的模型和配置。

ModelScope 是一个开源的深度学习模型管理和部署平台,可以帮助用户管理、部署和使用深度学习模型。虽然 ModelScope 可以通过 REST API 提供一些基本的功能,例如模型部署和推理请求,但它并不是一个完整的 API 管理平台,也不是一个专门用于提供 API 服务的平台。

如果您需要构建一个 API 服务,并使用深度学习模型进行推理,可以考虑以下几种方法:

使用 Flask 或 Django 等 Web 框架:您可以使用 Python 的 Web 框架,例如 Flask 或 Django,来构建一个 API 服务。在服务中,您可以加载和使用深度学习模型,接收请求并返回推理结果。这种方法需要您自己编写代码,并处理模型加载、请求处理、结果返回等问题。

使用 TensorFlow Serving 或 ONNX Runtime:您可以使用 TensorFlow Serving 或 ONNX Runtime 等深度学习推理引擎,来构建一个 API 服务。这些推理引擎可以在后台加载和管理模型,接收请求并返回推理结果。这种方法相对较为简单,但需要您将模型保存为 TensorFlow 或 ONNX 格式,并配置推理服务。

使用云服务平台:如果您不想自己搭建 API 服务,可以考虑使用云服务平台,例如 AWS、Azure 或 Google Cloud。这些平台提供了各种深度学习服务和 API,可以帮助您快速构建和部署深度学习模型。