请教一下各位大佬,flinkcdc在读取数据同步到另一个数据库的时候,一些update的操作是如何保

请教一下各位大佬,flinkcdc在读取数据同步到另一个数据库的时候,一些update的操作是如何保证顺序的呢?例如用户下了一笔订单,但是还没给钱,数据库此时生成了一条订单数据,状态是未支付,然后用户给钱了,update成已支付,再然后用户取消订单了,订单数据update成取消,flinkcdc是如何保证这种数据update的顺序性呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

Flink CDC(Change Data Capture)是一种用于捕获和传递数据库变更的技术。在Flink CDC中,为了保证数据的顺序性,通常会使用数据库的binlog(二进制日志)来捕获变更,并按照binlog的顺序进行处理。

当有多个操作同时发生时,Flink CDC会按照binlog中的顺序将这些操作进行排序,并按顺序进行处理。对于上述的订单示例,Flink CDC会按照用户下单、支付、取消的顺序处理。这意味着在读取和同步到另一个数据库时,Flink CDC会确保按照这个顺序进行更新操作,以保证数据的一致性。

一般来说,Flink CDC会基于binlog的时间戳进行排序,确保按照事件发生的时间先后顺序进行处理。此外,Flink CDC还可能使用事务信息或其他相关信息来确保数据的顺序性。

需要注意的是,Flink CDC的顺序性是相对于单个数据库实例而言的。如果有多个数据库实例在进行变更操作,并且这些实例的binlog流可能存在延迟或乱序的情况,那么在进行数据同步时可能需要额外的处理来确保全局的顺序性。

2023-08-27 07:57:04赞同 展开评论 -

十分耕耘,一定会有一分收获!

楼主你好,在 flinkcdc 中,update 操作的顺序性是由 CDC (Change Data Capture) 技术保证的。CDC 技术是一种数据操作捕获技术,能够实时的捕获源数据库的数据操作日志(如 binlog),并将其转化成结构化的数据格式,以方便其他系统读取和处理。

在 flinkcdc 中,CDC 技术会获取源数据库的 binlog,将其解析成数据格式,然后将这些数据发送到目标数据库。当源数据库发生一个 update 操作时,CDC 技术会将其解析成一个两步操作(delete 和 insert),并按照先前的数据操作顺序先处理 delete 操作,再处理 insert 操作,以保证数据的顺序性。

因此,在 flinkcdc 中,可以通过 CDC 技术保证数据的顺序性,即先处理旧数据的 delete 操作,再处理新数据的 insert 操作,从而保证了数据的正确性。

2023-08-21 15:27:19赞同 展开评论 -

在 Flink CDC 中,保证数据更新操作的顺序性是一个重要的问题。Flink CDC 通过以下机制来处理并保证数据更新操作的顺序性:

分区和排序:Flink CDC 通常会将源数据库中的表按照某种策略进行分区,并确保每个分区的数据都由同一个任务处理。这样可以保证同一分区内的数据被顺序处理。

按事件时间或处理时间进行排序:Flink CDC 可以根据事件时间或处理时间对输入流进行排序,确保后续的操作按照正确的时间顺序执行。这样可以避免事件乱序导致的数据更新顺序混乱。

状态管理和一致性检查点:Flink CDC 使用状态管理来跟踪和维护当前处理的状态。它会将每次数据更新的结果保存到状态中,并定期进行一致性检查点(checkpoint),以确保状态的持久性和一致性。

并发控制和事务处理:Flink CDC 可以通过控制并发度和事务处理来保证数据更新的原子性和一致性。当多个更新操作同时进行时,Flink CDC 会使用锁机制或事务隔离级别来处理并发冲突,以保证数据更新的顺序性。

需要注意的是,尽管 Flink CDC 会尽力保证数据更新操作的顺序性,但在某些情况下,由于并行处理和异步机制的存在,可能无法完全保证绝对的顺序性。在设计应用程序时,需要根据具体业务需求来评估和处理潜在的顺序问题,并采取适当的措施来解决或减轻这些问题。

2023-08-16 19:54:23赞同 展开评论 -

flinkcdc保证update操作的顺序性是通过读取binlog日志来实现的。每个binlog里的操作记录都是有序的,flinkcdc会按照binlog的顺序进行数据同步。

对于订单的例子,假设订单下单时间是t1,用户支付时间是t2,用户取消时间是t3。在binlog日志里,订单生成的操作记录肯定是早于支付和取消的记录,所以flinkcdc会先同步订单生成的操作记录,再同步支付和取消的记录。这样就可以保证顺序性,即先把订单状态从"未支付"变成"已支付",再把订单状态从"支付"变成"已取消"。

2023-08-15 10:05:34赞同 展开评论 -

某政企事业单位安全运维工程师,主要从事系统运维及网络安全工作,多次获得阿里云、华为云、腾讯云征文比赛一二等奖;CTF选手,白帽,全国交通行业网络安全大赛二等奖,全国数信杯数据安全大赛银奖,手握多张EDU、CNVD、CNNVD证书,欧盟网络安全名人堂提名,联合国网络安全名人堂提名

Flink CDC通过读取源数据库的binlog(对于MySQL)或者write-ahead log(对于PostgreSQL)来获取数据变更信息。这些日志中的事件是按照它们在源数据库中发生的顺序进行记录的。因此,Flink CDC可以按照日志中的顺序来处理这些事件,保证了对同一行数据的更新操作能够按照正确的顺序执行。

当然,为了实现这一点,你需要确保Flink任务的并行度为1,或者对于同一行的数据更新操作,它们在被分配到不同的并行子任务进行处理时,使用的keyBy函数能够生成相同的key。

如果你需要高并行度并且希望保持操作的顺序性,你可能需要根据具体情况设计适当的水位策略和时间戳提取器,以便在事件时间语义下处理数据流。这样可以允许Flink在处理乱序事件时,仍然能够保证结果的准确性。

2023-08-15 07:25:49赞同 展开评论 -

北京阿里云ACE会长

在 Flink CDC 中,为了保证数据同步的顺序性和一致性,可以采取以下措施:

使用有序的数据源:对于需要保持顺序的数据同步场景,可以选择使用有序的数据源作为 Flink CDC 的输入。例如,可以使用有序的 CDC 工具(如 Canal)或有序的消息队列(如 Kafka)作为 Flink CDC 的数据源。这样可以确保数据在进入 Flink CDC 之前已经按照顺序进行了排序。

使用 Flink 的事件时间(Event Time):Flink 支持事件时间处理,可以根据事件的时间戳对数据进行排序和处理。你可以在 Flink CDC 中使用事件时间,确保按照事件发生的顺序对数据进行处理。可以通过设置适当的水位线(Watermark)策略来处理可能存在的乱序事件。

使用 Flink 的状态管理:Flink 提供了强大的状态管理机制,可以用于维护和管理数据的状态。在 Flink CDC 中,你可以使用状态来存储和跟踪每个订单的状态变化。当接收到一个新的订单更新时,你可以将其与当前状态进行比较,并采取适当的操作来保持顺序。

使用单线程处理:在 Flink 的任务配置中,你可以将任务的并行度设置为1,即只使用单个任务线程进行处理。这样可以确保所有的数据都按照顺序进入和处理,避免并行处理引起的乱序问题。

2023-08-14 19:23:39赞同 展开评论 -

在 Flink CDC 中,更新操作的顺序是通过读取 binlog 来保证的。当 MySQL 数据库中的表发生更新时,MySQL 会将这些更新操作记录在 binlog 中。Flink CDC 会从 binlog 中读取这些更新操作,并按照其在 binlog 中出现的顺序进行处理。

在 Flink CDC 中,每个 binlog event 都包含了一个时间戳和一个唯一标识。Flink CDC 会使用这些信息来保证更新操作的顺序。具体来说,Flink CDC 会将 binlog event 按照时间戳和唯一标识进行排序,然后依次处理每个 binlog event。这样就可以保证更新操作的顺序是正确的。

需要注意的是,如果有多个更新操作同时发生在同一行数据上,那么它们的顺序可能会受到数据库的锁机制影响。在这种情况下,Flink CDC 可能无法保证更新操作的顺序。因此,在使用 Flink CDC 进行数据同步时,建议尽量避免同时对同一行数据进行多个更新操作。

2023-08-14 16:17:07赞同 展开评论

2023-08-14 16:17:07赞同 展开评论 -

Flink CDC 通过订阅数据库的 binlog 或 redo log 来捕获增量变更,并将其转化为流式数据进行处理。在处理过程中,Flink CDC 会保持事件的顺序性,以确保正确地反映数据库中的变更操作。

对于你提到的订单状态的更新操作,Flink CDC 会按照事件发生的顺序来处理它们。也就是说,在 Flink CDC 接收到这些更新操作的时候,它们会按照它们在 binlog 或 redo log 中的顺序被处理。

Flink CDC 会为每个表维护一个增量变更的顺序。当它接收到一个更新操作时,它会将该操作应用到内部状态中的相应记录上。因此,如果用户下了一笔订单、支付了订单,然后取消订单,Flink CDC 会按照这个顺序处理这些操作,并确保最终状态与数据库中的顺序一致。

需要注意的是,Flink CDC 的顺序保证是基于 binlog 或 redo log 的顺序。如果数据库本身使用了多实例、多分片或异步复制等特性,可能会导致实际顺序与 binlog 或 redo log 不完全一致。在这种情况下,你可能需要进行额外的处理来确保顺序的一致性。

另外,Flink CDC 还提供了可靠性保证机制,如开启 Exactly-Once 模式或启用事务支持。这些机制可以帮助进一步保证数据的顺序性和一致性。

2023-08-14 16:09:25赞同 展开评论 -

全栈JAVA领域创作者

Flink CDC在读取数据同步到另一个数据库时,是通过追踪源数据库中的binlog事件来实现数据同步的。对于您提到的订单数据的更新顺序问题,Flink CDC可以通过以下方式来保证数据更新的顺序性:

首先,Flink CDC会追踪源数据库中所有的binlog事件,并将这些事件按照时间顺序进行排序。这样,Flink CDC就可以保证同一时间产生的binlog事件是按照时间顺序进行处理的。

其次,Flink CDC会在处理每个binlog事件时,将其与前一个binlog事件进行比较。如果当前binlog事件的操作类型与前一个binlog事件的操作类型相同,则Flink CDC会将当前binlog事件的操作类型设置为“update”,并将前一个binlog事件的操作类型设置为“insert”。这样,Flink CDC就可以保证同一类型的操作是按照时间顺序进行处理的。

最后,Flink CDC会在处理每个binlog事件时,将其与前一个binlog事件的操作状态进行比较。如果当前binlog事件的操作状态与前一个binlog事件的操作状态不同,则Flink CDC会将当前binlog事件的操作状态设置为“update”,并将前一个binlog事件的操作状态设置为“insert”。这样,Flink CDC就可以保证同一状态的操作是按照时间顺序进行处理的。

综上所述,Flink CDC可以通过追踪源数据库中的binlog事件、按照时间顺序进行排序、比较操作类型和操作状态等方式来保证数据更新的顺序性。2023-08-14 12:57:13赞同 展开评论

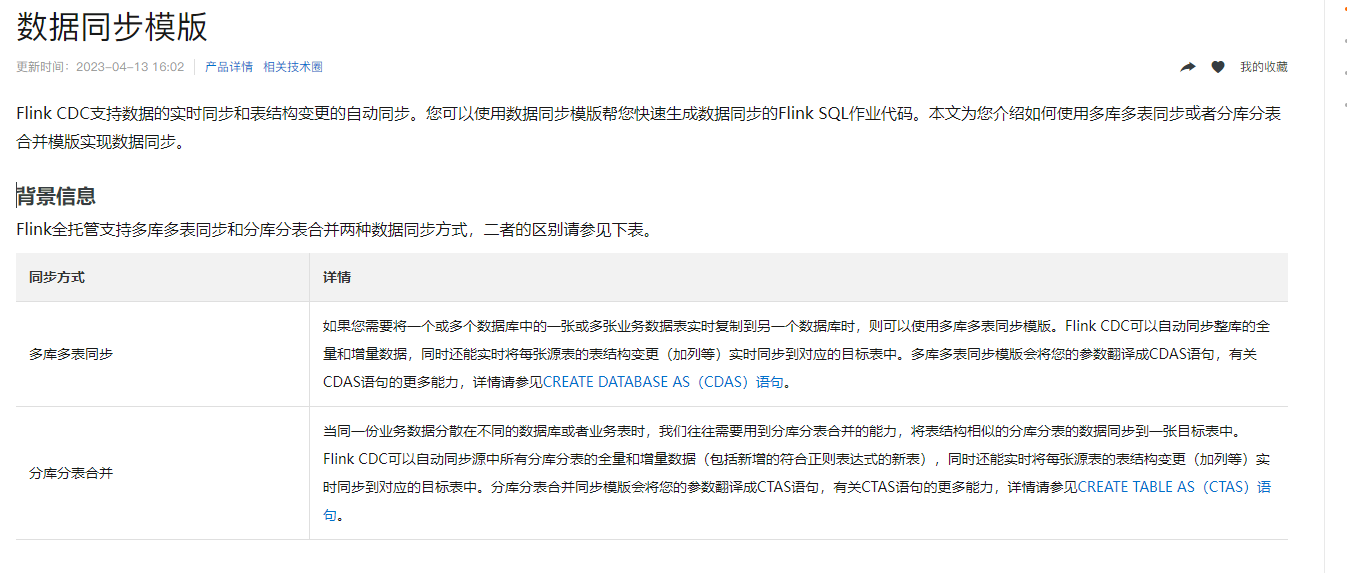

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。