版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个问题的原因可能有很多,下面提供几种可能的解决方案:

1.检查 Hadoop 集群是否正常工作,可以尝试通过 Hadoop Shell 进行连接测试。

2.检查 Hudi 配置参数是否正确,包括 Hudi 表的路径、操作类型、ROWKEY 和 SCHEMA 等。

3.检查 Flink 环境变量配置是否正确,例如 HA 环境下的 Hadoop 配置、Zookeeper 配置等。

4.检查网络连接是否正常,例如 Hadoop 集群和 Flink 集群之间是否能够互相访问。

可能会出现这种问题,具体原因可能是由于网络配置或权限问题导致无法连接到Hadoop集群。建议检查网络配置和权限设置,并确保使用正确的用户名和密码连接到Hadoop集群。另外,还可以尝试重新启动Hadoop集群并重新连接。

在将 Flink 应用程序与 Hudi 集成过程中出现 Hadoop 拒绝连接的原因可能是以下几种:

1、版本冲突:Hudi 和 Flink 在使用 Hadoop 的时候,需要保证它们使用的 Hadoop 版本一致。如果 Hudi 和 Flink 使用了不同版本的 Hadoop,可能会导致 Hadoop 拒绝连接。您可以检查 Flink 和 Hudi 使用的 Hadoop 版本是否一致,并尝试解决版本冲突问题。

2、Hadoop 安全模式:在 Hadoop 中,有一个安全模式(Safe Mode),它会在某些情况下启动,如:HDFS 的块复制数小于最小块副本数、HDFS 服务启动过程中等等。当 Hadoop 处于安全模式时,可能会导致 Hadoop 拒绝连接。您可以检查 Hadoop 是否处于安全模式,并等待 Hadoop 退出安全模式后重试。

3、Hadoop 配置文件错误:Hadoop 的连接配置文件可能存在错误或配置不完整,也可能导致 Hadoop 拒绝连接。您可以检查 Flink、Hudi 和 Hadoop 的配置文件,确保它们都正确配置了 Hadoop 连接参数。

4、Hadoop 服务未启动:如果 Hadoop 服务未启动,则会导致 Hadoop 拒绝连接。您可以检查 Hadoop 的各项服务是否正常运行,并确保 Flink 应用程序和 Hudi 应用程序可以访问 Hadoop 服务。

5、防火墙问题:如果您的服务器上启用了防火墙,可能会导致防火墙拒绝 Flink 和 Hudi 对 Hadoop 进行连接。您可以尝试关闭防火墙,或者配置防火墙允许 Flink 和 Hudi 对 Hadoop 的连接。

确认 Hadoop 集群的网络状态和配置情况,例如 IP 地址、端口号等是否正确设置。

确认 Flink 和 Hudi 的版本是否兼容,以及各种依赖库是否正确导入。

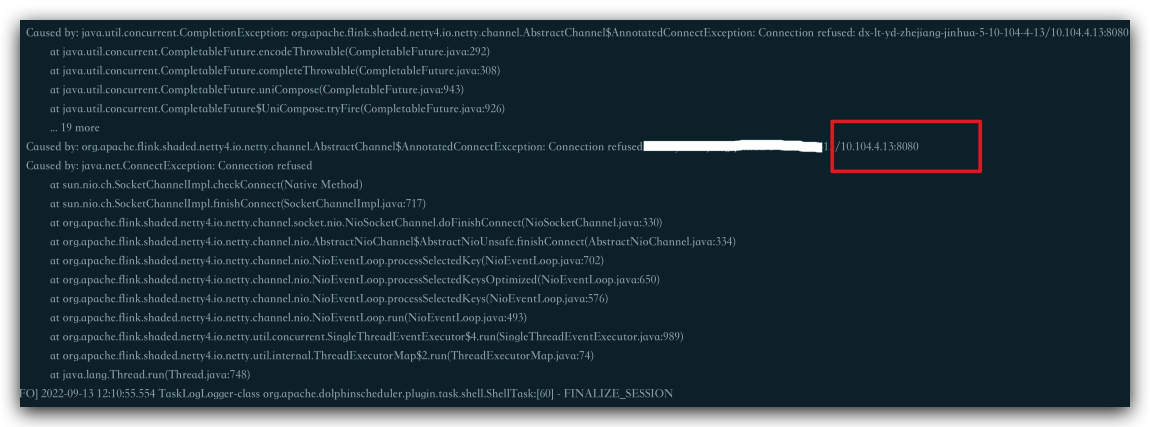

查看运行时日志,查找错误的详细信息,并对错误进行逐一排除。

尝试重启 Hadoop 集群和 Flink 应用程序,以消除可能存在的缓存或状态问题。

如仍无法解决问题,请尝试搜索相关技术博客或官方文档,或者向社区中的专家寻求帮助。

如果遇到了Hadoop和Flink连接失败的问题,可以尝试按照以下步骤解决:

确认 Hadoop 集群和 Flink 集群的网络配置是否正确。比如:确认 hostname 是否解析正确,确认端口是否正确开放等。

确认 Hadoop 集群和 Flink 集群之间的防火墙是否已经正确配置,或者是否需要在防火墙中开放端口。

确认 Hadoop 和 Flink 集群之间使用的 Hadoop 版本是否兼容,版本不兼容时可能会导致连接失败。

确认 Hadoop 集群的HA是否正确配置,以及 Flink 是否可以正确解析 Hadoop 的HA配置。

尝试使用 curl、telnet 或者 nc 等工具测试 Hadoop 和 Flink 之间的网络是否畅通。

确认 Flink 集群是否有足够的权限访问 Hadoop 集群中的文件系统。

确认 Hadoop 集群中的 NameNode、DataNode、ResourceManager、NodeManager 等相关服务是否正常运行。

如果还是无法解决问题,可以通过查看 Hadoop 的 logs 和 Flink 的 logs 获取更多信息,定位问题。

如果在使用 Flink 写 Hudi 时,出现 Hadoop 拒绝连接的问题,可能是由于以下原因导致的:

Hadoop 集群配置错误 Hudi 是在 Hadoop 生态系统上构建的分布式数据存储及管理框架,因此在使用 Hudi 之前,需要先搭建好 Hadoop 集群。如果 Hadoop 集群配置错误,例如未正确设置节点、端口号等参数,就会导致 Hadoop 拒绝连接。

要解决此问题,可以检查 Hadoop 集群的配置是否正确,并根据实际情况进行相应的调整和优化。可以参考 Hadoop 官方文档或相关教程,了解有关 Hadoop 集群的配置和安装方法。

网络配置错误 Hadoop 集群通常需要使用特定的网络配置,例如需要在每个节点之间配置好主机名、IP 地址等信息。如果网络配置错误,就会导致 Hadoop 拒绝连接。

要解决此问题,可以检查网络配置是否正确,并确保所有节点之间能够互相访问。可以使用 ping 命令测试网络连接性,并根据实际情况进行相应的调整和优化。

安全权限不足 Hadoop 集群通常需要设置一些安全权限措施,例如 Kerberos 认证、访问控制列表(ACL)等。如果安全权限不足,就会导致 Hadoop 拒绝连接。

要解决此问题,可以检查 Hadoop 集群的安全权限设置是否正确,并确保 Flink 程序具有足够的访问权限。可以参考 Hadoop 官方文档或相关教程,了解有关安全权限的设置和管理方法。

总之,在使用 Flink 写 Hudi 时,如果出现 Hadoop 拒绝连接的问题,需要仔细检查 Hadoop 集群的配置、网络配置和安全权限等方面的问题,并进行相应的调整和优化,以提高任务的可靠性和性能。

这个问题可能是由于 Hadoop 的配置不正确导致的。一般情况下,Hadoop 的配置文件会包含一些网络相关的参数,例如 Hadoop 集群节点的 IP 地址、端口号等。如果这些参数配置不正确,就可能导致连接被拒绝的错误。

解决方法如下:

检查 Hadoop 配置文件中的网络相关参数是否正确,例如 core-site.xml、hdfs-site.xml、yarn-site.xml 等配置文件。

检查 Flink 程序中访问 Hadoop 的配置是否正确,例如 Hadoop 客户端的配置文件路径、Hadoop 集群节点的 IP 地址和端口等。

检查网络是否正常工作,例如是否存在防火墙、是否存在网络拓扑问题等。

检查 Hadoop 和 Flink 的版本是否匹配,如果版本不匹配也可能导致连接被拒绝的错误。

如果以上方法都无法解决问题,可以尝试重启 Hadoop 和 Flink 程序,或者重新部署 Hadoop 和 Flink 环境。

楼主你好,根据你的错误提示可以知道,是因为Hadoop和flink连接出错造成的,你可以排查一下Hadoop是否可以正常运行,然后flink关于Hadoop的配置是否正确,大概率是因为配置的问题,请认真排查一下即可。

这种错误通常是由于Hadoop服务不可用或连接不到造成的。您可以检查以下几点:

确认Hadoop服务是否正常运行,检查日志或使用hadoop fs -ls命令测试。

检查您的Flink配置中是否指定了正确的Hadoop配置文件路径,并且文件是否存在。

确认您的Flink任务运行的用户是否有足够的权限访问Hadoop服务,例如HDFS等。

检查您的网络连接是否正常,确保可以从Flink节点访问到Hadoop服务节点。

如果上述方法都无法解决问题,您可以考虑重新配置Hadoop服务或使用其他方式进行数据写入操作。

这个问题可能是由于 Hadoop 的安全配置引起的。

首先,你需要确认你的 Flink 程序是否正确地配置了相应的 Hadoop 配置文件。如果没有配置,则无法连接到 Hadoop 集群。可以使用以下命令来测试 Hadoop 是否正常启动:

hadoop fs -ls / 如果该命令能够返回 Hadoop 集群的根目录内容,则表明 Hadoop 正常启动并且可以连接。如果无法连接,则需要检查 Flink 程序所在的机器是否可以访问到 Hadoop 集群,并且防火墙设置是否允许连接。

其次,如果你的 Hadoop 集群启用了安全模式,那么需要配置 Flink 程序的身份验证信息,以便连接到 Hadoop 集群。具体方式为在 Flink 程序中设置以下 Hadoop 参数:

-Dfs.defaultFS=hdfs://: -Ddfs.nameservices= -Ddfs.client.failover.proxy.provider.=org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider -Dhadoop.security.authentication=kerberos -Dhadoop.security.authorization=true 其中, 是 Hadoop 集群中主 NameNode 的 IP 地址或域名, 是主 NameNode 的 RPC 服务端口号; 是 Hadoop 集群的逻辑名称,需要与 core-site.xml 中配置的 dfs.nameservices 属性相同。

最后,如果你的 Hadoop 集群启用了 Kerberos 认证,那么需要在 Flink 程序中设置 Kerberos 相关参数,并且配置 Kerberos Keytab 文件和 Principal。具体方法可以参考 Hadoop 和 Flink 的文档,以及相关的安全配置示例。

这种问题通常是由于 Flink 和 Hadoop 之间的通信问题导致的。以下是一些可能的解决方案:

确保 Flink 和 Hadoop 都已正确安装和配置。可以通过在命令行中输入 bin/flink run 或 bin/hadoop fs 来检查它们是否已正确安装和配置。 确保 Flink 和 Hadoop 之间的通信协议已正确设置。Flink 和 Hadoop 之间的通信协议是 Hadoop 分布式文件系统(HDFS) 和 Flink 之间的 API。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。