问个问题,我的Flinkcdc已经跑通了,可以监听msql的binlog了,也能发送kafka消费了,但是我要怎样把这个东西部署呢。是需要在linux上搭一个Flink吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

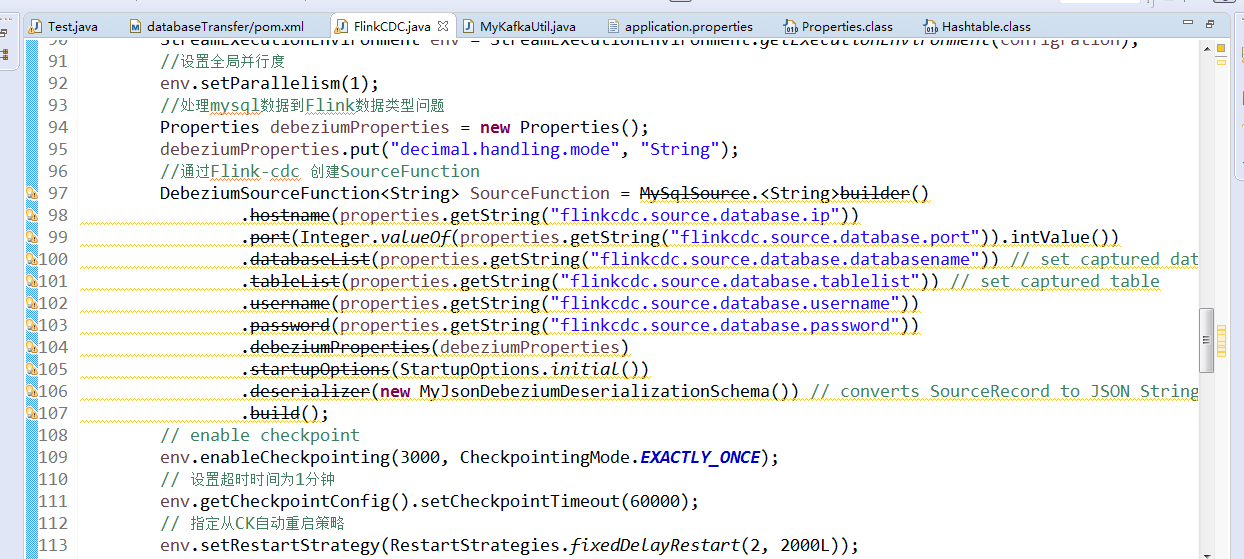

为了部署您的Flink CDC作业,确实需要在Linux服务器上搭建Apache Flink环境。以下是部署的基本步骤和注意事项:

准备Linux服务器:

下载并安装Flink:

/opt/flink。配置Flink:

conf/目录下),主要涉及flink-conf.yaml。这可能包括设置JobManager和TaskManager的内存大小、并行度等。打包Flink作业:

启动Flink集群:

./bin/start-cluster.sh脚本快速启动单机集群,或者按照官方文档指引配置高可用集群。提交和运行作业:

./bin/flink run -c com.yourcompany.YourJobClassName /path/to/your-job.jar命令来提交作业。日志与监控:

维护与升级:

请记得,具体操作时还需结合您的实际环境和需求进行适当调整。希望以上步骤能帮助您顺利完成Flink CDC作业的部署工作。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。