异构计算如何适用于人工智能?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

人工智能的发展经历了多个阶段,最近一次的爆发从 2010 年开始。这一次人工 智能的爆发主要受到三个重要因素的影响 :算法、数据和计算力。其中计算力是桥 梁、也是引擎,是人工智能最终能够真实地被应用于社会生活的方方面面的重要推动 因素。纵观现有的人工智能产业,异构计算技术随处可见,GPU、FPGA 和 ASIC 在 这个领域内可谓龙争虎斗、各放异彩。

先说 GPU 云服务器,其卓越的浮点运算能力能够在大吞吐的训练场景中大幅缩 短 AI 深度学习模型的训练时间,从之前在 CPU 上的几周优化到几天甚至几个小时。 GPU 还支持单机多卡的高速通信,在 8 个 GPU 的场景下,通过 GPU NVLink 技术, 在多块 GPU 之间共享计算能力和存储单元,实现更强大的处理能力、更加快速的响 应,从而在 AI 深度学习的推理场景下满足低时延响应的业务要求。例如,在图像识 别应用中,利用 GPU 可以极大地提高图像识别服务中离线模型训练和在线识别的效 率,吞吐量相比主流的 Xeon CPU 服务器可以提高数十倍。图 3-24 展示了使用阿里 云 GPU 云服务器搭建的图像识别应用架构,已广泛应用于社交网站的图片鉴别领域。

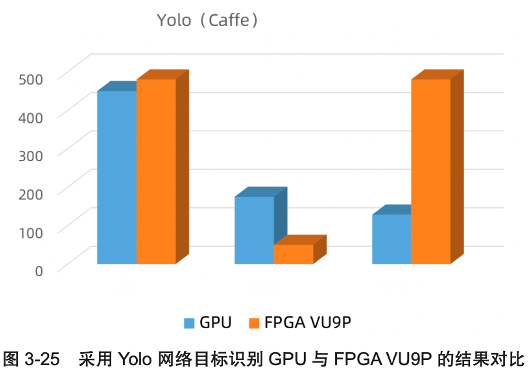

FPGA 云服务器能运行支持 Caffe、TensorFlow、PyTorch、MXNet 等框架的应 用,在阿里云的实践中发现,对于特定的网络框架及模型,FPGA 在推理侧往往显示 出了惊人的性价比。比如采用 Yolo 网络目标识别 GPU 与 FPGA VU9P 的结果对比如 图 3-25 所示。

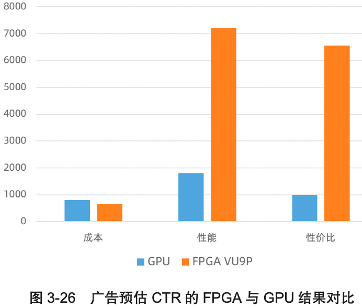

对比业务方原始方案采用的 GPU,采用 FPGA 在精度几乎没有损失的前提下, TCO 只相当于 GPU 的约 1/3。另一个例子是广告预估 CTR,也有非常突出的性价比 优势,广告预估 CTR 的 FPGA 与 GPU 结果对比如图 3-26 所示。

需要说明的是,如果采用性能更为强大的 GPU,虽然 GPU 的性能会大幅上升, 但是同时意味着成本的大幅上升,那么结果就是性价比对比大致不变,FPGA 的优势 无可争议。

而基于 ASIC 的人工智能芯片,天生就是用于人工智能场景的,其计算力更加惊 人。以阿里巴巴在 2019 年云栖大会上发布的含光 800 芯片为例,在杭州城市大脑的 业务测试中,1 颗含光 800 的算力相当于 10 颗 GPU。

《弹性计算:无处不在的算力》电子书可以通过以下链接下载:https://developer.aliyun.com/topic/download?id=7996"