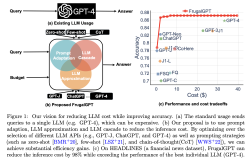

在人工智能领域,大型语言模型(LLM)的快速发展推动了自然语言处理技术的革新与应用。然而,这些模型通常具有巨大的参数量和高昂的计算成本,这给它们的训练和应用带来了挑战。为了解决这一问题,微软提出了一种名为SliceGPT的模型压缩方法,特别适用于参数量庞大的LLAMA-2模型。通过删除权重矩阵中的行和列,SliceGPT在保持模型性能的同时,大幅减少了模型的计算需求,从而显著提高了计算效率。

传统的模型压缩技术包括蒸馏、张量分解、剪枝和量化等方法,这些方法可以在一定程度上减少模型的计算需求。然而,许多方法需要在剪枝后进行恢复微调以保持性能,这增加了成本且难以扩展。相比之下,SliceGPT方法无需额外的微调即可在生成和下游任务中保持有竞争力的性能。

SliceGPT的核心思想是利用Transformer架构中的计算不变性,通过删除权重矩阵的整行或整列来降低网络的嵌入维度,从而实现模型的压缩。这种方法的独特之处在于,它不仅能够有效地减少模型的参数量,还能够保持模型的性能,使其在实际应用中更具有竞争力。

通过对LLAMA-2 70B、OPT 66B 和 Phi-2 模型的实验,发现SliceGPT可以为这些模型去除多达25%的模型参数,同时保持模型的零样本任务性能。经过SliceGPT处理的模型在WikiText-2数据集和Alpaca数据集上取得了良好的性能表现,表明了其在压缩大型语言模型方面的有效性和可行性。在实际应用中,这将为模型的训练和部署带来重大的效益,降低了成本,提高了效率。

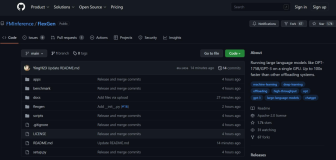

研究人员表示,有了SliceGPT,他们只需几个小时就能使用单个GPU压缩大型模型,即使没有恢复微调,也能在生成和下游任务中保持有竞争力的性能。此外,经过SliceGPT处理的模型可以在更少的GPU上运行,而且无需任何额外的代码优化即可更快地运行。这不仅提高了模型的计算效率,还加速了模型的应用和推广过程。