Flink cdc3.0.1,oracle11,在源库首次插入数据的时候报错怎么办?

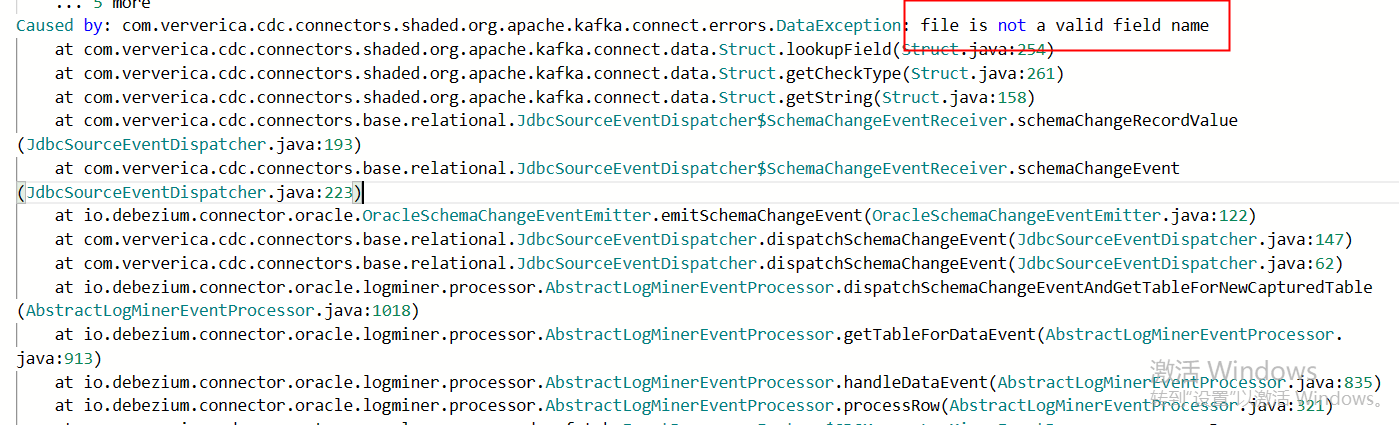

Flink cdc3.0.1,oracle11,在源库首次插入数据的时候,目标库正常插入了数据,但第二条源库数据插入的时候,就报这个Caused by: com.ververica.cdc.connectors.shaded.org.apache.kafka.connect.errors.DataException: file is not a valid field name,目标库没相应字段了,有朋友遇到过类似问题么? 只同步一张表,用来测试增删改查的同步,是不是增删改查的时候有没有什么操作限制?

只同步一张表,用来测试增删改查的同步,是不是增删改查的时候有没有什么操作限制?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

热门讨论

热门文章

FlinkCDC MySQL 中 scan.startup.mode 用的是什么模式啊?

1825

Flink这个未授权访问漏洞有什么解决方案吗?

509

Flink CDC有遇见这个问题的吗?

488

flink1.15启动后无法访问webui的问题有人遇到过吗

9815

Flink sql将数组炸开,实现hive的explode函数的效果,还有什么其他好的方式?

422

Caused by: org.apache.kafka.common.errors.TimeoutE

2238

阿里云实时计算的资源单位是什么?

3628

yarn集群资源是充足的,为什么提交任务失败呢

741

flink怎么能够快速消费kafka数据,需要设置什么参数呢?

315

Flink CDC中我使用了自定义聚合函数,但是报错这个需要怎么解决呢?

355

展开全部

数据仓库介绍与实时数仓案例

40217

权威详解 | 阿里新一代实时计算引擎 Blink,每秒支持数十亿次计算

22152

分布式Snapshot和Flink Checkpointing简介

18966

实时计算 Flink SQL 核心功能解密

18558

Flink SQL 功能解密系列 —— 维表 JOIN 与异步优化

26211

阿里云实时计算产品案例&解决方案汇总

24893

流计算精品翻译: The Dataflow Model

18542

Flink SQL 功能解密系列 —— 流式 TopN 挑战与实现

15927

基于实时计算(Flink)打造一个简单的实时推荐系统

13869

广告场景下的实时计算

10909

展开全部