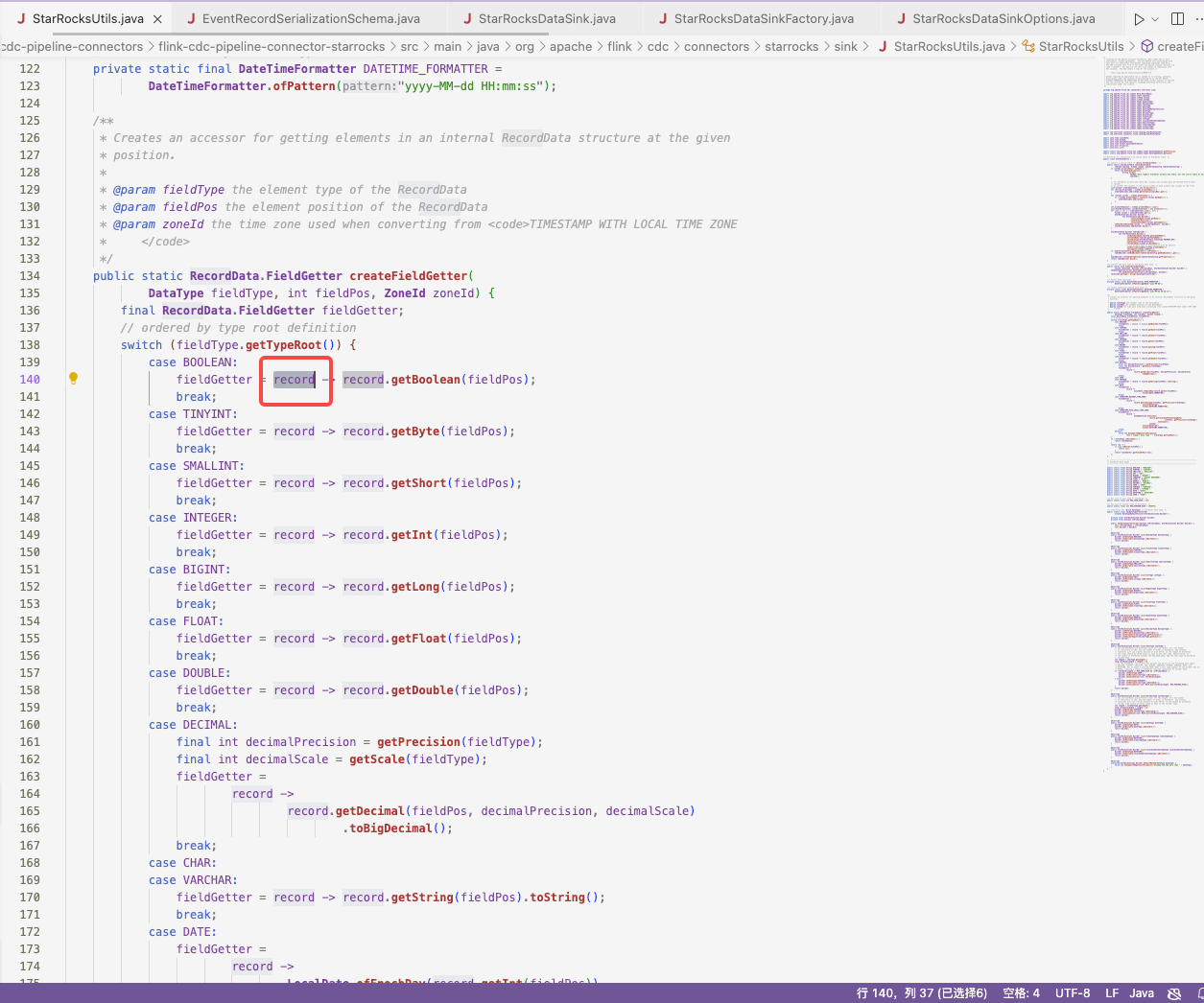

在 看 flinkcdc的代码, 这个 record 对象是从哪里传入的?

在 看 flinkcdc的代码, java 小白请教个问题, 这个 record 对象是从哪里传入的,没找到在哪里定义的。 https://github.com/apache/flink-cdc/blob/release-3.0/flink-cdc-connect/flink-cdc-pipeline-connectors/flink-cdc-pipeline-connector-starrocks/src/main/java/com/ververica/cdc/connectors/starrocks/sink/StarRocksUtils.java 。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在分析您提到的 record 对象时,我们需要结合 Flink CDC 的代码逻辑以及其运行机制来理解。以下是详细的解答:

1. record 对象的来源

在 Flink CDC 中,record 对象通常是通过数据流(DataStream)从上游的 Source 端传递到下游的 Sink 端的。具体来说,record 是由 Flink CDC 的 Source 连接器生成的变更数据捕获(CDC)事件,包含了数据库的变更信息(如插入、更新、删除等操作)。这些事件会被封装为 Flink 的数据记录,并传递给下游的处理逻辑。

在您提到的代码文件中:

flink-cdc-pipeline-connector-starrocks/src/main/java/com/ververica/cdc/connectors/starrocks/sink/StarRocksUtils.java

record 对象的具体定义和传入方式需要结合上下文分析。通常情况下,record 是通过 Flink 的 SourceFunction 或 SourceReader 生成的,并通过 Flink 的 DataStream API 传递到 Sink 端。

2. Flink CDC 的数据流机制

Flink CDC 的核心是基于 Debezium 或其他 CDC 工具捕获数据库的变更日志(如 MySQL 的 Binlog 或 PostgreSQL 的 WAL 日志),并将这些变更日志解析为结构化的事件流。以下是数据流的关键步骤:

-

Source 端:

- Flink CDC 的 Source 连接器会读取数据库的变更日志。

- 每条变更日志会被解析为一个

ChangeEvent对象,包含以下信息:- 数据库表名

- 变更类型(INSERT、UPDATE、DELETE)

- 变更前后的数据(Before 和 After 数据)

-

数据传输:

- 这些

ChangeEvent对象会被封装为 Flink 的Record对象,并通过 DataStream API 传递到下游。

- 这些

-

Sink 端:

- 在 Sink 端(如 StarRocks Sink),

record对象会被进一步处理并写入目标存储系统。

- 在 Sink 端(如 StarRocks Sink),

3. record 对象的定义

在 Flink CDC 的代码中,record 对象通常是一个实现了 Flink 的 org.apache.flink.streaming.api.functions.sink.SinkFunction.Context 接口的对象。它的具体定义取决于 Source 端的实现。

例如,在 MySQL CDC 的实现中,record 对象可能是 com.ververica.cdc.connectors.mysql.source.MySqlSource 生成的 ChangeEvent 对象。而在 PostgreSQL CDC 的实现中,record 对象可能是 com.ververica.cdc.connectors.postgres.source.PostgresSource 生成的类似对象。

在您提到的 StarRocksUtils.java 文件中,record 对象的具体定义可能需要查看调用该方法的上下文代码。通常,record 是通过 Flink 的 DataStream API 传递的,例如:

stream.addSink(new StarRocksSinkFunction());

在这里,StarRocksSinkFunction 的 invoke 方法会接收 record 对象。

4. 如何定位 record 的定义

如果您想进一步定位 record 的定义,可以按照以下步骤进行:

-

查找调用链:

- 查看

StarRocksUtils.java文件中record对象的使用位置。 - 找到调用该方法的类或函数,通常是一个 SinkFunction 的实现类。

- 查看

-

追踪 Source 端:

- 查看 Flink 作业的 Source 配置,确定使用的 CDC 连接器(如 MySQL CDC 或 PostgreSQL CDC)。

- 根据连接器的实现,找到

record对象的生成逻辑。

-

参考社区文档:

- 如果您使用的是社区版 Flink CDC,可以参考其官方文档或源码注释,了解

record对象的具体结构和生成方式。

- 如果您使用的是社区版 Flink CDC,可以参考其官方文档或源码注释,了解

5. 重要提醒

- 版本差异:不同版本的 Flink CDC 可能在

record对象的定义和处理上存在差异。请确保您查看的代码与实际使用的 Flink CDC 版本一致。 - 调试建议:如果无法直接定位

record的定义,可以通过在代码中添加日志(如System.out.println(record))来观察其内容和结构。

总结

record 对象是由 Flink CDC 的 Source 连接器生成的变更数据事件,通过 Flink 的 DataStream API 传递到 Sink 端。在您提到的 StarRocksUtils.java 文件中,record 的具体定义需要结合调用链和 Source 端的实现来分析。建议从调用该方法的上下文代码入手,逐步追踪 record 的来源和定义。

如果您能提供更多上下文代码或调用链信息,我可以进一步帮助您精确定位 record 的定义和传入方式。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。