老师们有用flink消费过mq的嘛,我自定义了一个,本地是一直在消费,集群上直接进入FINISHED状态了,现在mq里没数据?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink Standalone RocketMQ 消费过程中,可以开启 Flink 的 Checkpoint 机制,确保每个消息都能被正确处理并保存。示例代码如下:

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(5000); // 每 5 秒进行一次 Checkpoint

env.getCheckpointConfig().setCheckpointTimeout(30000); // 设置 Checkpoint 超时时间为 30 秒

——参考链接。

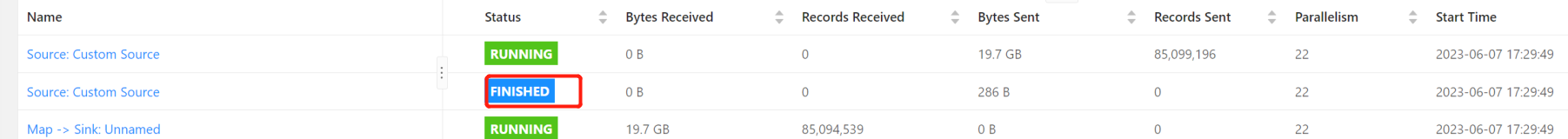

从截图来看,似乎是在 Apache Flink 应用程序中遇到了问题。在这个场景中,有一个名为 Custom Source 的源函数处于 FINISHED 状态,而不是预期的 RUNNIG 状态。这意味着 Custom Source 函数已经完成了其处理过程并停止接收来自外部的消息流。然而,下游的操作符 Map -> Sink 却依然处在RUNNING状态,继续消耗着大量的数据。

这种现象通常表明 Custom Source 消费的数据源头发生了变化,可能是MQ队列里的数据已经被全部读取完毕,或是其他未知的因素导致 Custom Source 停止了数据获取与发送流程。

为了找到根本原因,可以从以下几个方向入手:

调查 Custom Source 是否能稳定持续地从 MQ 获取到数据。如果是的话,为什么会出现数据耗尽呢?

检查是否有其他消费者也在消费同一个 MQ 队列,从而导致数据提前被清空;

检查 Custom Source 实现代码逻辑,确保它可以无限循环地从 MQ 接收数据;

在Apache Flink中消费MQ(例如RocketMQ、RabbitMQ、Kafka等)时,如果在集群环境下消费作业直接进入了FINISHED状态,而本地环境却能正常持续消费,可能存在以下几种原因:

集群资源配置不足:

确认集群中分配给Flink任务的资源是否足够,包括但不限于内存、CPU等,若资源不足以启动或维持消费进程,任务可能会快速结束。

消费任务逻辑问题:

检查自定义的消费逻辑是否含有会导致任务立即结束的条件。例如,任务启动时进行了数据的即时消费,但在集群环境下由于某些原因(如配置、MQ连接问题等)没有接收到数据,导致任务逻辑认为任务已完成从而主动退出。

MQ连接与配置:

确保集群环境下的MQ连接参数正确无误,包括但不限于地址、主题、消费组、凭证等。特别是在分布式环境下,有时候网络配置或环境变量可能会影响到连接的建立。

无数据待消费:

你说集群上MQ里没有数据,这可能是任务快速结束的一个直接原因。当MQ队列中没有待消费的消息时,Flink任务可能会立即完成,尤其是在任务没有设置循环或长轮询的情况下。

Checkpoint与状态保存:

如果Flink任务开启了checkpoint,而上次checkpoint后就没有新数据产生,Flink可能会认为任务已完成状态恢复而直接进入FINISHED状态。

Flink作业生命周期管理:

检查Flink作业的提交参数,确保在集群环境下作业配置正确,没有设置一次性消费或只消费有限数量的消息等特殊参数。

集群与本地环境差异:

确认集群环境与本地环境的Flink版本、依赖库以及其他配置是否完全一致,有时环境差异可能导致任务行为不一致。

可以尝试以下方法来解决:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。