探索云世界

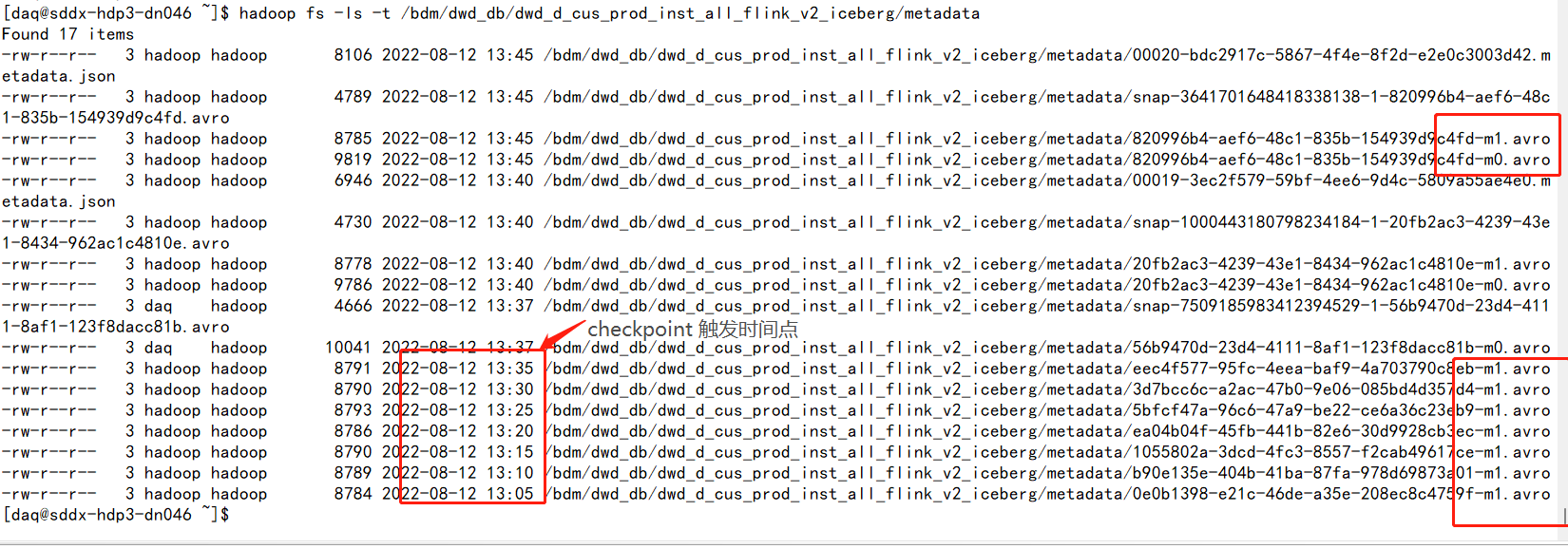

各位大佬 咨询一下,利用spark produres 进行iceberg 小文件合并后,进行快照删除,为什么每个checkpoint时间点,都会留下一个m1.avro 哪? m1.avro 与m0.avro 啥区别那?

在使用Spark Producer进行Iceberg小文件合并后,如果需要进行快照删除,可以使用Spark的Checkpoint API和Spark的数据备份机制进行操作。 首先,在进行Iceberg小文件合并后,可以使用Spark的SharedRDD API将数据从源RDD中同步到Spark的一个标准RDD中。然后,可以使用Spark的Checkpoint API对该标准RDD进行快照删除,即保存当前RDD中的所有数据到磁盘上的快照文件中。 对于m1.avro和m0.avro,它们是两个不同的二进制文件,分别保存了数据的快照版本。其中,m1.avro是指数据快照文件中最新的版本,而m0.avro是指数据快照文件中的第一个版本。 在进行数据快照删除时,可以使用以下命令将数据快照文件中的数据删除:

Copy code spark.sql("DROP DATABASE IF EXISTS dbname;") spark.sql("DROP TABLE IF EXISTS dbname.table_name;") 其中,dbname为需要删除的数据库名称,table_name为需要删除的数据表名称。 在删除数据快照文件后,可以使用Spark的数据备份机制将数据恢复到原始的RDD中,即数据还原。对于数据还原,可以使用以下命令:

Copy code spark.sql("CREATE DATABASE IF NOT EXISTS dbname;") spark.sql("CREATE TABLE IF NOT EXISTS dbname.table_name (col1 INT, col2 STRING, col3 DOUBLE);") 其中,dbname为需要还原的数据库名称,table_name为需要还原的数据表名称。 在进行数据还原后,可以使用Spark的SharedRDD API将数据从新的RDD中同步回到数据源中。然后,可以使用Spark的Producer API将数据重新发送到目标数据源中。 因此,在使用Spark Producer进行Iceberg小文件合并后,如果需要进行快照删除,可以使用Spark的Checkpoint API和Spark的数据备份机制进行操作,以满足不同的业务需求。如果出现了不能正确删除数据的情况,可以查看Spark日志,或者联系Spark客服进行咨询和解决问题。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。