实验背景介绍

了解更多2017云栖大会·成都峰会 TechInsight & Workshop.

本手册为云栖大会Workshop之《在线用户行为分析:基于流式计算的数据处理及应用》场的《实时数据分析:海量日志数据多维透视》篇所需。主要帮助现场学员熟悉并掌握阿里云数加·分析型数据库AnalyticDB的操作和使用。

实验涉及大数据产品

前提准备

必备条件:确保已经获取到实验所需的阿里云账号和密码。

创建AnalyticDB表

通过DMS创建AnalyticDB数据表可以通过可视化建表和SQL窗口建表两种模式。

1.可视化建表

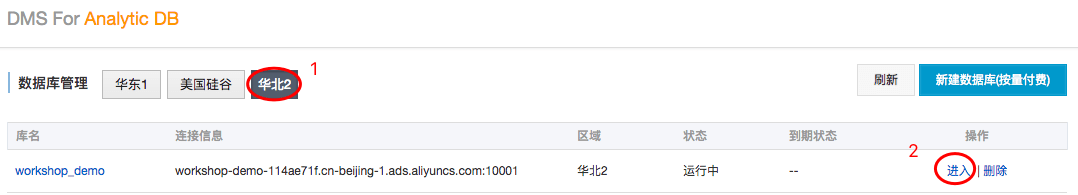

- step1:进入DMS for AnalyticDB并使用阿里云账号进行登录。

- step2:选择进入区域华北2,继而点击操作栏中的进入,进入workshop_demo数据库。

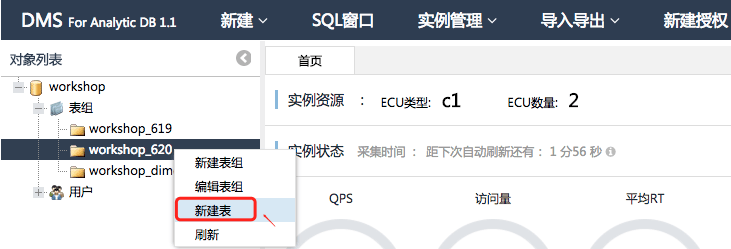

- step3:根据自己获取的阿里云账号后三位数字选择进入对应表组。

【说明】如当前云账号为train00620@aliyun-inc.com,那么选择进入表组workshop_620。

- step4:右键对应的表组,选择新建表进入可视化创建表模式。

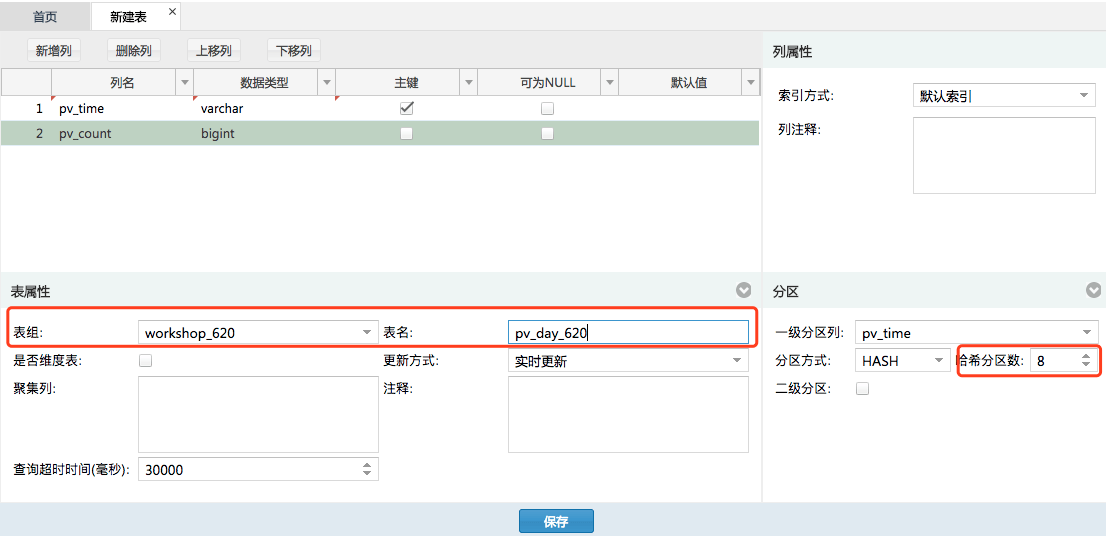

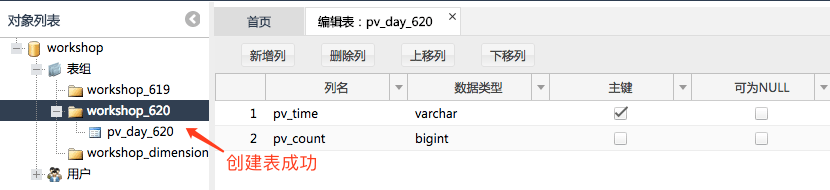

- step5:配置表名、字段名称、数据类型、主键,选择对应表组、一级分区列和更新方式,如下图所示。

其中表组选择自己云账号对应的表组,一级分区列选择为pv_time,分区方式中的哈希分区数为8.

在表属性中表组选择自己账号所对应的表组,表名为pv_abc(abc同为账号后三位数字),如pv_day_620。因为表名在同一个AnalyticDB数据库中应全局唯一。

- step6:在新建表页面底部,点击保存按钮。

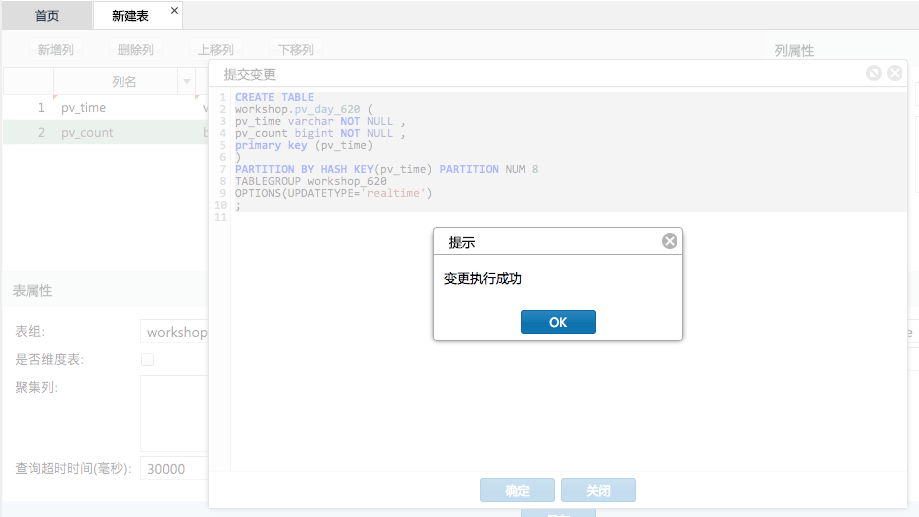

- step7:在提交变更弹出框中点击确定按钮,直至提示“变更执行成功”,如下图。

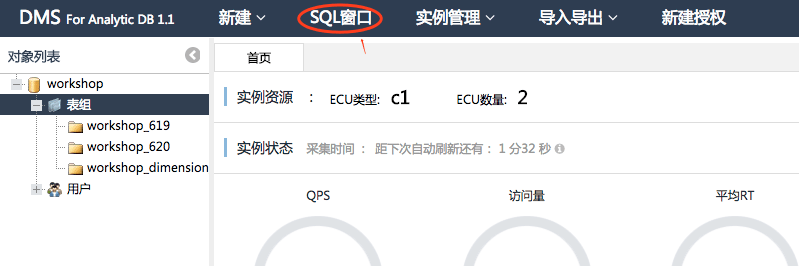

2.通过SQL窗口创建表

也可以通过DDL模式创建天浏览量pv的表,pv_day_abc(同上,abc为账号后三位数字)。

- step1:点击顶部菜单栏中的SQL窗口,进入DDL模式。

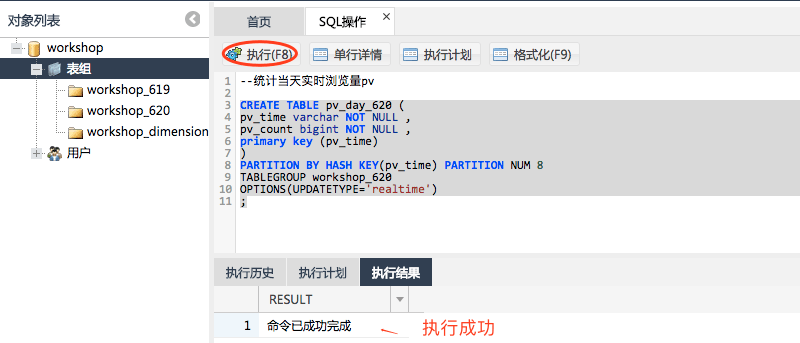

- step2:在SQL窗口中依次复制并执行如下SQL代码。

建表SQL如下:(其中需要注意自己的表名、一级分区列以及建表所属的表组tablegroup属性。)

--统计当天实时浏览量pv

CREATE TABLE pv_day_620 (

pv_time varchar NOT NULL ,

pv_count bigint NOT NULL ,

primary key (pv_time)

)

PARTITION BY HASH KEY(pv_time) PARTITION NUM 8

TABLEGROUP workshop_620

OPTIONS(UPDATETYPE='realtime')

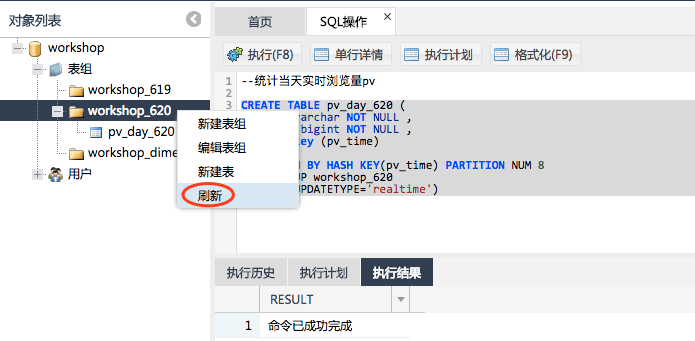

;- step3:右键对应的表组,选择刷新查看已经创建成功的表。

由于时间关系,关于区域访问量、按照小时统计浏览量、按设备统计浏览量和统计请求来源量的建表将不在此进行动手操作,但是讲师会给大家讲解。workshop结束后,会将所有指标统计过程的代码开发给大家进行体验。

>>>点击进入《流数据处理:通过StreamSQL分析用户行为》篇