问题一:dataworks怎么同步oss这样的数据?

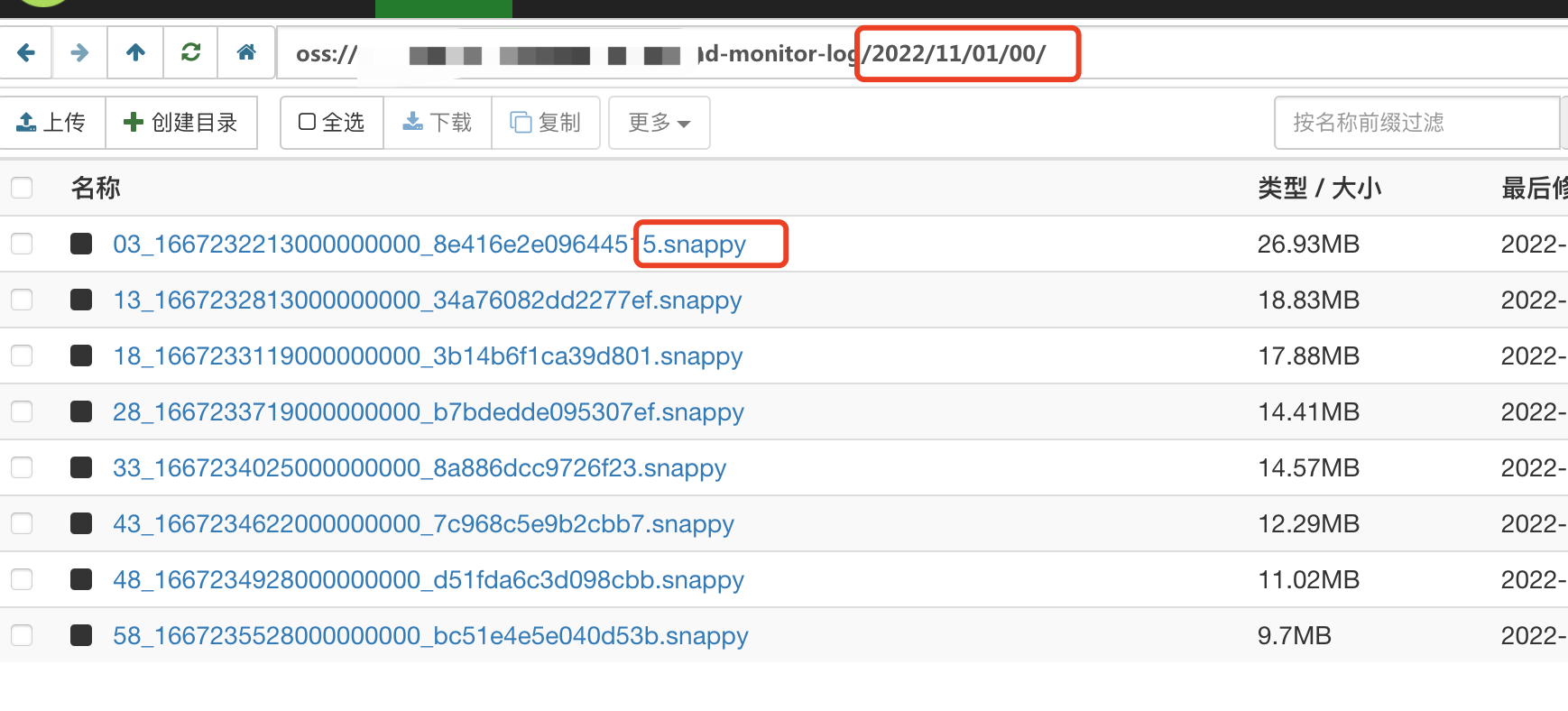

dataworks怎么同步oss这样的数据?路径是日期到小时的,然后下面有N个snappy归档压缩后的文件?

参考回答:

参考看下

https://help.aliyun.com/zh/dataworks/user-guide/oss-data-source?spm=a2c4g.11186623.0.i1#task-2311246

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/570140

问题二:dataworks提供的产品服务有哪些?

dataworks提供的产品服务有哪些?

参考回答:

DataWorks提供的产品服务包括:

- 数据集成:主要用于离线/实时数据同步,提供复杂网络下、丰富的异构数据源之间高速稳定的数据移动及同步能力。

- 数据开发:对MaxComputer中的数据进行加工、分析与挖掘等处理。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/570139

问题三:DataWorks阿里云有没有流批一体的产品?

DataWorks阿里云有没有流批一体的产品?

参考回答:

是的,DataWorks阿里云提供了流批一体的产品。DataWorks是一种一体化的大数据开发和治理平台,可以帮助企业实现数据的实时处理和离线处理,支持流式计算和批量计算的混合模式,从而实现流批一体的数据处理能力。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/570138

问题四:DataWorks首次数据同步全量到maxcompute,如何重新写到数据原本的业务日期的分区?

DataWorks首次数据同步全量到maxcompute,如何重新写到数据原本的业务日期的分区?

参考回答:

在初次使用DataWorks从Hive向MaxCompute进行全量同步时,可以选择指定一个初始日期作为全量的时间边界,并将该日期前后的数据分别写入不同的分区,具体步骤如下:

- 创建一个脚本文件,使用MapReduce函数实现对Hive表中的数据进行分桶操作,并根据业务日期字段划分不同的桶,分别写入MaxCompute的不同分区。

- 将上述脚本文件提交给DataWorks进行调度执行,实现全量数据同步至MaxCompute的目标分区。

- 设置定时任务,定期执行该脚本文件,实现增量数据同步,并自动将新的增量数据写入正确的MaxCompute分区。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/570137

问题五:DataWorks怎么对Rest API类型的数据源进行编码设置?

DataWorks怎么对Rest API类型的数据源进行编码设置?

参考回答:

目前看没有类似参数设置 是有什么问题吗 https://help.aliyun.com/zh/dataworks/user-guide/restapi-data-source?spm=a2c4g.11186623.0.i1#task-2315045

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/570135