启动Hadoop主要包括以下几个步骤:

- 确保Hadoop环境变量已配置:在启动Hadoop之前,需要确保Hadoop的环境变量已经配置好。在~/.bashrc或~/.bash_profile文件中添加以下内容:

export HADOOP_HOME=/path/to/your/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export YARN_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

请将/path/to/your/hadoop替换为实际的Hadoop安装路径。

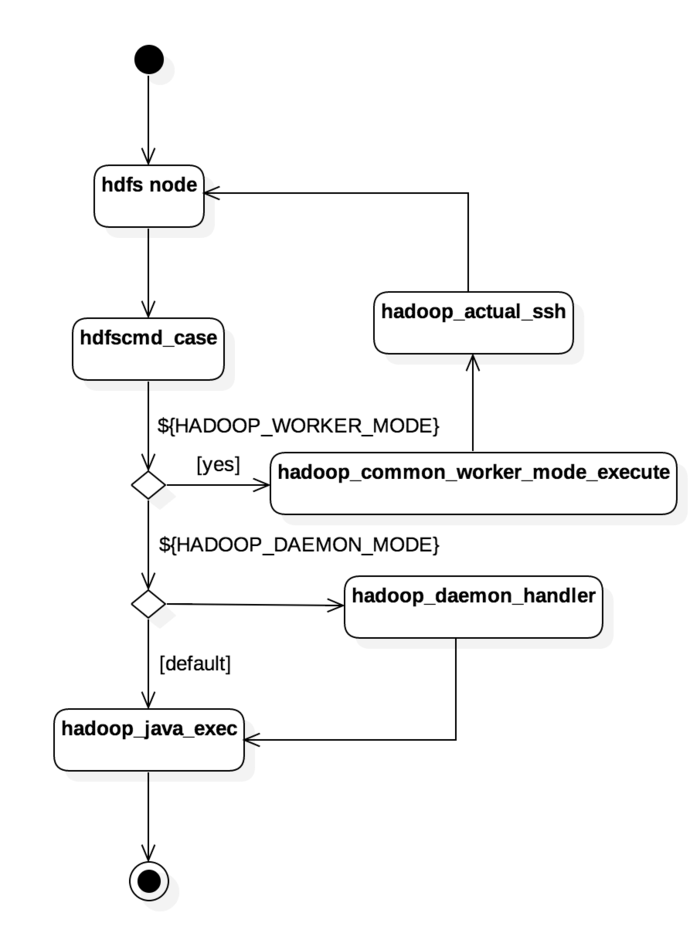

- 启动Hadoop:使用以下命令启动Hadoop,其中start-dfs.sh用于启动HDFS,start-yarn.sh用于启动YARN(如果使用的是Hadoop 2.x及更高版本):

$HADOOP_HOME/bin/start-dfs.sh

$HADOOP_HOME/bin/start-yarn.sh

- 验证Hadoop:

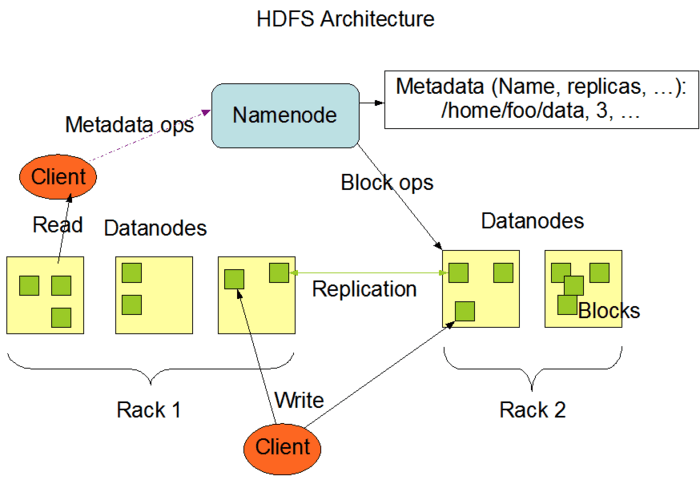

- 验证HDFS:执行hdfs dfsadmin -report命令,查看HDFS的状态报告。如果看到类似于以下的输出,说明HDFS已成功启动:

NameNode Address: node1:9000/192.168.1.100:9000

DataNode Addresses: node1:50010/192.168.1.100:50010,node2:50010/192.168.1.101:50010

Number of DataNodes: 2

Number of副本: 3

- 验证YARN:执行yarn application -list命令,查看当前运行的应用。如果看到输出,说明YARN已成功启动。

此外,还可以通过访问Hadoop的Web界面来验证Hadoop是否成功启动。默认情况下,Hadoop的Web界面位于

http://:50070。在浏览器中输入该地址,如果能看到Hadoop的Web界面,说明Hadoop已成功启动。