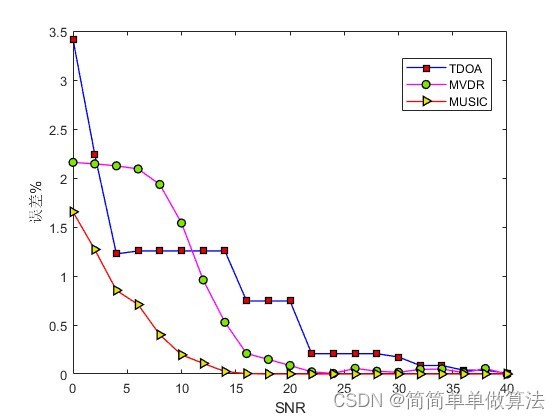

1.算法运行效果图预览

2.算法运行软件版本

MATLAB2022a

3.算法理论概述

声源定位算法是阵列信号处理领域中最为关键的技术之一,其具有诸多应用场景,如语音识别领域、视频通信领域、安全监控领域等[01]。而基于阵列信号的声源定位技术,其主要通过预先安装在某一平面区域或者某一空间区域中的阵列接收设备(如麦克风阵列)对声源信号进行接收,然后根据相关信号处理方法对接收信号中的有效信号进行增强,对无效信号进行抑制,最后通过声源定位算法获得声源的空间坐标。目前,技术上较为成熟的定位算法,比较常见的主要包括基于时延估计(Time Difference of Arrival,TDOA)的定位法,基于最小方差无失真响应(Minimum Variance Distortionless Response,MVDR)的定位法以及基于多信号分类(Multiple Signal Classification,MUSIC)的定位法。

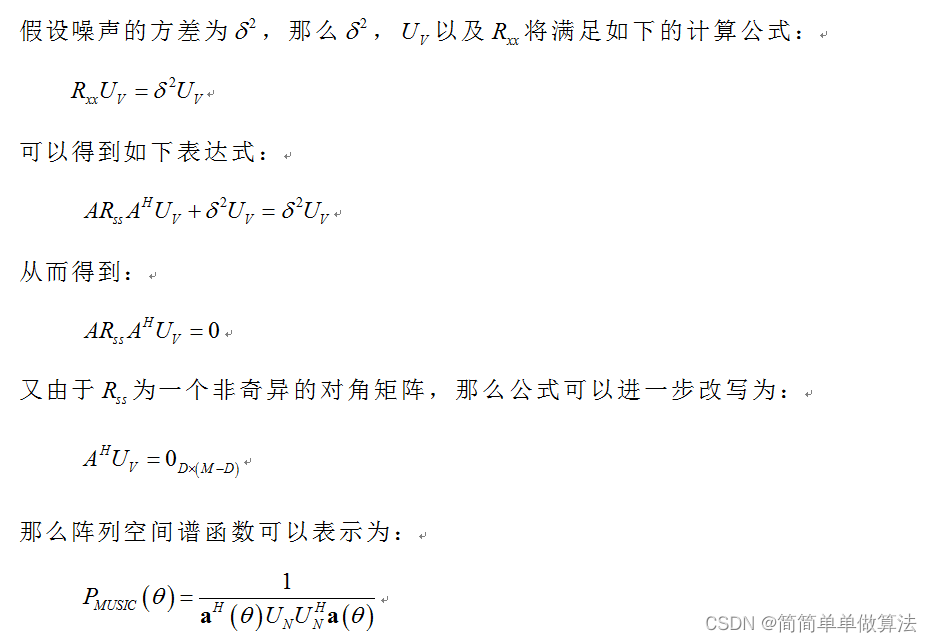

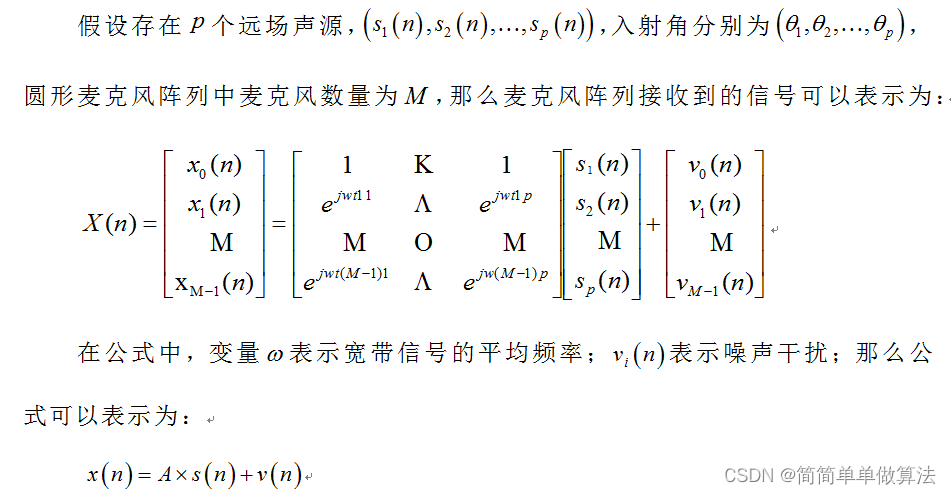

3.1 MUSIC(Multiple Signal Classification)

MUSIC 是一种基于频谱分析的高分辨率定位算法。其核心思想是通过计算信号在不同方向上的空间谱来实现多信号分离和定位。MUSIC算法最早是由Schmidt等人在1967年提出的,MUSIC算法是一种高分辨率谱估计算法[11]。基于MUSIC的声源定位算法,其首先根据麦克风阵列接收得到的信号计算对应的协方差矩阵,然后对协方差矩阵进行特征分解得到信号子空间和噪声子空间,最后根据谱峰搜索算法对空间谱矩阵进行搜索,其中最大值峰值所对应的角度即为信号的方位角估计值。但是MUSIC算法主要是针对窄带信号进行处理的,而声音信号通常为带宽信号,因此在进行MUSIC算法进行处理之前,首先对接收到的信号进行短时分帧处理,将连续的声音信号转换为长度较短的帧信号。然后针对这些帧数据进行后续处理。下面对基于MUSIC算法的声源定位算法的基本原理进行介绍。

3.2 MVDR(Minimum Variance Distortionless Response)

MVDR 算法旨在最小化定位误差的方差,从而提高定位精度。

数学公式:

3.3 TDOA(Time Difference of Arrival)

TDOA 算法通过测量信号到达不同阵列元素的时间差来估计源信号的方向。

4.部分核心程序

```for ii=1:length(SNR);

ii

for jj = 1:500

NUM_zy = 6; % 阵元个数

samples = 12;% 采集信号的数量

theta = [24];

NUM_signal = length(theta); % 信号个数

A = zeros(NUM_zy,NUM_signal);

for m=1:NUM_signal

thetam = theta(m)pi/180;%将角度转换为弧度制

A(:,m) = exp(jpisin(thetam)(0:NUM_zy-1)); % 导向矢量

end

Sn = randn(NUM_signal,samples)+jrandn(NUM_signal,samples);

Vn = randn(NUM_zy,samples)+jrandn(NUM_zy,samples);

% xt = ASn+Vn;%xt就是实际接收到的信号数据,

xt = awgn(ASn,SNR(ii),'measured');

Rx = (xtxt')/samples;

%d是特征值组成的对角矩阵 a是对应的特征向量矩阵

[a d] = eig(Rx);

q = max(d);

q = d/q;

Un = a(:,1:NUM_zy-NUM_signal);

ths =-90:1:90;

beam1=s/max(s);

[V,I] = max(beam1);

err(ii,jj)=abs(ths(I)-theta)/theta/2;

end

% figure;

% plot(ths,beam1);

end

% save R.mat ths beam1 err

tt=100mean(err,2);

figure;

plot(SNR,tt,'b-o');

xlabel('SNR');

ylabel('误差%');

save R.mat SNR tt

```