人工智能经历70余年的探索和发展,如今到了大模型时代并出现现象级AI产品。这不仅是人类研究积累的厚积薄发,也是数字时代下大数据、大模型、大算力发展到了一定阶段的必然结果。在大模型的加持下,AIGC(AI Generated Content,人工智能生成内容)有望助力内容生成跨越新时代,并开启人工智能应用的新浪潮。

一、人工智能的演进及发展因素

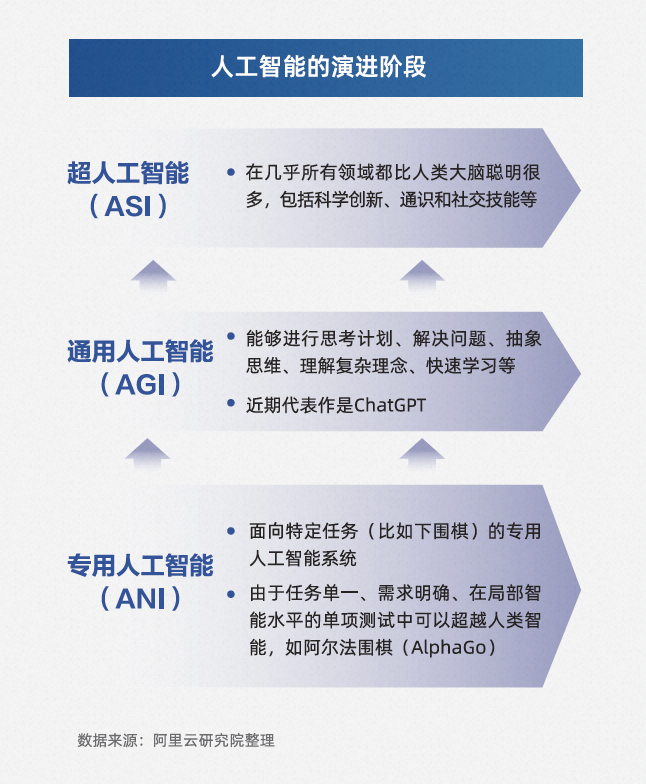

根据能力和应用范围不同,一般将人工智能分为专用人工智能(ANI)、通用人工智能(AGI)、超人工智能(ASI)三个阶段。

专用人工智能又称为弱人工智能,被编程以执行一组预设任务,例如我们常见的手机地图导航、电商产品推荐、在线客服自动应答等应用。通用人工智能又称为强人工智能,具有推理、计划、解决问题、抽象思考、快速学习和从经验中学习等能力,例如近期推出的现象级产品ChatGPT。超级人工智能则是AI发展的高级阶段,要求像人类一样独立思考并解决问题。目前,人工智能正在从专用人工智能向通用人工智能跃迁的过程中。

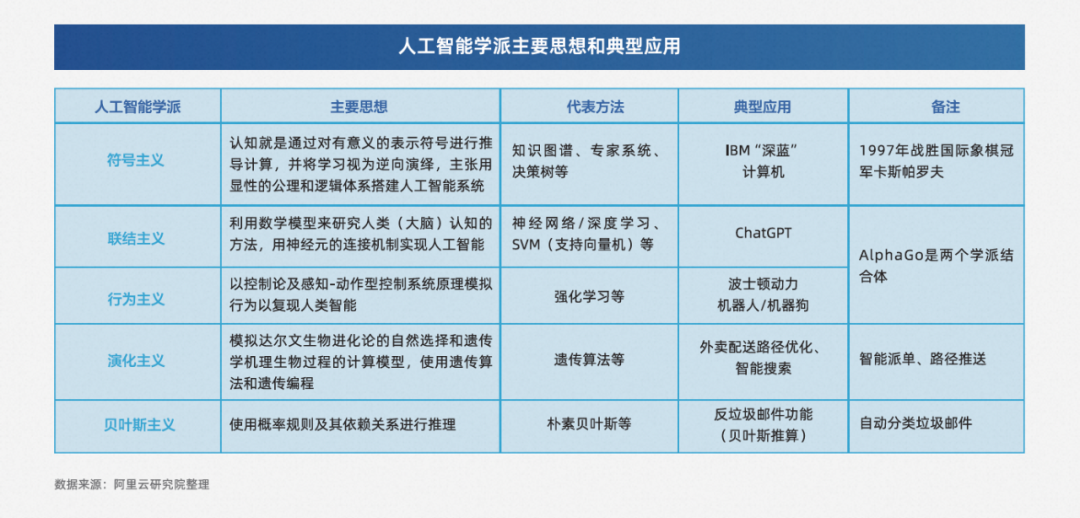

此外,根据人工智能实现和应用方法、路径不同,衍生出多个学派。

其中联结主义和符号主义是主要的两大派系,“联结主义”学派,又称仿生学派,主张利用数学模型来模拟人类大脑神经元的连接机制实现人工智能,代表方法是神经网络;“符号主义”学派,又称逻辑主义学派,主张对有意义的表示符号进行推导计算,用显式的公理和逻辑体系搭建人工智能系统,代表方法是知识图谱、决策树。近期以大模型为基础的AI研发和应用热潮属于联结主义学派的胜利。

人工智能从起步到发展,一直在充满未知的道路上探索。直到近期随着云计算、大数据、物联网等信息技术的发展和成熟,推动以深度神经网络为代表的人工智能飞速发展。此外数据、算力和算法的发展也在不断推波助澜。

今天时代下的数据已经成为新生产要素,不仅数据量每年呈现指数级规模增长,而且数据形态多种多样,文本、图像、音频、视频等非结构化数据的处理和应用已相对容易。正因为海量数据的存在和可触达,大模型的参数量才能不断跃升。

有了数据,还需要强计算能力去高效处理这些数据,云计算胜任了这个角色,云计算高效地把成千上万的服务器有效的连接起来,形成超级计算能力,为人工智能的发展提供强有力的计算底座。当前包括GPT在内所有人工智能大模型几乎都架构在云计算基础上。

此外人工智能算法模型也有很大突破。今天模型通过自监督学习的方式,可实现从海量数据中自动进行数据标注。另外,注意力机制加速了深度学习算法的演进,使得算法模型能更好的处理长序列数据,同时也可以在结果生成过程中聚焦关键信息,从而提高模型的准确性和流畅度。数据、算力和算法的发展与创新,推动大模型时代真正到来。

二、大模型在人工智能领域的革命性突破

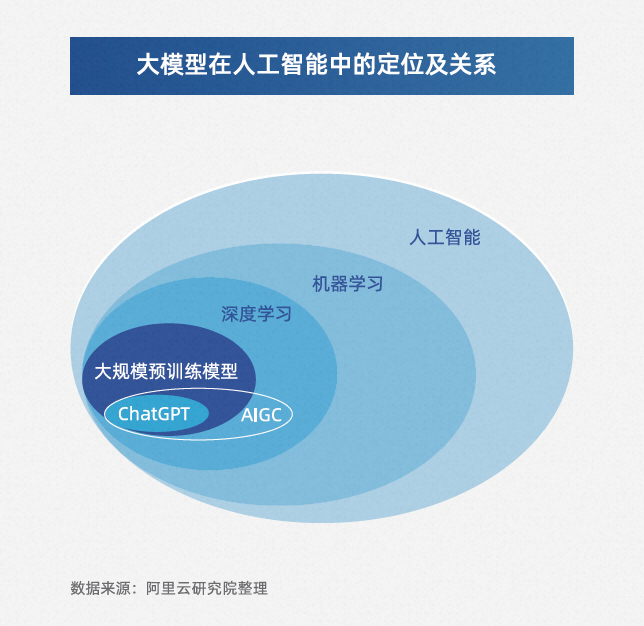

ChatGPT的惊艳表现迅速提高社会大众对AI商业前景的预期。ChatGPT推出仅5天,注册用户数就超过100万,2个月后月活用户数突破1亿,成为有史以来用户增长最快的商业应用。虽然ChatGPT成为万众瞩目的焦点,但它背后的大模型才是推动人工智能应用的重要推手。

大模型是指大规模预训练模型,是一种机器学习模型,使用大量数据进行预训练,并在后续任务中进行微调。这种模型通常采用深度学习技术,可以自动从数据中提取特征和模式,从而进行各种任务,例如自然语言处理、图像识别、语音识别等。目前最著名的预训练大模型是GPT系列。大模型早已经发展多年,但2018年出现的大规模自监督神经网络才是真正具有革命性意义的,它使得大模型出现了关键性突破,就是通过自动标注数据实现训练数据集的扩大,因为足够多的数据是大模型实现泛化的重要基础,只有模型“见多识广”了,遇到以前没见过的情况才可以从容应对。

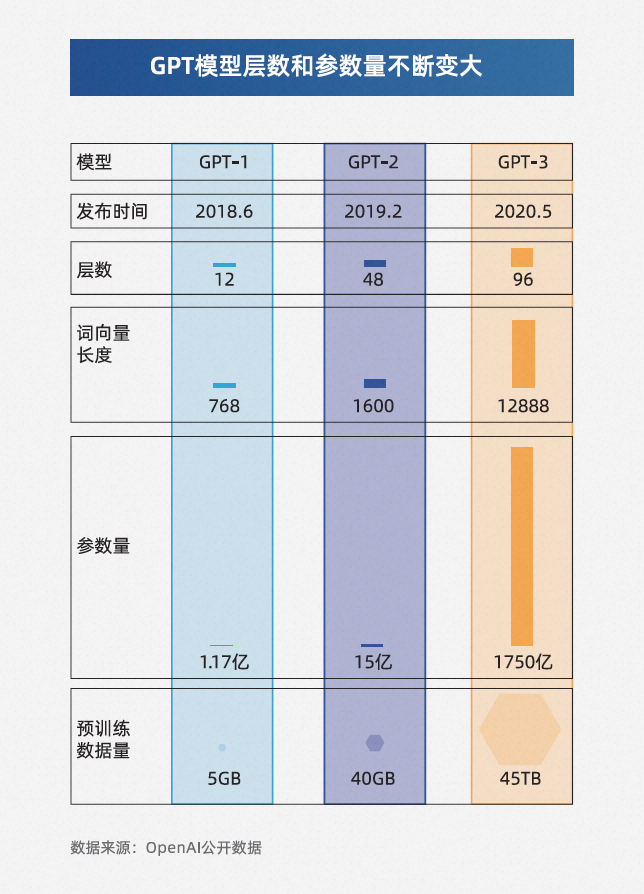

仅仅从GPT模型的数据变化,可以清晰感受到模型的演进方向。

训练数据集规模越大,模型的表现就越好,以前数据集规模做不大是因为过去传统深度学习模型的训练,大多需要人工来标注数据,对数据进行手工标注是一个费时费力的过程,这极大限制了数据规模。

那么对于人工智能发展而言,大模型都有哪些革命性意义?

(1)突破现有模型结构的精度局限

2022年8月,谷歌发布的关于模型精度与模型参数规模大小之间的关系表明,当模型参数规模达到某个阈值时,模型对某些问题处理的准确性快速增长。这与OpenAI的分析结论一致,即随着模型参数规模指数级上升,模型性能实现线性增长。

模型参数量越大,神经网络性能越贴近人类。人类大脑大约由1000亿个神经元和数百万亿个神经连接组成(每个神经元有100~10000个突触)。如果参数量类比人脑(等同于神经连接数量),GPT-3目前还差1000倍。未来随着模型继续变大,也许可能会达到甚至超越人脑的思维能力。

除了数据集规模以外,层数越多,模型效果也会显著提升,全球最大的AI图像识别数据库ImageNet公布的测试结果显示,随着神经网络层数增加,识别错误率不断下降,从最初的28.2%下降到3.57%,已低于人类的分类错误率(5%)。

(2)创新自然语言处理(NLP)的范式

传统的NLP处理方式采用流水线范式,即通过多个处理步骤依次对自然语言进行词法分析、句法分析以及语义分析等。每个模块都由不同模型完成,并需要在不同标注数据集上训练。随着大模型的出现,这种模式已经被彻底颠覆。大模型出现后,基于大模型+微调的方式明显提升准确率,用一个模型可以同时实现多种自然语言理解任务,如多种语言翻译、智能问答、实体识别和情感分析等,并且在生成通顺文本方面也实现了革命性突破。ChatGPT是其中较好的例子。

(3)预训练大模型+细分场景微调更适合行业应用落地

过去,深度学习模型需要从头开始训练,需要大量标注数据。然而现在,大规模预训练模型采用了更加高效的方式——预训练+微调。预训练可以自动学习一些通用特征,提升模型的泛化能力,可以把它比喻成大学生在学习专业科目时,会提前在高中阶段学到基本的方法和技巧,比如如何理解概念、如何思考问题、如何进行逻辑推理等等。这些基本的学习方法和技巧可以被应用在不同的科目中,帮助学生快速适应新科目、更加高效地学习和掌握知识。同样地,一个模型的泛化能力越强,也就意味着它对于不同的数据集都能够有更好的适应能力。

微调是在少量针对任务构建的有监督数据(即人工介入数据标注)上继续训练模型。近两年还出现了“提示学习”(prompt)微调形式,只需要对任务用语言描述或者给几个例子,模型就能很好的执行以前从未训练过的任务。

由此,基于预训练大模型的基础能力,可以更好的由通用人工智能向各个行业的专用人工智能扩展,通过预训练大模型+行业细分场景微调,通用AI能力和行业专业数据/知识沉淀相结合,将给予行业智能化应用极大的想象空间。

三、大模型推动AIGC发展进入新阶段

在大模型的加持下,AIGC有望帮助内容创跨越新时代。AIGC利用现有的文本、音频、图像等数据,通过各种机器学习算法学习其中的要素,使机器能够创建全新的数字视频、图像、文本、音频或代码等内容。早期AIGC在文本生成领域开启内容创作落地,后期逐渐向图像、音视频等领域扩展,跨模态内容生成也发展迅速,应用场景不断丰富。随着大模型的爆发,AIGC有了更多的可能性。

(1)语言大模型增强AIGC认知能力

与传统的NLP处理方式相比,主流的Transformer大模型采用自注意力机制,在NLP自然语言处理领域表现更出色。在早期的深度学习时代,自然语言处理面临着模型设计和部署困难、数据难以复用、海量数据无标签难以进行数据挖掘、知识提取等问题。而Transformer大模型的自注意力机制可以为输入序列中的任意位置提供上下文,模型可以一次性处理所有输入数据。此外,Transformer语言大模型处理速度更快,能够大幅减少训练时间,并能够在更大规模的数据集上进行训练。基于Transformer的预训练大模型已成为NLP领域的主流,国外除了谷歌和OpenAI发布大规模预训练模型,国内阿里云也发布了通义大模型。

(2)视觉大模型提高AIGC感知能力

除了在NLP领域,大模型在计算机视觉领域也有着广泛的应用。在早期深度学习时代,视觉主要基于深度神经网络模型,如深度残差网络(ResNet)。这类模型通常只能针对单一的视觉感知任务进行设计,难以同时完成多种视觉感知任务。相比之下,基于大模型的AIGC可以解决不同场景、环境和条件下的视觉感知问题,并实现准确、高效的视觉理解。近年来,基于Transformer的一系列大模型架构如Swin Transformer、ViTAE Transformer也慢慢衍生出来,通过无监督预训练和微调的范式,在图像分类、目标检测、语义分割、姿态估计、图像编辑以及遥感图像解译等多个感知任务上取得了优异的性能和表现。

(3)多模态大模型升级AIGC内容创作能力

在日常生活中,语言和视觉是最常见且最重要的两种模态,语言大模型可以学习人类文明的抽象概念以及认知能力,视觉大模型可以构建出人工智能更加强大的环境感知能力。然而,如果AIGC技术只能生成单一模态的内容,其应用场景将受到极大的限制,难以推动内容生产方式的革新。多模态大模型的出现,则让融合性创新成为可能,极大的丰富AIGC技术可应用的广度。多模态大模型将不同模态的原始数据映射到统一或者相似语义空间中,实现不同模态信号之间的相互理解与对齐。基于多模态大模型,AIGC才能具备更接近于人类的创作能力,并在行业应用中进一步解放生产力。

四、未来展望

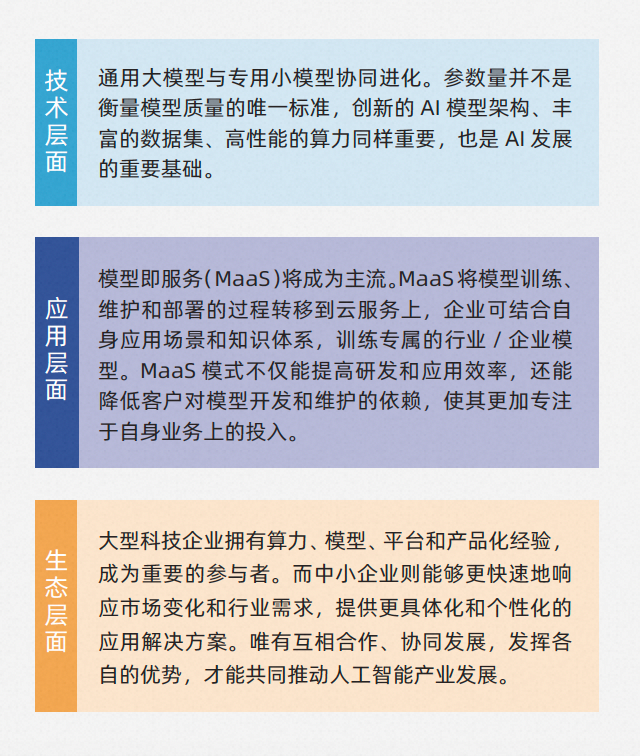

AI产业的发展前景非常广阔。虽然大模型应用还处于初级阶段,但基于大模型的AIGC将成为一项大众化的基础技术,可极大提高数字化内容的丰富度、创造性与生产效率,其应用边界也将随着技术的进步与成本的降低扩展到更多领域,为社会经济发展带来更多机遇和创新。

参考资料:

(1)李飞飞、Percy Liang等学者:《On the Opportunities and Risks of Foundation Models》

(2)唐杰:《Self-supervised Learning:Generative or Contrastive》

(3)丁小虎:《人类生产力的解放?揭晓从大模型到AIGC的新魔法》

本文摘自《云栖战略参考》2023第一期

扫码限时申领纸质版

↓↓