又到了“机器学习奥林匹克”的时候了,如果你厌倦了一次又一次地看到Nvidia站在领奖台上,那太糟糕了。至少这一次,这个GPU强国加入了一个新的竞争者,它的Hopper GPU,其性能是其前任的4.5倍,预计将在几个月内推出。

但Hopper并不是唯一一个登上MLPerf推理v2.1领奖台的人。基于高通AI 100的系统也有不错的表现,还有其他新芯片、新型神经网络,甚至新的、更现实的测试方法。

“MLPerf到底是什么?” MLPerf是由行业组织MLCommons的成员商定的一组基准。这是首次尝试对计算机在训练和执行(推理)神经网络方面的能力进行比较。

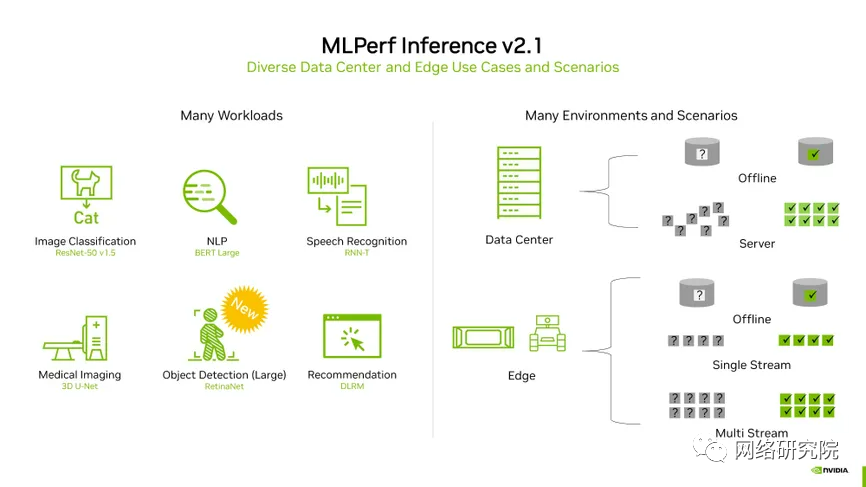

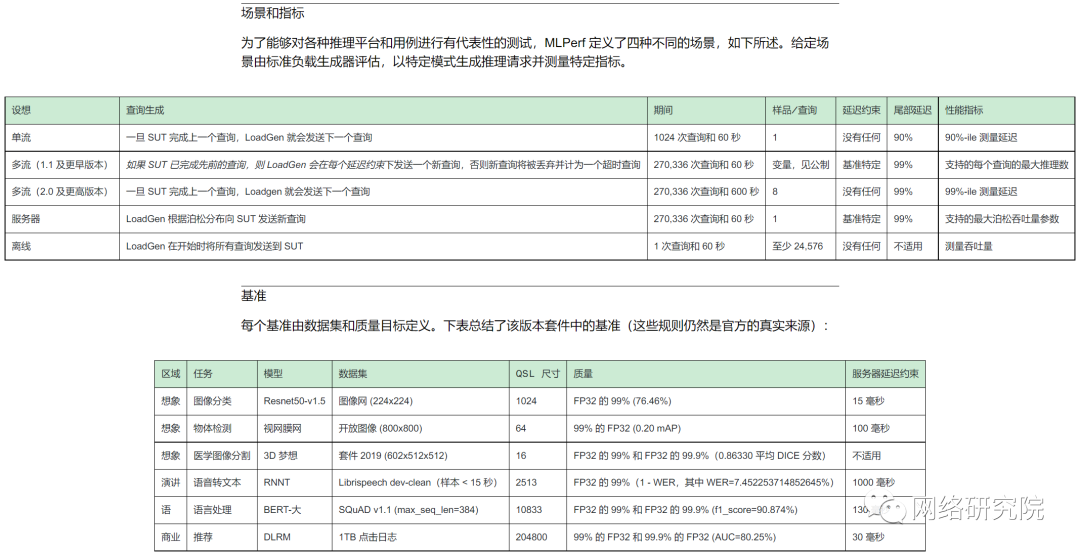

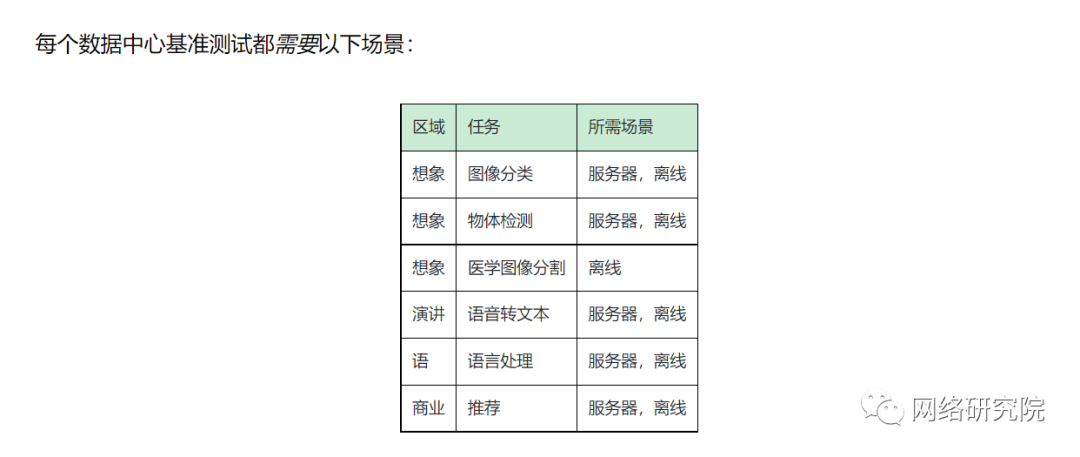

在MLPerf的推理基准测试中,由CPU和GPU或其他加速器芯片组合而成的系统在多达六个神经网络上进行测试,这些神经网络执行各种常见功能-图像分类、对象检测、语音识别、3D医学成像、自然语言处理和推荐。这些网络已经接受了一组标准数据的训练,必须对他们以前没有接触过的数据进行预测。

Nvidia的这张幻灯片总结了整个MLPerf的成果。六个基准[左]在两种类型的计算机(数据中心和边缘)上在各种条件下进行测试[右]。

测试的计算机被分类为用于数据中心或“边缘”商业上可用的基于数据中心的系统在两种条件下进行了测试——模拟真实的数据中心活动,其中查询以突发方式到达,以及“离线”活动,其中所有数据都可以立即获得。

打算在现场而不是在数据中心工作的计算机MLPerf称之为边缘,因为它们位于网络的边缘——是在离线状态下测量的;好像它们正在接收单个数据流,例如来自安全摄像机的数据流;就好像他们必须处理多个数据流,就像一辆装有几个摄像头和传感器的汽车一样。

除了测试原始性能,计算机还可以在效率上进行竞争。比赛进一步分为“封闭”类别和“开放”类别,在“封闭”类别中,每个人都必须运行相同的“数学等价”神经网络,并满足相同的精度指标,在“开放”类别中,公司可以展示对标准神经网络的修改如何使他们的系统工作得更好。

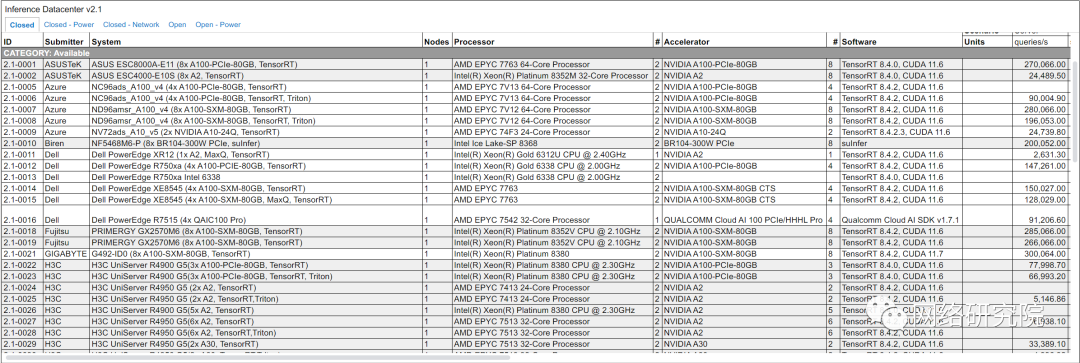

在最严格条件下与最强大计算机的竞赛中,封闭数据中心集团,来自四家公司的装有人工智能加速器芯片的计算机展开了竞争:Biren,Nvidia,高通和Sapeon。(英特尔制作了两个没有任何加速器的参赛作品,以展示其CPU可以独立完成的任务。) 虽然在整个神经网络套件上测试了几个系统,但大多数结果都是为了图像识别而提交的,自然语言处理器BERT(变形金刚双向编码器表示的缩写)紧随其后,使这些类别最容易比较。一些基于Nvidia-GPU的系统在整套基准测试中进行了测试,但参与其中的工程师表示,即使是执行一个基准测试也需要一个多月的时间。

在图像识别试验中,初创公司Biren的新芯片BR104表现良好。与该公司的合作伙伴浪潮(Inspur)一起建造的八加速器计算机每秒钟可以处理424,660个样本,是第四名的测试系统,落后于高通云AI 100的18个加速器,以及Nettrix和H3C的两个Nvidia A100的研发(R&D)系统,每个系统都有20个加速器。

但是Biren真正展示了它在自然语言处理方面的能力,在最高精度版本的BERT上击败了所有其他四加速器系统至少 33%,在八加速器系统中甚至领先更多。

另一个突出的例子是基于两个即将发布的Xeon Sapphire Rapids CPUs的英特尔系统,没有任何加速器的帮助,击败了使用两个当前代Xeon和一个加速器的机器。

这种差异部分归因于Sapphire Rapids的高级矩阵扩展,这是一种在每个CPU内核中工作的加速器。Sapeon展示了两个装有不同版本的Sapeon X220加速器的系统,仅在图像识别方面进行了测试。在这一点上,两者都轻松击败了其他单加速器计算机,除了Nvidia的Hopper,它完成了六倍的工作。

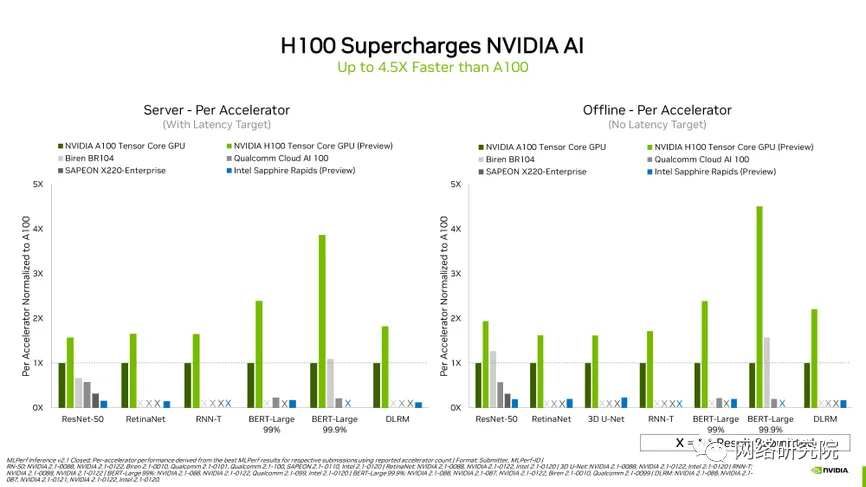

拥有多个GPU或其他人工智能加速器的计算机通常比只有一个加速器的计算机运行得更快。但在每个加速器的基础上,Nvidia即将推出的H100几乎击败了它。

事实上,在相同配置的系统中,Nvidia的Hopper在每个类别中都名列前茅。与它的前辈A100 GPU相比,Hopper在每个加速器的基础上至少快1.5倍到4.5倍,具体取决于测试中的神经网络。Nvidia加速云计算产品营销总监称:H100真的带来了巨大的成功,我们的工程师把它打得落花流水。Hopper的秘密是一个叫做变形金刚引擎的系统。它是一类神经网络,包括MLPerf推理基准BERT中的自然语言处理器。transformer引擎旨在通过调整每层神经网络中计算的数字的精度,使用达到准确结果所需的最小值来加快推理和训练。这包括使用8位浮点数的修改版本进行计算。(这里有一个更完整的降低精度机器学习的解释。) 因为这些结果是对MLPerf基准的第一次尝试,随着工程师们发现如何充分利用新芯片,预计H100和A100之间的差距将会扩大。

这是有先例的。通过软件和其他改进,自2020年5月推出以来,工程师们已经能够不断加快A100系统的速度。Salvator表示,预计未来MLPerf的效率基准将获得H100的结果,但目前该公司专注于看看他们可以从新芯片中获得什么样的性能。

在效率方面,基于高通云AI 100的机器让自己感到自豪,但这是在一个比性能竞赛小得多的领域。(MLPerf代表强调,效率测试和性能测试的计算机配置不同,因此比较为相同目的配置的系统的性能是公平的。)在数据中心系统的离线图像识别基准测试中,高通在每焦耳消耗可识别的图像数量方面名列前三。

它们的效率之争更加激烈了。高通以99%精度的版本拔得头筹,但在99.99%精度的任务中输给了英伟达A100系统。在这两种情况下,竞争都很激烈。

edge系统的图像识别也是如此,高通在大多数情况下处理数据流的时间不到1毫秒,并且经常使用不到0.1焦耳的能量,因此几乎占据了所有的榜首。

Nvidia的Orin芯片将在6个月内推出,最接近高通的结果。同样,Nvidia比BERT更好,使用更少的能源,尽管它仍然无法匹配高通的速度。

MLPerf的“开放”部门进行了许多工作,但更有趣的结果之一是公司如何展示“稀疏”网络的性能和效率。这些方法采用一个神经网络并对其进行删减,删除对产生结果贡献很小或没有贡献的节点。

理论上,更小的网络可以运行得更快、更高效,同时使用更少的计算和内存资源。例如,初创公司Moffett AI展示了三台计算机使用其用于稀疏网络的Antoum加速器架构的结果。

莫菲特测试了这些系统,这些系统旨在用于图像识别和自然语言处理的数据中心。在图像识别方面,该公司的商用系统每秒处理31,678个样本,其即将推出的芯片每秒处理95,784个样本。

作为参考,H100每秒达到95,784个样本,但Nvidia机器正在处理完整的神经网络,并达到了更高的精度目标。

另一家专注于稀疏性的公司Neural Magic展示了将稀疏性算法应用于神经网络的软件,以便它们在商用CPU上运行更快。

该公司表示,其算法将一个版本的BERT的大小从1.3GB减少到约10MB,并将吞吐量从每秒10个样本增加到1000个。

最后,位于特拉维夫的Deci公司使用了一种被称为自动神经架构构建技术(AutoNAC)的软件,生产了一种针对AMD CPU进行优化的BERT版本。使用大小为参考神经网络三分之一的模型,最终网络的吞吐量提高了六倍以上。

超过7,400项测量涵盖了一系列类别,还有更多需要解开的谜团。

你可以在MLCommons上随便看看。

推理:数据中心v2.1 结果https://mlcommons.org/en/inference-datacenter-21/系统硬件配置详细参数