概率论学科定义

概率论是用于表示不确定性声明的数学框架。它不仅提供了量化不确定性的方法,也提供了用于导出新的不确定性声明(statement)的公理。概率论的知识在机器学习和深度学习领域都有广泛应用,是学习这两门学科的基础。

概率与信息论在人工智能领域的应用

在人工智能领域,概率论主要有两种用途。

首先,概率定律告诉我们 AI 系统应该如何推理,基于此我们设计一些算法来计算或者估算由概率论导出的表达式。

其次,我们可以用概率和统计从理论上分析我们提出的 AI 系统的行为。

虽然概率论允许我们在存在不确定性的情况下做出不确定的陈述和推理,但信息论允许我们量化概率分布中不确定性的数量。

3.1,为什么要使用概率论

这是因为机器学习必须始终处理不确定的量,有时可能还需要处理随机(非确定性)的量,这里的不确定性和随机性可能来自多个方面。而使用使用概率论来量化不确定性的论据,是来源于 20 世纪 80 年代的 Pearl (1988) 的工作。

不确定性有三种可能的来源:

被建模系统内在的随机性。

不完全观测。

不完全建模:使用了一些必须舍弃某些观测信息的模型。

3.2,随机变量

随机变量(random variable)是可以随机地取不同值的变量,它可以是离散或者连续的。

离散随机变量拥有有限或者可数无限多的状态。注意这些状态不一定非要是整数; 它们也可能只是一些被命名的状态而没有数值。连续随机变量伴随着实数值。注意,随机变量只是对可能状态的描述;它必须与指定这些状态中的每一个的可能性的概率分布相结合。

我们通常用无格式字体 (plain typeface) 中的小写字母来表示随机变量本身,而用手写体中的小写字母来表示随机变量能够取到的值。例如, 和 都是随机变量 可能的取值。对于向量值变量,我们会将随机变量写成 ,它的一个可能取值为 。

中文维基百科用 表示随机变量,用 表示概率密度函数,本文笔记,不同小节内容两者混用。

3.3,概率分布

概率分布(probability distribution)是用来描述随机变量或一簇随机变量在每一个可能取到的状态的可能性大小。

如果狭义地讲,它是指随机变量的概率分布函数。具有相同概率分布函数的随机变量一定是相同分布的。连续型和离散型随机变量的概率分布描述方式是不同的。

3.3.1,离散型变量和概率质量函数

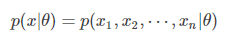

离散型变量的概率分布可以用概率质量函数(probability mass function, PMF,也称概率密度函数)来描述。我们通常用大写字母 来表示概率质量函数,用 表示随机变量 遵循的分布。

虽然通常每一个随机变量都会有一个不同的概率质量函数,但是概率质量函数也可以同时作用于多个随机变量,这种多个变量的概率分布被称为联合概率分布(joint probability distribution)。 表示 和 同时发生的概率,有时也可简写为 ,。

如果一个函数 是随机变量 的 PMF,必须满足以下条件:

的定义域必须是 所有可能状态的集合。

。不可能发生的事件概率为 0,能够确保一定发生的事件概率为 1。

,归一化(normalized)。

常见的离散概率分布族有:

伯努利分布

二项分布:一般用二项分布来计算概率的前提是,每次抽出样品后再放回去,并且只能有两种试验结果,比如黑球或红球,正品或次品等。

几何分布

Poisson 分布(泊松分布):Poisson 近似是二项分布的一种极限形式。

离散均匀分布:即对于随机变量 ,因为其是均匀分布(uniform distribution),所以它的 PMF 为

,同时

。

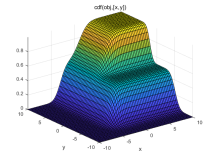

3.3.2,连续型变量和概率密度分布函数

连续型随机变量的概率分布可以用概率密度函数(probability desity function, PDF)来描述。

通常用小写字母 来表示随机变量 的概率密度函数 PDF,其必须满足以下条件:

的定义域必须是 所有可能状态的集合。

。注意,并不要求 。

。

概率密度函数 给出的是落在面积为 的无限小的区域内的概率为 。

因此,我们可以对概率密度函数求积分来获得点集的真实概率质量。特别地, 落在集合 中的概率可以通过 对这个集合求积分来得到。在单变量的例子中, 落在区间 的概率是 。

常见的连续概率分布族有:

均匀分布

正态分布:连续型随机变量的概率密度函数如下所示。其密度函数的曲线呈对称钟形,因此又被称之为钟形曲线,其中 是平均值, 是标准差。正态分布是一种理想分布。

伽玛分布

指数分布