机器学习:概率视角的Linear Regression

前言

上一节我们说到了一元线性回归·与·多元线性回归,大家如果还不清楚,可以去考古。

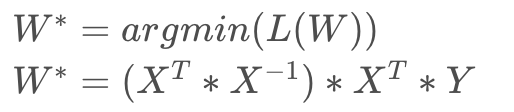

之前,我们用最小二乘估计,推导出来:

在这一小节中,我采取概率的视角来解决线性回归问题。

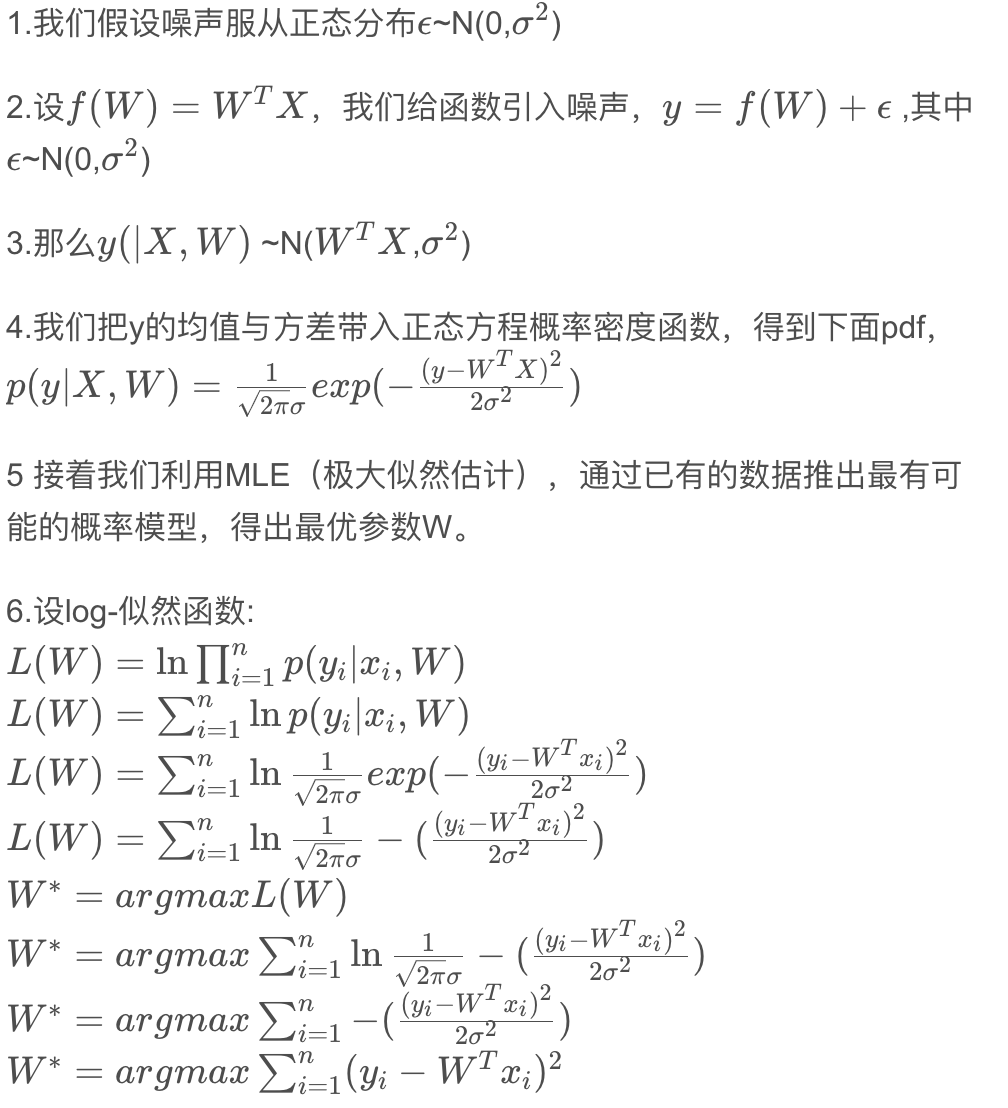

推导过程

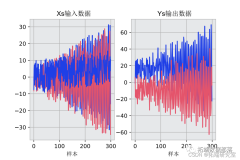

还是这一张图,我们可以发现,如果让拟合的直线与每个观测值x的距离都为0,也就是误差为0,但是这情况是不会出现的,因为数据本身就具有不确定性,带有一定的噪声。如果真有这种情况,这个模型也没有任何意义,只能解决特定问题。

结论归纳

求到最后,我们可以看出,这与之前讲过的最小二乘估计的Cost function是一致的,可以得出结论最小二乘估计隐含了噪声服从正态的假设,从概率角度的MLE(极大似然估计)与MSE(最小二乘估计)本质是一样的。