今天在阿里modelscope提供的魔搭平台免费实例,尝试使用FastChat训练部署Qwen-1_8B-Chat,然后使用gradio-web-ui 启动webui页面。说下遇到的问题:

1.在提供的/mnt/workspace目录,发现git clone 经常下载不下来一直到一半报错,然后切到上一级目录再git clone,发现才能下载下来。

2.pip install .安装 fastchat

python -m fastchat.serve.controller --host 0.0.0.0 正常

python3 -m fastchat.serve.model_worker --model-path /mnt/workspace/.cache/modelscope/hub/Qwen/Qwen-1_8B-Chat

出现了一个警告,WARNING: Error parsing dependencies of pytorch-lightning: . suffix can only be used with == or != operators torch (>=1.9.) 但是不影响启动

gradio-web-ui:python3 -m fastchat.serve.gradio_web_server --host 0.0.0.0 --port 8000

开启web发现报错警告但是可以启动:ERROR | stderr | /usr/local/lib/python3.10/site-packages/gradio/components/chatbot.py:237: UserWarning: You have not specified a value for the type parameter. Defaulting to the 'tuples' format for chatbot messages, but this is deprecated and will be removed in a future version of Gradio. Please set type='messages' instead, which uses openai-style dictionaries with 'role' and 'content' keys.

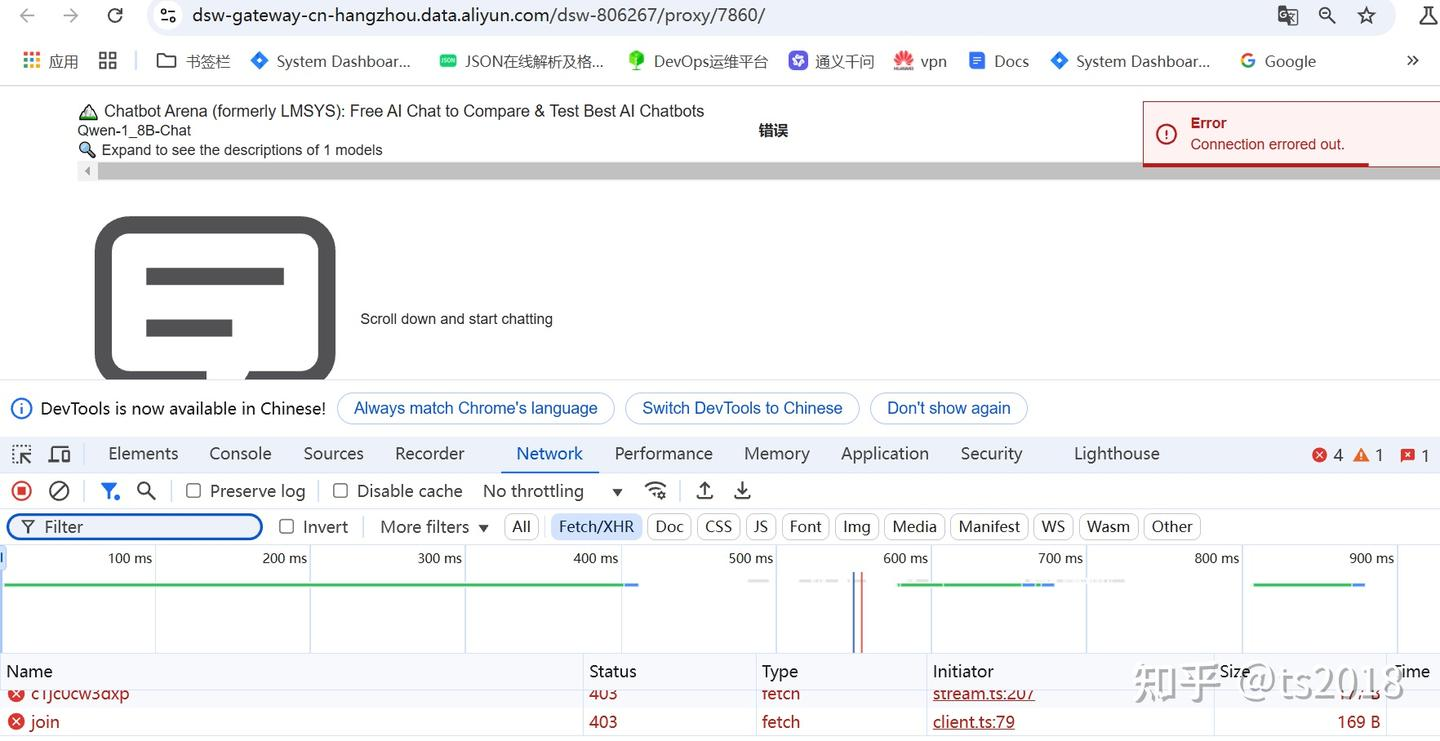

访问页面:https://dsw-gateway-cn-hangzhou.data.aliyun.com/dsw-806267/proxy/7860/

发现能进去页面但是一直提示报错:Error Connection errored out.

发现接口403.

然后以为是上面哪个错误警告导致的,于是修改了 fastchat的源码在

/mnt/FastChat/fastchat/serve/gradio_web_server.py加上了type类型

chatbot = gr.Chatbot(

type="messages",

...

)

然后重启python3 -m fastchat.serve.gradio_web_server --host 0.0.0.0 --port 8000

发现启动不报错了,但是访问 网页还是一直报上面的错误。请问大家 通过 提供的服务可以成功吗?请大佬指教谢谢!

您可以尝试先切换到上级目录再进行 git clone 操作,并确保在安装 fastchat 时环境满足所有依赖要求,如遇具体错误信息可详细描述或咨询阿里云工作人员以获得更精确的帮助。如果对您有帮助的话,可以帮忙采纳一下。谢谢。

参考官方文档进行安装和配置:FastChat 安装指南