flink kafka debezium-json读取更新的数据,数据格式和官网提供的不一样没有op 为u的数据 怎么才能获取op为u的数据

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

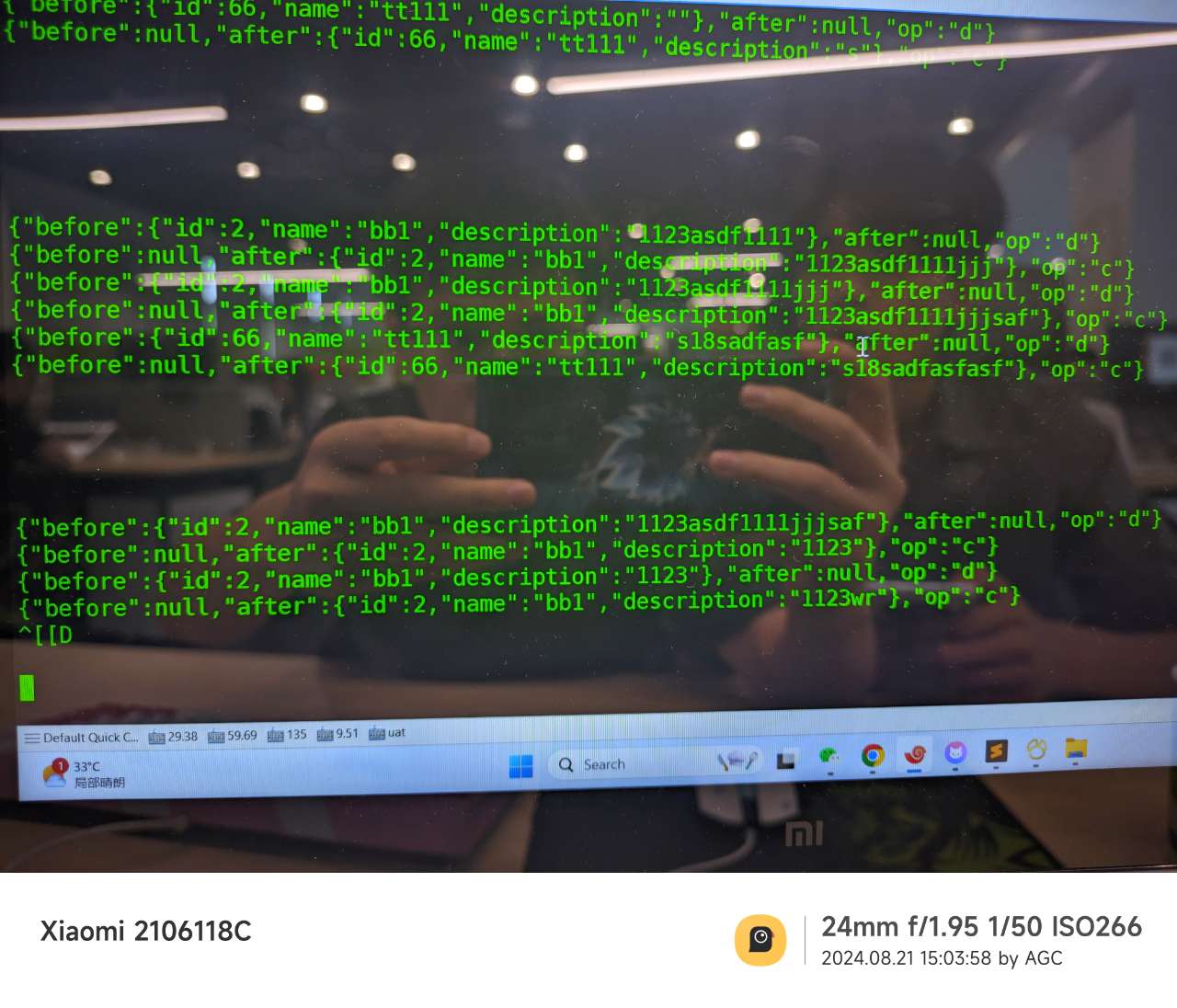

Apache Flink 通过连接到 Kafka 消费 Debezium JSON 格式的消息时,如果希望捕获数据库表的变更事件(例如INSERT, UPDATE, DELETE等),Debezium 会在其生成的消息中包含一个字段 op 来标识操作类型。对于更新操作(UPDATE),op 字段的值通常为 u。

如果你在使用 Flink 读取 Kafka 中的 Debezium JSON 数据时发现没有 op 字段,或者想要特别处理 op 为 u 的记录,你可以按照以下步骤检查和配置:

检查 Debezium 的配置:

op 字段的消息。这通常是在 Debezium 的配置中设置的。检查 Kafka 消费者配置:

Flink 的 Debezium Source Connector:

org.apache.flink.connector.debezium.DebeziumSource 并指定正确的 DebeziumDeserializationSchema。解析 Debezium 消息:

op 字段。这可以通过 Map 或 FlatMap 函数实现。过滤特定的操作类型:

op 为 u 的记录,可以在 Flink 的 DataStream API 中添加一个 Filter 函数来仅保留 op 为 u 的记录。这里有一个简单的示例代码片段,展示了如何在 Flink 中过滤出 op 为 u 的记录:

import org.apache.flink.api.common.serialization.DeserializationSchema;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import io.debezium.data.Envelope;

public class DebeziumFlinkExample {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 假设这里创建了一个 Kafka 消费流,并指定了正确的反序列化器

DeserializationSchema<io.debezium.data.Envelope> deserializationSchema = ...;

DataStream<Envelope> source = env.addSource(new FlinkKafkaConsumer<>("your-topic", deserializationSchema, properties));

DataStream<Envelope> updates = source.filter(record -> "u".equals(record.getOperation()));

// 进一步处理更新记录

updates.print();

env.execute("Flink Debezium Example");

}

}

请注意,上面的示例代码是一个简化版本,并且假设你已经有了一个 Kafka 消费配置。你需要根据实际情况调整 Kafka 消费者的配置、反序列化器的选择以及环境设置。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。