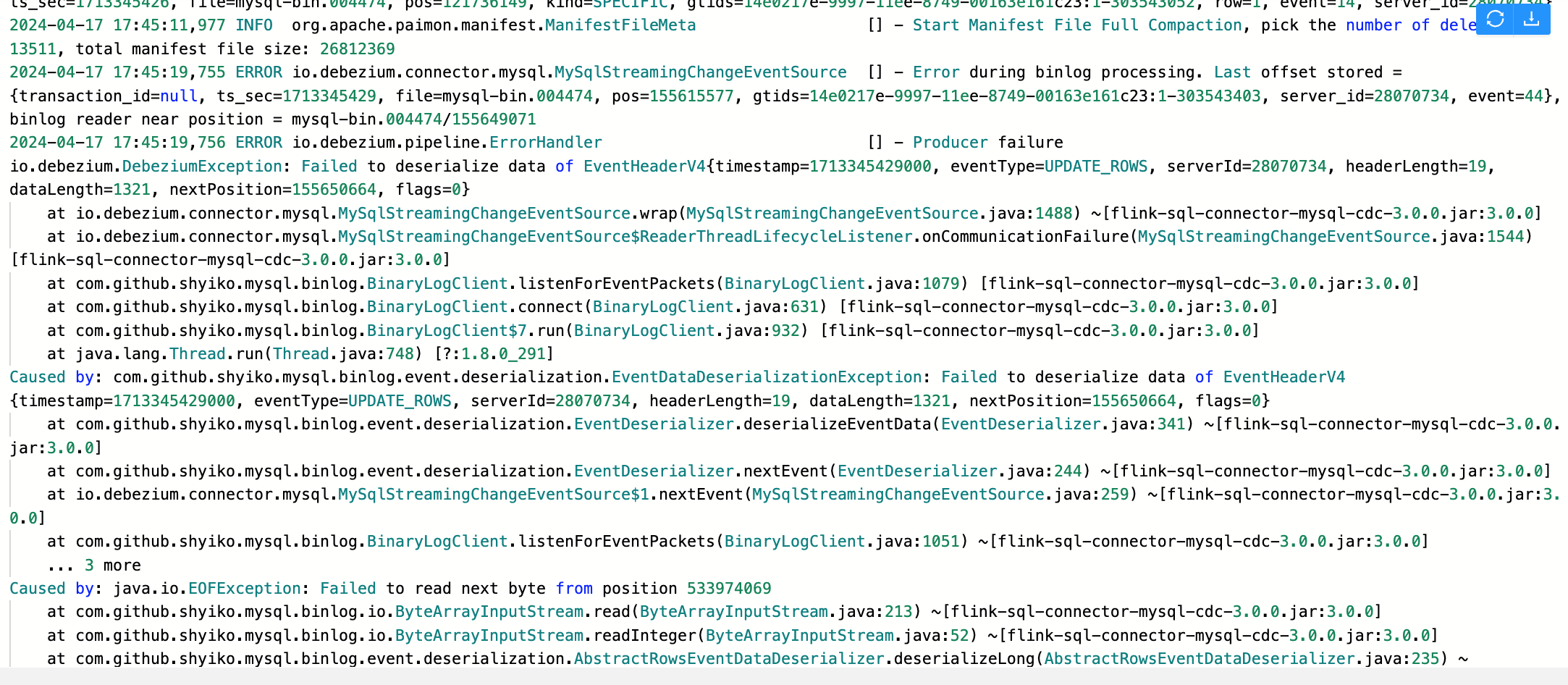

Flink CDC里这个已经是增量了,全量阶段都结束一个礼拜了报的,怎么办啊? 我看git上好早以前就有人提过这个说是在解决,但是不知道搞好没?

我看git上好早以前就有人提过这个说是在解决,但是不知道搞好没?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink CDC在全量阶段结束后一周才报错,这种情况可能与增量阶段的配置或运行环境有关。以下是针对该问题的详细分析和解决方案:

Checkpoint配置不当

如果在增量阶段触发了Checkpoint超时,可能会导致作业Failover。尤其是在全量阶段切换到增量阶段时,如果Checkpoint间隔时间设置过长(例如20分钟),可能导致增量数据同步延迟或失败。

Binlog日志丢失或未正确写入

如果MySQL CDC源表读取的是RDS MySQL 5.6备库或只读实例,这些实例可能没有向日志文件中写入增量变更信息,导致下游无法读取增量数据。

Replication Slot管理问题(Postgres CDC)

对于Postgres CDC,如果未及时清理Replication Slot,可能会导致磁盘空间浪费或WAL日志堆积,进而影响增量数据的读取。

表结构变更未同步

如果在全量阶段结束后发生了表结构变更,但上游无新增数据或数据变更,则不会触发下游的数据变更同步。这可能导致增量阶段出现异常。

调整Checkpoint间隔时间

建议将execution.checkpointing.interval设置为合理的值(例如5分钟),以避免Checkpoint超时导致作业Failover。同时,增加容忍失败的Checkpoint次数:

execution.checkpointing.interval: 5min

execution.checkpointing.tolerable-failed-checkpoints: 100

如果表特别大,可以适当增加tolerable-failed-checkpoints的值。

启用固定延迟重启策略

配置以下参数以确保作业在Checkpoint失败后能够自动恢复:

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 2147483647

检查MySQL实例类型

如果使用的是RDS MySQL 5.6备库或只读实例,建议切换到可写实例或升级至更高版本,以确保增量数据能够正确写入Binlog。

验证Binlog过滤器配置

使用以下命令检查MySQL服务器是否忽略了某些库的Binlog:

SHOW MASTER STATUS;

如果Binlog_Ignore_DB或Binlog_Do_DB字段中包含相关库名,请调整配置以确保增量数据能够被记录。

定期清理Replication Slot

如果使用的是Postgres CDC,建议定期清理不再使用的Replication Slot,以避免磁盘空间浪费或WAL日志堆积。

启用心跳包机制

配置heartbeat.interval.ms参数,确保即使表变更不频繁时也能及时推进Slot偏移量:

heartbeat.interval.ms: 30s

重新同步表数据

如果在全量阶段结束后发生了表结构变更,建议先停止作业,删除下游表,并重新启动同步作业。注意避免不兼容的表结构修改,否则重启作业后仍可能报错。

验证数据变更同步策略

表结构变更的同步依赖于前后两条数据之间的Schema变化。如果上游无新增数据或数据变更,则不会触发下游的数据变更。请确保上游有持续的数据写入。

升级Flink版本

如果问题仍未解决,建议升级到最新的Flink版本,以获取最新的Bug修复和功能改进。例如,VVR 8.x版本对GeminiStateBackend进行了优化,可能解决部分状态存储相关的问题。

联系技术支持

如果上述方法均无法解决问题,建议联系阿里云技术支持团队,提供详细的错误日志和配置信息以便进一步排查。

通过以上步骤,您可以逐步排查并解决Flink CDC增量阶段报错的问题。希望这些信息对您有所帮助!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。