"

ModelScope加完后运行报错,改脚本的哪个参数吗?"

在使用 ModelScope 时,如果运行报错,可能需要检查以下几个关键参数和配置是否正确。以下是可能导致问题的常见原因及解决方法:

确保脚本中指定的 MODEL_ID 和 REVISION 参数与 ModelScope 官网上的模型信息一致。如果模型 ID 或版本号错误,可能会导致下载失败或运行报错。

MODEL_ID = "Qwen/Qwen-7B-Chat"

REVISION = "v1.1.7"

MODEL_ID 和 REVISION 的值与 ModelScope 官网提供的信息一致。如果部署的是非公开模型,需要配置访问令牌(ACCESS_TOKEN)。缺少或错误的访问令牌会导致权限验证失败。

export ACCESS_TOKEN="your-modelscope-sdk-token"

ModelScope 模型通常对 GPU 资源有较高要求。如果 GPU 驱动版本不匹配或显存不足,可能会导致运行失败。

525.105.17,可以通过为节点池添加标签来指定驱动版本:ack.aliyun.com/nvidia-driver-version:525.105.17

模型下载和运行需要足够的磁盘空间。如果磁盘空间不足,可能会导致模型下载失败或运行报错。

运行脚本时,确保所有依赖库已正确安装,并且运行命令与镜像配置匹配。

git-lfs 和 modelscope:sudo apt-get update

sudo apt-get install git-lfs

pip install modelscope

arena serve custom \

-name=modelscope \

-version=v1 \

-gpus=1 \

-replicas=1 \

-restful-port=8000 \

-image=kube-ai-registry.cn-shanghai.cr.aliyuncs.com/kube-ai/quick-deploy-llm:v1 \

"MODEL_ID=qwen/Qwen1.5-4B-Chat python3 server.py"

如果上述配置均无误,但仍然报错,建议查看详细的日志信息以定位问题。

arena serve get modelscope

根据知识库资料,运行报错时需要重点检查以下内容: 1. 模型 ID 和版本号 是否正确; 2. 环境变量 是否配置完整; 3. GPU 驱动和资源分配 是否满足需求; 4. 磁盘空间 是否充足; 5. 运行命令和依赖库 是否正确安装和配置。

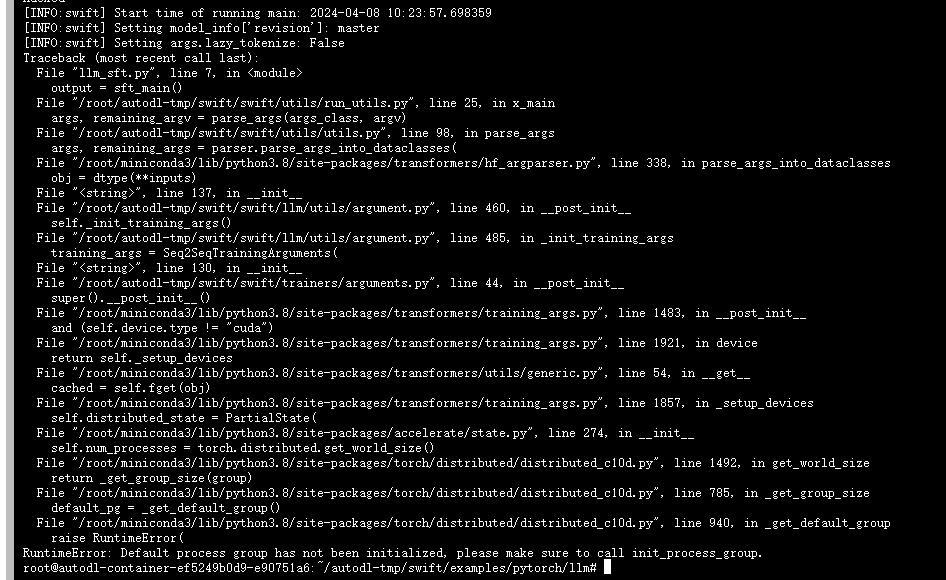

如果问题仍未解决,请提供具体的错误日志以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352