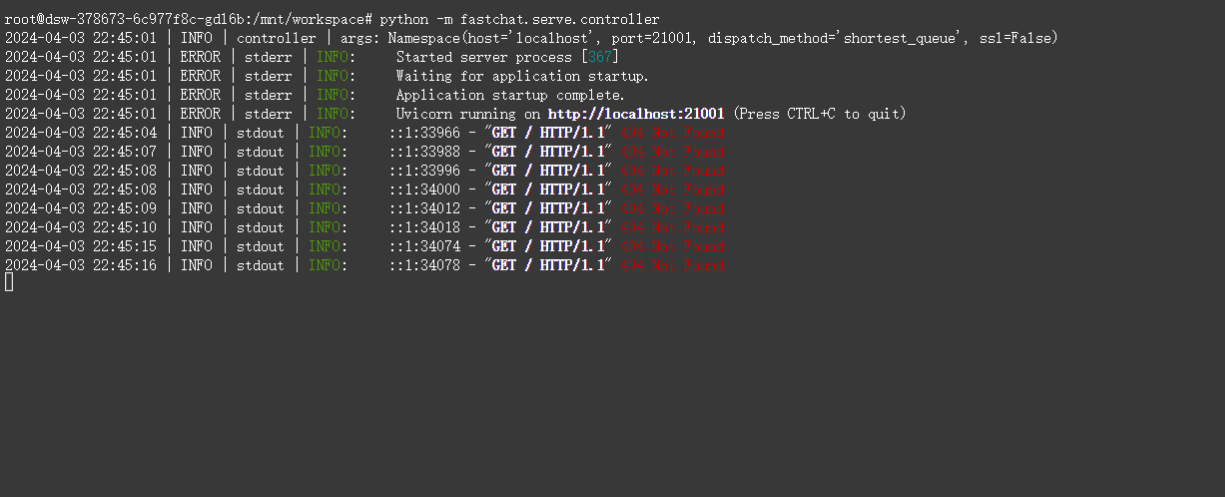

"执行:python -m fastchat.serve.controller

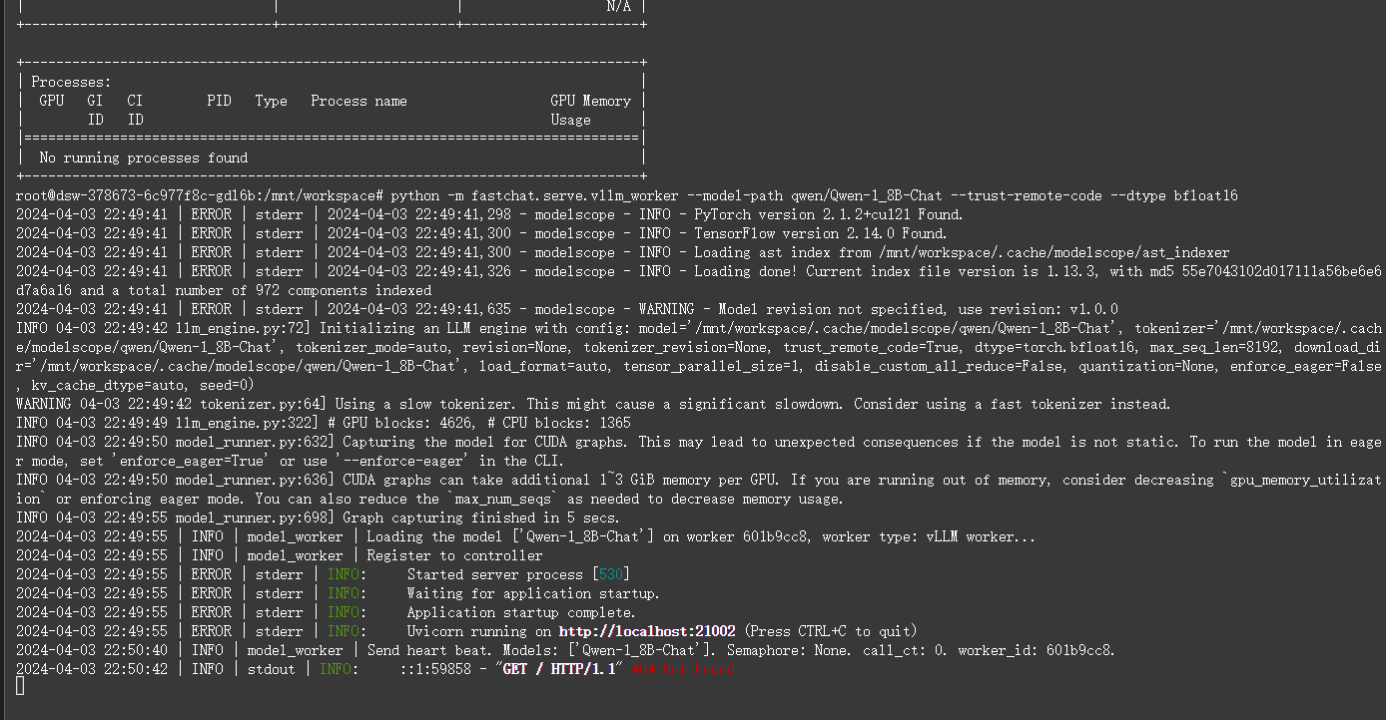

执行:python -m fastchat.serve.vllm_worker --model-path qwen/Qwen-1_8B-Chat --trust-remote-code --dtype bfloat16

modelscope问题怎么解决? "

您提到的命令行操作似乎是与FastChat框架和Qwen模型相关的,FastChat是一个用于构建对话应用的开源框架,而Qwen是阿里云推出的一种大型语言模型。当您尝试使用这些命令来部署或运行相关服务,并且遇到了与ModelScope(魔搭)相关的问题时,这里有几个可能的解决方向:

环境配置检查:首先确保您的环境中已正确安装了所有必要的依赖库,包括FastChat、VLLM(如果这是您用来推理的后端)、以及与ModelScope相关的任何组件。使用虚拟环境管理工具(如conda或pipenv)可以帮助隔离环境,避免版本冲突。

模型路径问题:您提到的--model-path qwen/Qwen-1_8B-Chat指向的是ModelScope上的模型。请确认该模型是否存在于ModelScope上,或者您是否有正确的访问权限。有时候,模型名称或路径的微小差异也会导致找不到模型的问题。

信任远程代码:您使用了--trust-remote-code参数,这意味着您允许从模型仓库加载并执行远程代码。这在使用预训练模型时很常见,但同时也需要确保这样做不会引入安全风险。确保您信任模型来源,并了解加载的代码内容。

数据类型问题:--dtype bfloat16指定了模型使用的数据类型为bfloat16,这是一种半精度浮点数格式,常用于加速计算并减少内存占用。请确认您的硬件(尤其是GPU)支持这种数据类型,并且安装的PyTorch或其他深度学习库也已正确配置以支持bfloat16。

查阅官方文档和社区资源:遇到具体错误信息时,首先查阅FastChat、Qwen以及ModelScope的官方文档,这些资源通常会提供详细的部署指南和常见问题解决方案。此外,GitHub上的Issue页面、论坛和社区也是寻找解决方案的好地方。

网络问题:如果您在中国大陆地区访问ModelScope有困难,可能需要考虑网络环境因素。确保您的网络设置能够顺利访问ModelScope的服务器,或者使用代理/镜像源等方法。

权限与认证:使用ModelScope上的模型有时需要API密钥或特定的认证方式。登录ModelScope网站,检查您的账户权限,并根据指引获取必要的认证信息,确保在运行命令时能够正确授权。

如果以上建议未能解决问题,请提供更具体的错误信息或描述,以便进行更深入的分析和指导。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352