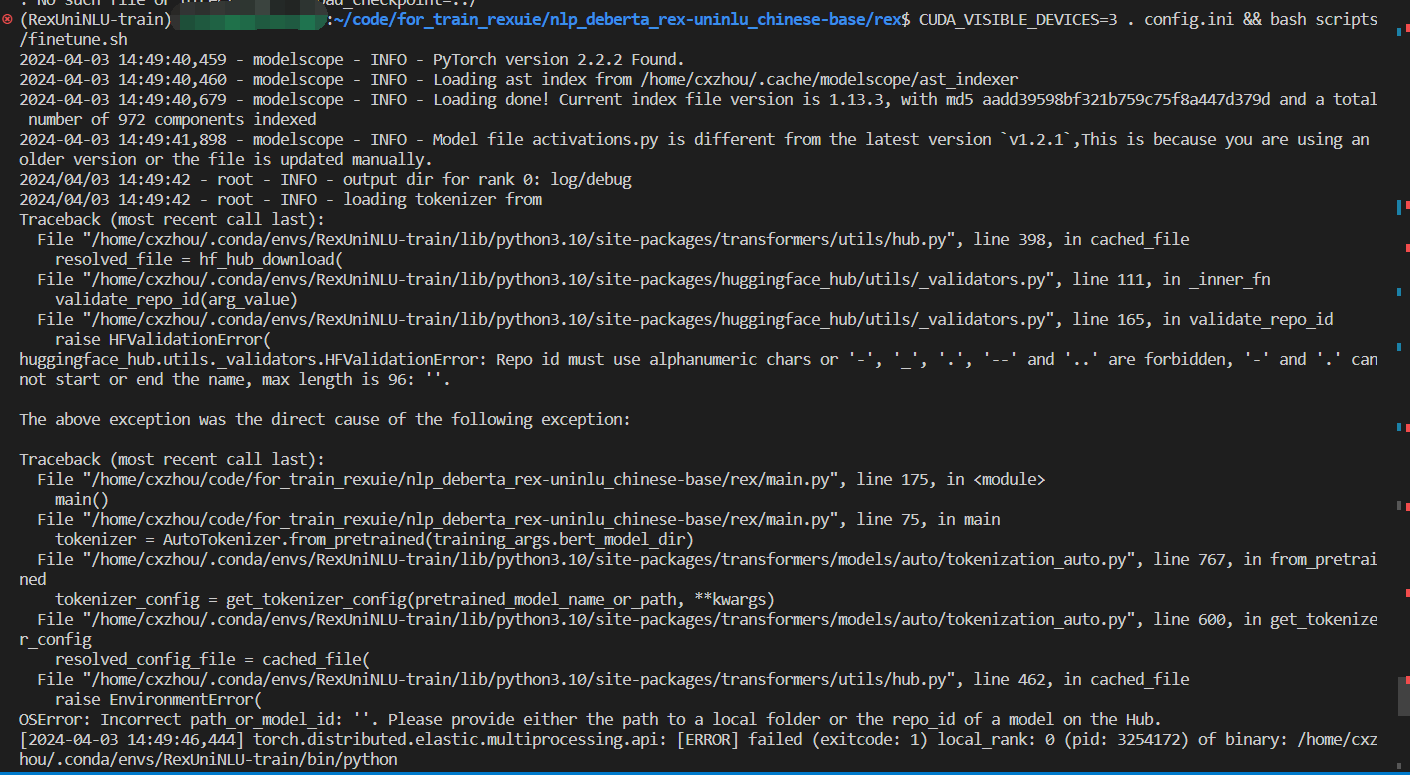

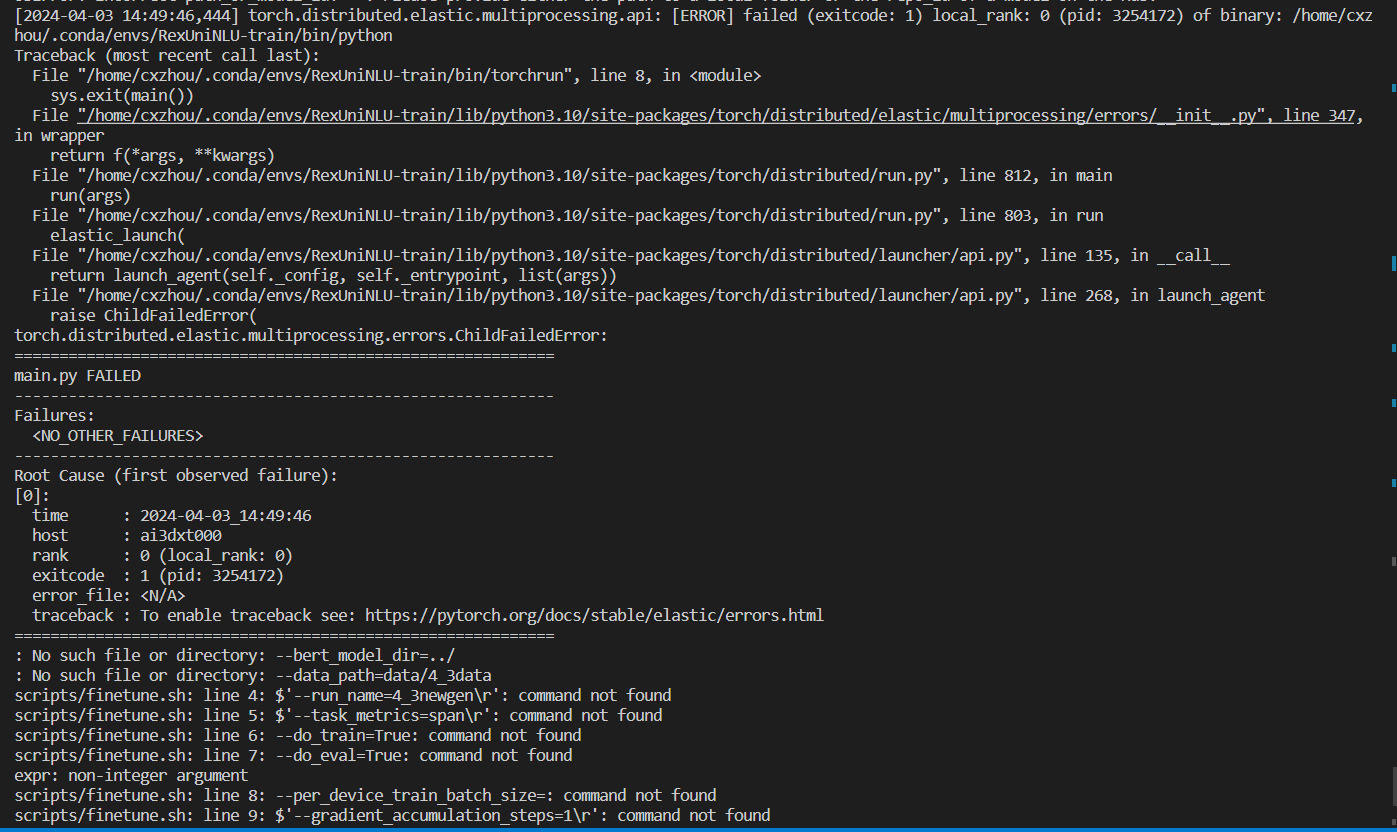

"推理正常,但modelscope微调的时候又报错,单机4卡,只想用第四张卡进行微调怎么处理?

"

在ModelScope上进行模型微调时,如果遇到问题并且希望指定使用单张GPU(例如第四张卡)进行训练,可以通过设置环境变量或直接在代码中指定GPU设备来实现。这里以Python环境下使用PyTorch为例,提供两种常见的方法:

在启动你的微调脚本之前,你可以通过设置CUDA_VISIBLE_DEVICES环境变量来指定可见的GPU设备。如果你想只使用第四张卡(通常索引为3,因为索引是从0开始的),可以在命令行中执行以下命令:

export CUDA_VISIBLE_DEVICES=3

然后运行你的微调脚本。这样,PyTorch将只会看到你指定的那张GPU。

如果你更倾向于在代码中直接指定GPU,可以使用torch.cuda.set_device()函数来实现。在你的微调脚本开始处添加如下代码:

import torch

# 设定要使用的GPU设备ID,对于第四张卡,设备ID为3

device_id = 3

torch.cuda.set_device(device_id)

# 确保后续的操作都在指定的GPU上进行

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

之后,在创建模型、加载数据加载器等操作时,确保将.to(device)应用到相关模块和数据上,以确保它们被发送到正确的GPU上进行计算。

请注意,上述方法假设你的系统已经正确安装了支持多GPU的CUDA环境,并且所有GPU都可供使用。此外,根据你的具体任务和框架版本,可能还有其他更细致的调整方式,但上述方法是通用且基础的处理方式。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352