"

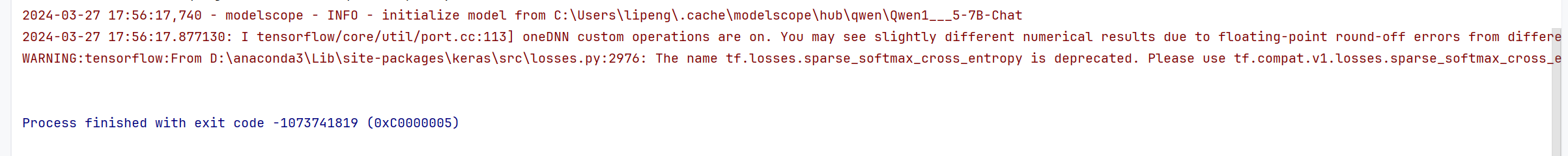

ModelScope中,在本地训练报这个错是因为内存溢出了吗?"

根据您提供的错误描述“在本地训练时报错”,并结合知识库中的相关资料,以下是对问题的详细分析和解决建议:

内存溢出(OutOfMemoryError)通常是由于程序运行时所需的内存超出了系统或容器分配的内存限制。在ModelScope中进行模型训练时,如果出现类似错误,可能的原因包括以下几种: - 数据量过大:训练数据集过大,导致内存占用超出限制。 - 模型复杂度高:模型参数过多或计算图过于复杂,消耗了大量内存。 - 未合理设置资源限制:本地环境或容器未正确配置内存参数,导致资源不足。

根据知识库中的类似案例,当处理外部表或大规模数据时,内存溢出问题通常与数据量、分区设置以及资源配置密切相关。

set odps.stage.mapper.mem = 4096; # 增加Mapper阶段的内存限制

set odps.stage.mapper.jvm.mem = 8192; # 增加JVM堆内存限制

permission denied错误。chmod +x 文件名

import torch

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

set odps.sql.mapper.split.size=256; # 单位为MB

set odps.stage.reducer.num=100; # 调整Reduce阶段的Worker数量

根据上述分析,您提到的“在本地训练报错”很可能是由于内存溢出引起的。建议从数据量、分区设置、内存参数、权限配置以及硬件加速等方面逐一排查问题。如果问题仍未解决,请提供更详细的错误日志,以便进一步分析。

希望以上内容能帮助您解决问题!

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352