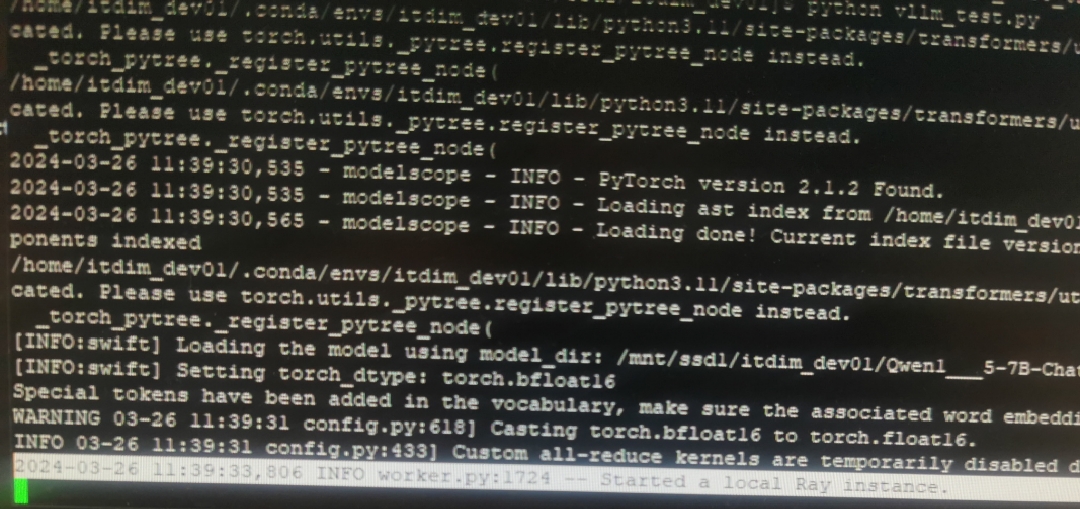

一直卡在图中ModelScope是什么问题呢?

一直卡在图中ModelScope是什么问题呢?

根据您提供的问题“一直卡在图中ModelScope是什么问题呢?”,结合知识库中的参考资料,以下是可能的原因分析及解决方法:

如果在使用ModelScope时出现卡顿或无法加载的情况,可能是由于网络连接不稳定或访问受限导致的。

- 原因:ModelScope平台依赖于云端资源,若您的网络环境无法正常访问相关服务,可能会导致加载失败或卡住。 - 解决方法: - 检查当前网络是否稳定,尝试切换到更稳定的网络环境。 - 如果您处于某些特殊网络环境下(如企业内网),可能需要设置代理以访问外部资源。

在使用ModelScope时,可能需要从云端下载模型文件。如果下载过程被中断或加载失败,会导致卡在某个步骤。 - 原因: - 下载地址不可用或网络延迟较高。 - 当前实例的存储空间不足,无法完成模型文件的保存。 - 解决方法: - 确保DSW实例的存储空间充足,并检查是否有足够的权限写入文件。 - 如果下载失败,可以尝试手动下载模型文件并上传至实例中。例如,您可以参考以下代码手动下载模型文件: python from modelscope.hub.snapshot_download import snapshot_download snapshot_download('LLM-Research/Meta-Llama-3-8B-Instruct', cache_dir='.', revision='master') 注意:确保cache_dir路径存在且可写入。

ModelScope上的模型通常对计算资源有较高要求,尤其是大语言模型(如Llama3、DeepSeek系列)。如果实例的GPU显存或CPU性能不足,可能导致加载或推理过程卡住。 - 原因: - GPU显存不足:例如,Llama3-8B模型推荐使用V100(16GB)或更高显存的GPU。 - CPU性能不足:对于某些轻量级任务,CPU性能不足也可能导致卡顿。 - 解决方法: - 检查当前实例的资源配置,确保满足模型的最低要求。 - 如果资源不足,建议升级实例规格。例如,选择Tesla系列或Ada系列显卡,并预留至少48G显存用于14B及以上模型。

在使用DSW实例时,镜像的选择和Python环境的配置可能会影响ModelScope的正常使用。 - 原因: - 镜像版本不匹配:例如,未使用推荐的镜像pai-training-algorithm/llm_deepspeed_peft:v0.0.3。 - Python版本过低:ModelScope推荐使用Python 3.9及以上版本。 - 解决方法: - 确保选择了正确的镜像,并将REGION替换为实例所属地域的代号(如cn-hangzhou)。 - 检查Python版本,必要时升级至推荐版本。

如果您是通过API调用ModelScope服务,可能是请求参数或Token配置错误导致卡住。 - 原因: - service_url或token配置错误。 - 请求格式不符合要求,例如prompt或history字段缺失。 - 解决方法: - 检查API调用代码,确保service_url和token正确无误。示例代码如下: ```python import requests import json

service_url = 'YOUR_SERVICE_URL'

token = 'YOUR_SERVICE_TOKEN'

request = {"prompt": "浙江的省会是哪里?", "history": []}

resp = requests.post(service_url, headers={"Authorization": token}, data=json.dumps(request))

result = json.loads(resp.text)

print(result['response']) # 输出:浙江的省会是杭州。

```

prompt和history字段的结构。针对“一直卡在图中ModelScope”的问题,您可以按照以下步骤逐一排查: 1. 检查网络连接,必要时设置代理。 2. 确认模型文件已成功下载,存储空间充足。 3. 核实实例资源配置是否满足模型需求。 4. 确保镜像和Python环境配置正确。 5. 检查API调用代码,确保参数和Token无误。

如果以上方法仍无法解决问题,建议联系阿里云技术支持团队,提供详细的错误日志以便进一步排查。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352