"

Merge LoRA增量权重并推理是将原模型与训练后的ModelScope模型合并么?"

不是,Merge LoRA增量权重并推理并不是简单地将原模型与训练后的ModelScope模型合并。

LoRA,即Low-Rank Adaptation,是一种用于大模型微调的技术。它允许在不改变原始大型预训练语言模型(LLM)的权重的情况下,通过添加少量的、低秩的参数来适应特定任务或数据集。这样做的好处是显著减少了微调所需的计算资源和时间,同时还能保持模型的性能。

当谈到Merge LoRA增量权重并推理时,实际上是在描述一个过程,其中LoRA的增量权重(即通过微调得到的特定于任务的参数)被合并回基础模型中。这样,合并后的模型可以增的参数来提高在特定任务上的表现。

总的来说,LoRA提供了一种高效的方式来定制大型预训练模型,使其更好地服务于特定的应用场景,而不需要对整个模型进行完整的微调。

是的,Merge LoRA增量权重并推理指的是将原模型与训练后的LoRA模型合并。

LoRA(Low-Rank Adaptation)是一种高效的微调技术,它通过在预训练模型中引入低秩矩阵来近似微调过程中的权重变化,这样可以在不显著增加模型大小的情况下实现快速的训练和良好的性能。在LoRA的训练过程中,通常会在模型的特定模块中添加可训练的秩分解矩阵,这些矩阵被称为LoRA权重。

在训练完成后,为了提高推理效率,可以使用merge_and_unload函数将LoRA增量权重与原始的基本模型合并。这样做的好处是可以消除在推理过程中由于分别加载基本模型和LoRA模型而可能遇到的延迟问题。合并后的模型可以作为一个独立的模型使用,从而提高了推理的速度和效率。

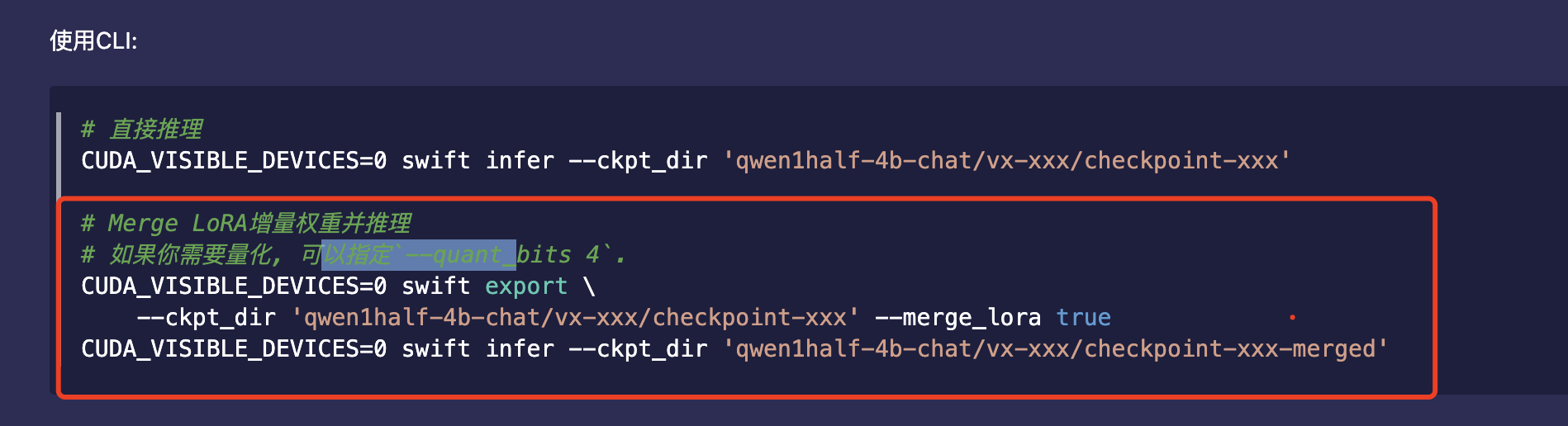

此外,合并LoRA权重的操作通常是通过命令行工具或者特定的API完成的,例如在某些工具中,可以通过指定--merge_lora true的参数来实现合并操作。这样处理后,模型可以用于直接的推理任务,而不需要额外的步骤来加载LoRA权重。

Merge LoRA增量权重并推理并不是简单地将原模型与训练后的ModelScope模型合并,而是将LoRA(Low-Rank Adaptation)的增量权重与基础模型合并。

LoRA是一种高效的微调技术,它通过在预训练模型中引入低秩矩阵来近似微调过程中的权重变化。这种方法可以在保持模型大部分参数不变的情况下,仅对少量参数进行微调,从而达到加速训练和节省内存的目的。具体来说,LoRA的工作流程包括以下几个步骤:

merge_and_unload)将LoRA增量权重与基础模型的对应权重合并。这样做可以消除在推理过程中因为分别加载基本模型和LoRA模型而产生的延迟问题。总的来说,LoRA增量权重的合并是一个优化过程,旨在提高模型微调后在实际应用中的推理效率和性能。通过这种方式,可以在不牺牲模型性能的前提下,实现快速且节省资源的模型部署。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352