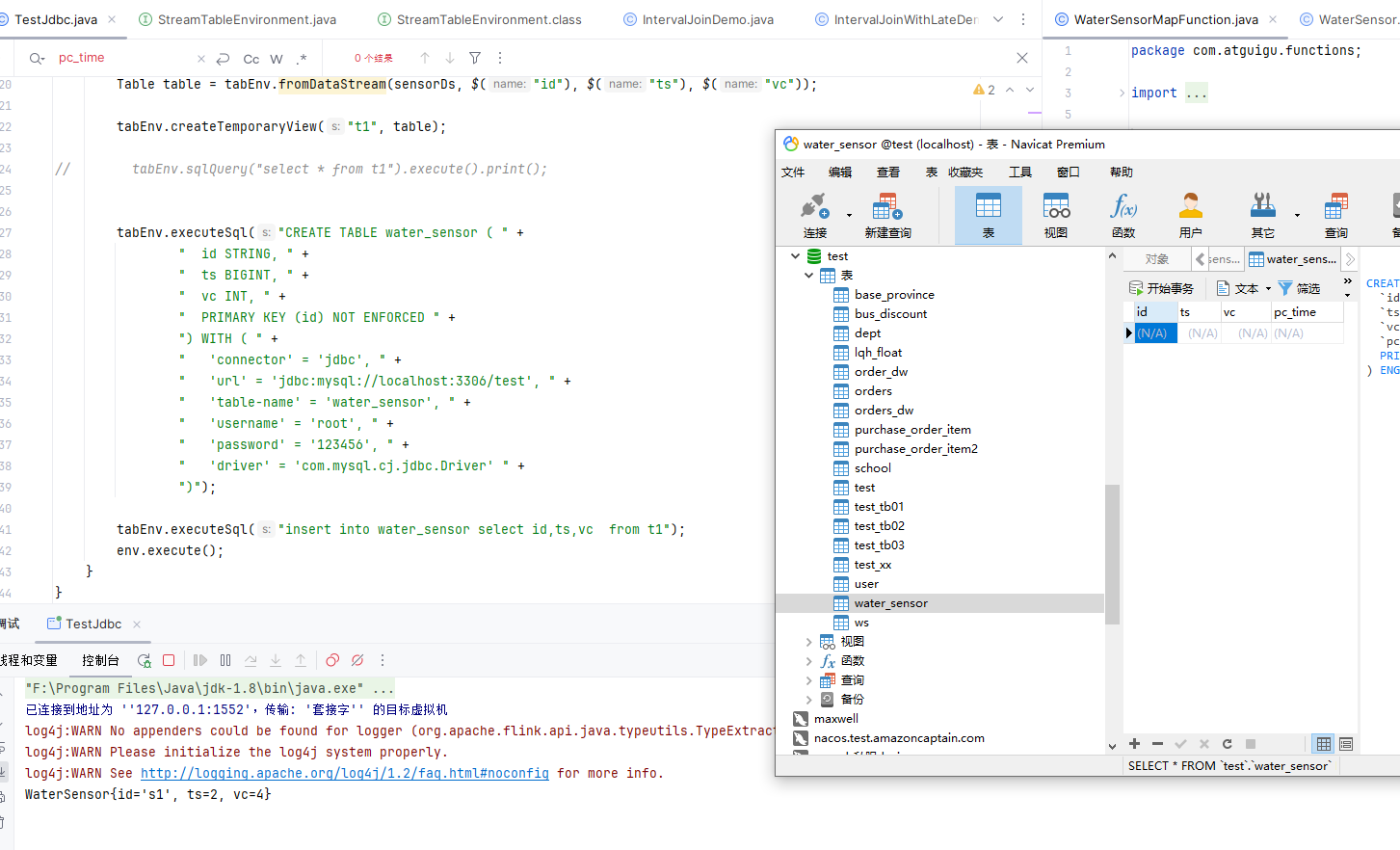

Flink CDC 里像jdbc sink有没有调试日志啊?我这里插入了数据,但是数据库就是没有。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在运行Flink作业时,可以通过配置Flink的日志级别来获取更详细的执行信息。通常可以设置log4j.properties或通过环境变量调整日志级别至DEBUG或TRACE级别,以便查看sink端的详细调试信息。

查看Flink任务管理界面或日志文件,确认Flink作业是否正常运行且Sink子任务没有异常。

特别关注与JDBC Sink相关的日志输出,包括连接数据库、发送SQL语句以及处理结果等环节是否有错误提示。

确保Flink作业中的JDBC连接参数正确无误,例如URL、用户名、密码、数据库名等。

检查所使用的数据库账号是否具有插入目标表的权限。

考虑到Flink CDC和JDBC Sink可能涉及事务性操作,确保sink配置支持所需的事务一致性和重试策略,比如启用两阶段提交(Two Phase Commit, 2PC)以增强容错能力。

如果Flink作业启用了checkpoint或savepoint,并且有数据持久化机制,可以观察checkpoint成功后sink是否正确commit了事务。

如果开启了回滚策略,在遇到失败的情况下,需要确保失败时能够正确恢复和重新尝试。

若自定义了JDBC sink实现,检查其代码逻辑确保在成功处理事件后,确实执行了INSERT或其他更新数据库的操作。

单独编写一个简单的程序,直接使用相同的JDBC连接信息插入一条数据到数据库,以排除非Flink相关的问题。

在数据库端开启审计日志或查询分析器,观察是否有来自Flink CDC的连接和插入尝试。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。