"modelscope中,部署chatGlm3怎么解决?

"

在ModelScope中部署ChatGLM3模型可以通过多种方式实现,包括使用阿里云的人工智能平台PAI、函数计算(FC)、以及基于Docker的本地部署。以下是详细的步骤和配置说明,帮助您顺利完成ChatGLM3模型的部署。

登录PAI控制台并进入EAS

自定义模型部署

modelscope-inference,并选择最高版本。ZhipuAI/chatglm3-6bchatv1.0.2ACCESS_TOKEN,值为ModelScope官网获取的访问令牌。ml.gu7i.c16m60.1-gu30,以满足大语言模型的需求。完成部署

调用服务

使用API接口调用模型服务,示例代码如下:

import requests

import json

service_url = 'YOUR_SERVICE_URL'

token = 'YOUR_SERVICE_TOKEN'

request = {"prompt": "浙江的省会是哪里?", "history": []}

resp = requests.post(service_url, headers={"Authorization": token}, data=json.dumps(request))

result = json.loads(resp.text)

print(result['response']) # 输出:浙江的省会是杭州。

创建应用

ZhipuAI/chatglm3-6bv1.0.2chatfc.gpu.tesla.1开启闲置预留模式

model-app-func的函数名称,跳转至函数详情页。LATEST,预留实例数为1,并启用闲置模式。验证部署

准备环境

ecs.g8a.4xlarge(64 GiB内存),并分配公网IP。拉取PyTorch AI容器镜像

sudo docker pull ac2-registry.cn-hangzhou.cr.aliyuncs.com/ac2/pytorch-amd:1.13.1-3.2304-zendnn4.1

sudo docker run -itd --name pytorch-amd --net host -v $HOME/workspace:/workspace \

ac2-registry.cn-hangzhou.cr.aliyuncs.com/ac2/pytorch-amd:1.13.1-3.2304-zendnn4.1

下载模型与源码

修改模型加载参数

cli_demo.py脚本,使用BF16精度加载模型以加速推理:

cd /workspace/ChatGLM3/basic_demo

grep "import torch" cli_demo.py 2>&1 >/dev/null || sed -i "3i\import torch" cli_demo.py

sed -i 's/"auto")/"auto", torch_dtype=torch.bfloat16)/g' cli_demo.py

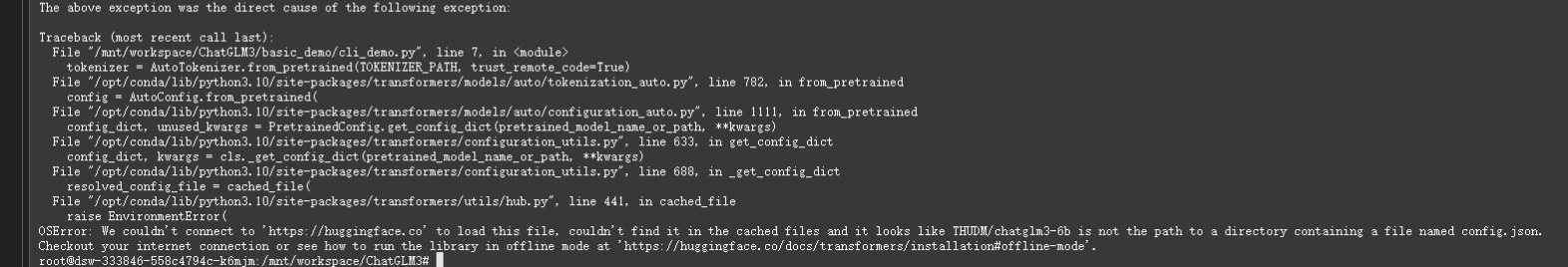

启动聊天机器人

export MODEL_PATH="/workspace/chatglm3-6b"

python3 cli_demo.py

ecs.g8a.4xlarge)。通过以上方法,您可以根据实际需求选择适合的部署方式,快速完成ChatGLM3模型的部署与调用。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352