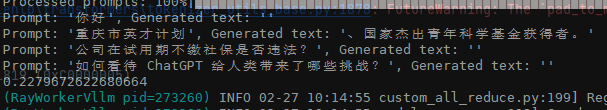

ModelScope中我的Baichuan-13B-Chat用vllm推理的时候很多答案是空的是为什么?

model_type不能传本地路径。model_type = 'baichuan2-13b-chat'

model_id_or_path = 'local_path'

get_vllm_engine(model_type, model_id_or_path=model_id_or_path)

参考:

参考:

https://github.com/modelscope/swift/blob/main/docs/source/LLM/%E6%94%AF%E6%8C%81%E7%9A%84%E6%A8%A1%E5%9E%8B%E5%92%8C%E6%95%B0%E6%8D%AE%E9%9B%86.md

此回答来自钉群魔搭ModelScope开发者联盟群 ①。

在使用VLLM进行推理时,如果您发现Baichuan-13B-Chat模型给出的很多答案是空的,这可能是由于几个原因造成的:

为了解决这个问题,您可以尝试以下几个步骤:

综上所述,在使用VLLM进行推理时,如果发现Baichuan-13B-Chat模型给出的很多答案是空的,可能是由于模型兼容性、量化问题、输入数据格式、环境配置、代码实现错误或模型损坏等原因导致的。为了解决这个问题,可以确认VLLM的支持情况、使用原始模型、检查输入数据格式、检查环境配置、查看官方文档和社区讨论,并检查代码实现。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352