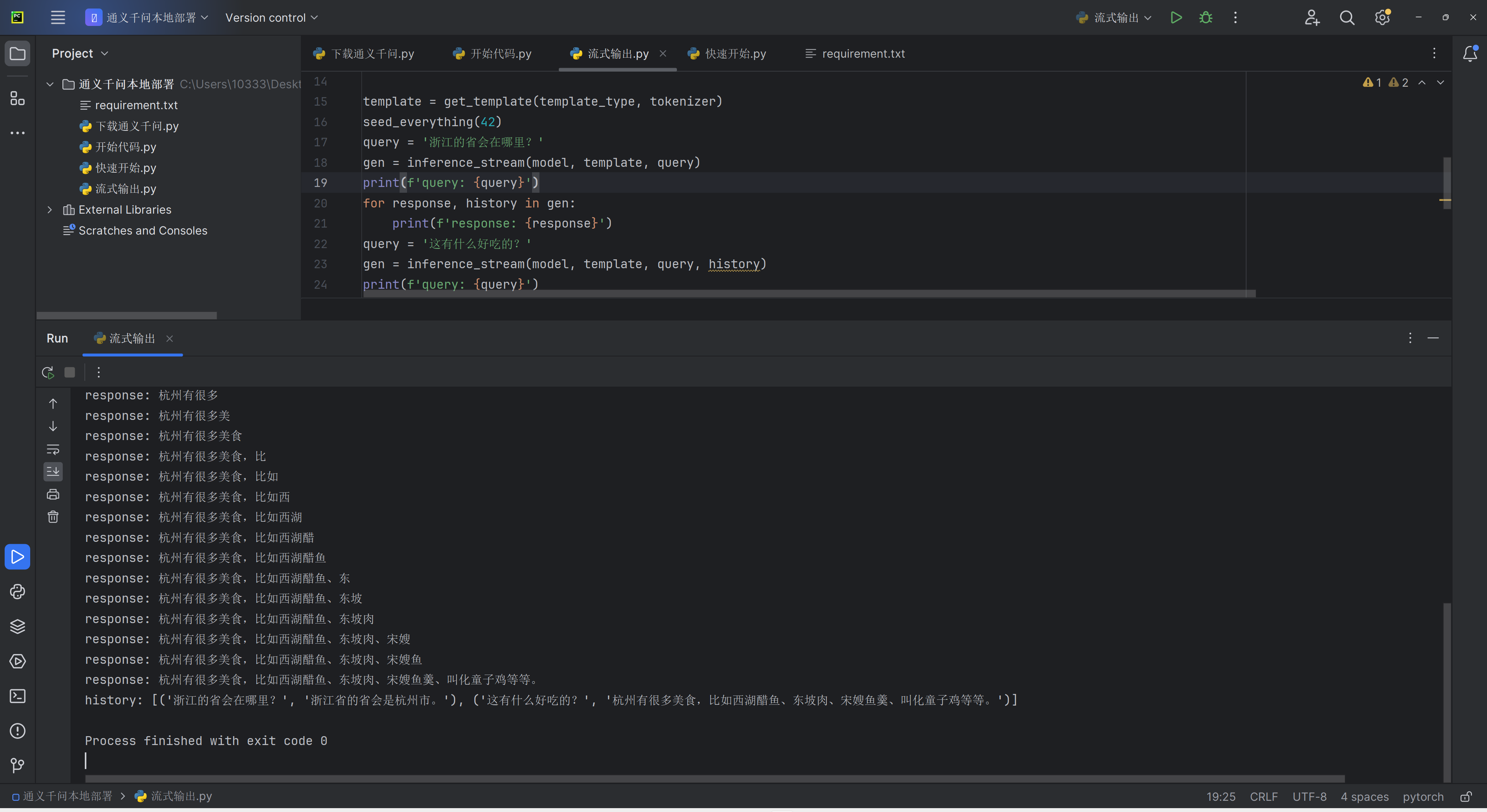

ModelScope中我运行成功了,swift的流方式输出程序,但是这个使用的好像还是网络端部署的模型,支不支持选择本地的模型呢?然后在哪里选择呢? 场景好像不太相同model_type = ModelType.qwen_7b_chat

场景好像不太相同model_type = ModelType.qwen_7b_chat

template_type = get_default_template_type(model_type)

print(f'template_type: {template_type}') # template_type: qwen

model, tokenizer = get_model_tokenizer(model_type, model_kwargs={'device_map': 'auto'})Swift的这部分代码怎么换成加载本地的模型?

ModelScope中的Swift流式输出程序支持选择本地的模型进行运行。

Swift是专门为大模型设计的流式处理框架,它允许用户在资源有限的环境中也能高效地运行大型模型。在ModelScope中,Swift框架可以帮助用户实现模型的本地部署和运行。具体来说,用户可以通过以下步骤来选择和使用本地模型:

综上所述,ModelScope的Swift流式输出程序确实支持本地模型的运行,但具体的操作步骤可能需要根据模型的特性和运行环境进行相应的调整。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352