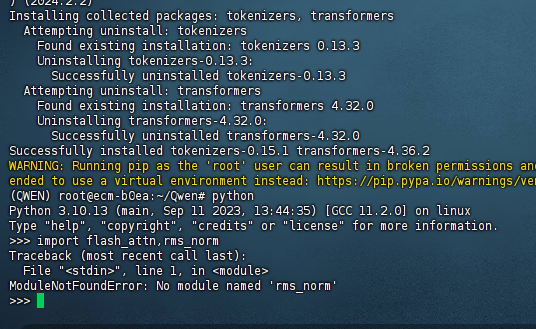

ModelScope中,transformers 4.36.2还是不行,但是运行样例不报错了?

ModelScope中,transformers 4.36.2还是不行,但是运行样例不报错了?

在ModelScope中,您提到transformers 4.36.2版本虽然不再报错,但可能存在某些功能或兼容性问题。以下是针对该问题的详细分析和解决建议:

根据知识库中的信息,transformers 4.36.2是多个镜像和运行环境中的默认版本。如果运行样例不报错,说明基础环境配置可能已经正确完成。但仍需检查以下内容: - Python版本:确保使用的是Python 3.9及以上版本(推荐Python 3.10.13)。 - 其他依赖库:transformers通常需要与torch、accelerate等库协同工作。请确认以下依赖是否已安装并匹配版本要求:

pip install torch torchvision accelerate==0.26.1 sentencepiece tiktoken

即使运行样例不报错,仍需进一步验证模型加载和推理是否正常。可以通过以下步骤进行测试: 1. 加载模型: 使用modelscope提供的snapshot_download方法下载并加载模型。例如:

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('LLM-Research/Meta-Llama-3-8B-Instruct', cache_dir='.', revision='master')

确保模型文件能够成功下载并加载到内存中。

测试推理: 加载模型后,尝试执行简单的推理任务。例如:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained(model_dir)

model = AutoModelForCausalLM.from_pretrained(model_dir)

input_text = "Hello, how are you?"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

如果推理结果正常,则说明transformers 4.36.2版本可以正常使用。

如果上述步骤仍然存在问题,可能是以下原因导致的: - 模型与transformers版本不匹配:部分模型可能对transformers版本有特定要求。建议查看模型文档,确认其支持的transformers版本范围。 - 缓存问题:有时旧版本的缓存可能导致冲突。可以尝试清理缓存并重新安装依赖:

pip uninstall transformers -y

pip install transformers==4.36.2

transformers版本如果问题仍未解决,可以尝试以下操作: - 升级到最新版本:transformers库更新频繁,建议尝试升级到最新版本:

pip install --upgrade transformers

pip install transformers==4.33.3

如果以上方法均无法解决问题,建议通过以下方式获取进一步支持: - 加入用户群:通过钉钉用户群(群号:64970014484)与函数计算工程师即时沟通。 - 查阅FAQ:参考ModelScope一键部署模型的新手村实操FAQ篇,查找类似问题的解决方案。

通过上述步骤,您可以逐步排查transformers 4.36.2在ModelScope中的问题。如果运行样例不报错但功能异常,通常是环境依赖、模型兼容性或硬件限制导致的。建议优先验证模型加载和推理功能,并根据需要调整transformers版本或硬件配置。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352