flink cdc 读pgsql 的java代码怎么写?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要使用Flink CDC读取PostgreSQL数据,您需要通过DataStream API编写Java代码,并配置相关的连接参数。以下是基于知识库资料的详细实现步骤和代码示例:

在开始编写代码之前,请确保以下条件已满足: - PostgreSQL数据库的wal_level参数设置为logical。 - 数据库用户具有LOGIN和REPLICATION权限,并且对目标表有SELECT权限。 - 已安装并配置好Flink环境,并准备好Flink CDC连接器依赖。

在项目的pom.xml文件中添加Flink CDC PostgreSQL连接器的依赖项。例如:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-postgres-cdc</artifactId>

<version>${flink-cdc.version}</version>

</dependency>

请根据实际使用的Flink版本选择对应的flink-cdc.version。

以下是一个完整的Java代码示例,用于通过Flink CDC读取PostgreSQL的数据:

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import com.ververica.cdc.connectors.postgres.PostgresSource;

import com.ververica.cdc.debezium.JsonDebeziumDeserializationSchema;

public class PostgresCDCExample {

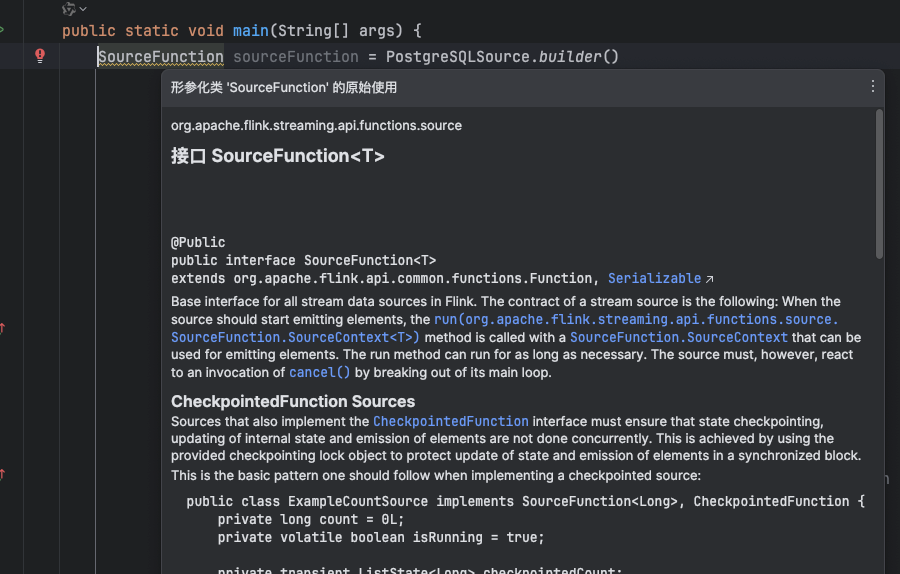

public static void main(String[] args) throws Exception {

// 创建Flink执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 配置PostgreSQL CDC Source

PostgresSource<String> postgresSource = PostgresSource.<String>builder()

.hostname("yourHostname") // PostgreSQL主机地址

.port(5432) // PostgreSQL端口,默认为5432

.database("yourDatabase") // 数据库名称

.schemaList("public") // 模式列表,多个模式用逗号分隔

.tableList("public.yourTable") // 表列表,格式为"schemaName.tableName"

.username("yourUsername") // 数据库用户名

.password("yourPassword") // 数据库密码

.deserializer(new JsonDebeziumDeserializationSchema()) // 使用JSON格式反序列化

.build();

// 将PostgreSQL CDC Source集成到Flink数据流中

env.fromSource(postgresSource, WatermarkStrategy.noWatermarks(), "PostgreSQL CDC Source")

.print(); // 输出到控制台

// 启动Flink作业

env.execute("PostgreSQL CDC Example");

}

}

JsonDebeziumDeserializationSchema将数据转换为JSON格式。REPLICATION权限,并且wal_level参数设置为logical。max_wal_senders和max_replication_slots参数,以支持更多的并发复制槽。DATE类型在Flink SQL中需要映射为TIMESTAMP类型。INSERT、UPDATE或DELETE操作,验证Flink是否能够实时捕获这些变更。通过以上步骤,您可以成功使用Flink CDC读取PostgreSQL的数据。如果有其他需求(如自定义反序列化器或处理复杂数据结构),可以根据具体场景进一步扩展代码逻辑。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。