用微调后ModelScope推理有报错?

在使用微调后的ModelScope模型进行推理时,如果遇到报错,可以参考以下步骤进行排查和解决。以下是详细的解决方案:

确保推理服务的运行环境与微调时的环境一致,包括Python版本、依赖库版本以及GPU驱动等。

modelscope和transformers等核心库的版本是否匹配。例如:

pip install modelscope==1.12.0 transformers==4.37.0

fp16计算类型;如果使用A10显卡,建议选择bf16。微调后的模型文件可能在下载或传输过程中损坏,导致推理失败。

from modelscope.hub.snapshot_download import snapshot_download

snapshot_download('您的模型ID', cache_dir='.', revision='master')

推理请求的输入参数格式错误是常见的报错原因。

请求格式:确保请求体符合ModelScope的API规范。例如:

curl -XPOST http://localhost:8000/generate \

-H "Content-Type: application/json" \

-d '{"text_input": "什么是人工智能?", "parameters": {"stream": false, "temperature": 0.9, "seed": 10}}'

text_input:输入文本必须为字符串。parameters:参数如temperature、seed等需符合模型支持的范围。数据预处理:如果微调时对数据进行了特殊处理(如分词、截断等),推理时也需要保持一致。

推理服务的配置不当可能导致服务无法正常启动或响应。

GPU资源分配:确保推理服务分配了足够的GPU资源。例如:

-gpus 1 -replicas 1

如果GPU资源不足,可能会导致服务启动失败。

就绪探针配置:检查readiness-probe配置是否正确。例如:

-readiness-probe-action HttpGet

-readiness-probe-option "/health"

如果上述步骤未能解决问题,可以通过查看服务日志定位具体错误。

查看Pod日志:

kubectl logs <pod-name> -n <namespace>

日志中通常会包含具体的错误信息,例如模型加载失败、依赖缺失等。

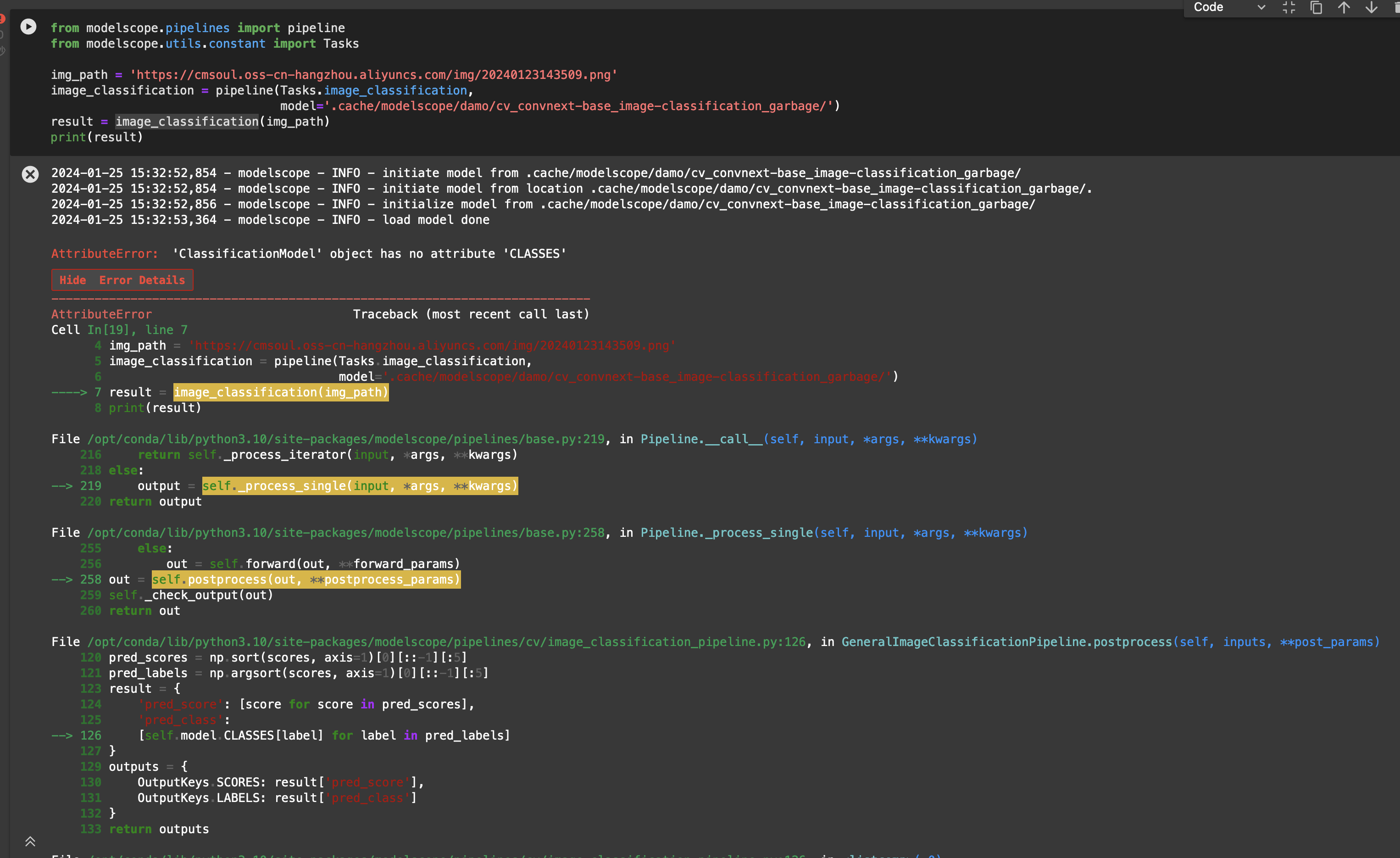

常见错误及解决方法:

如果问题仍未解决,可以通过以下方式联系技术支持团队获取帮助:

通过以上步骤,您应该能够有效排查和解决微调后ModelScope推理报错的问题。如果仍有疑问,请提供具体的错误日志以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352