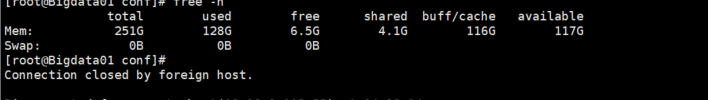

Flink CDC里这个cache内存咋占用那么大 怎么才能让它把资源释放出来 ?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC的缓存内存占用较大可能是由于以下几个原因导致的:

数据量过大:如果CDC源的数据量非常大,缓存中需要存储大量的数据,从而导致缓存内存占用较大。可以考虑通过调整并行度或者使用分区来减少单个任务处理的数据量,从而降低缓存内存的占用。

缓存配置不合理:Flink CDC提供了一些缓存相关的配置参数,例如debezium-source.buffer-flush.max-rows用于控制缓存中最大行数,debezium-source.buffer-flush.interval用于控制缓存刷新的时间间隔。可以尝试调整这些参数来减小缓存内存的占用。

长时间运行:如果Flink CDC任务长时间运行,缓存中的数据可能会逐渐积累,导致内存占用逐渐增加。可以尝试定期清理缓存,释放不再需要的数据。

其他因素:除了上述原因外,还可能存在其他因素导致缓存内存占用较大,例如数据结构设计不合理、内存泄漏等。可以通过分析任务的内存使用情况,找出具体的原因并进行优化。

针对以上情况,可以尝试以下方法来释放缓存内存:

调整缓存配置:根据实际需求和数据量大小,合理调整缓存相关的配置参数,例如减小缓存的最大行数或者缩短缓存刷新的时间间隔。

清理缓存:在合适的时机,手动触发缓存的清理操作,释放不再需要的数据。可以通过调用clear()方法来清空缓存。

优化数据处理逻辑:检查数据处理的逻辑,确保没有不必要的数据存储或者冗余的操作。优化数据结构,减少内存占用。

重启任务:如果缓存内存占用过大且无法通过调整配置或者清理缓存来解决,可以考虑重启任务,释放缓存内存并重新开始处理数据。

Apache Flink CDC(Change Data Capture)在处理数据流时可能会积累大量的内存,尤其是当捕获的数据量较大或处理过程中存在状态存储时。Flink CDC任务取消后,如果内存没有及时释放,可能是因为以下几个原因:

状态后置清理:

堆外内存(Off-heap Memory):

资源泄漏:

Flink内部缓存或队列:

解决Flink CDC内存占用过大的问题,可以尝试以下措施:

总的来说,优化Flink CDC内存管理的关键在于合理配置和有效监控任务运行状态。如果问题持续存在,建议深入分析Flink的日志和监控指标,以便定位具体的问题根源。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。