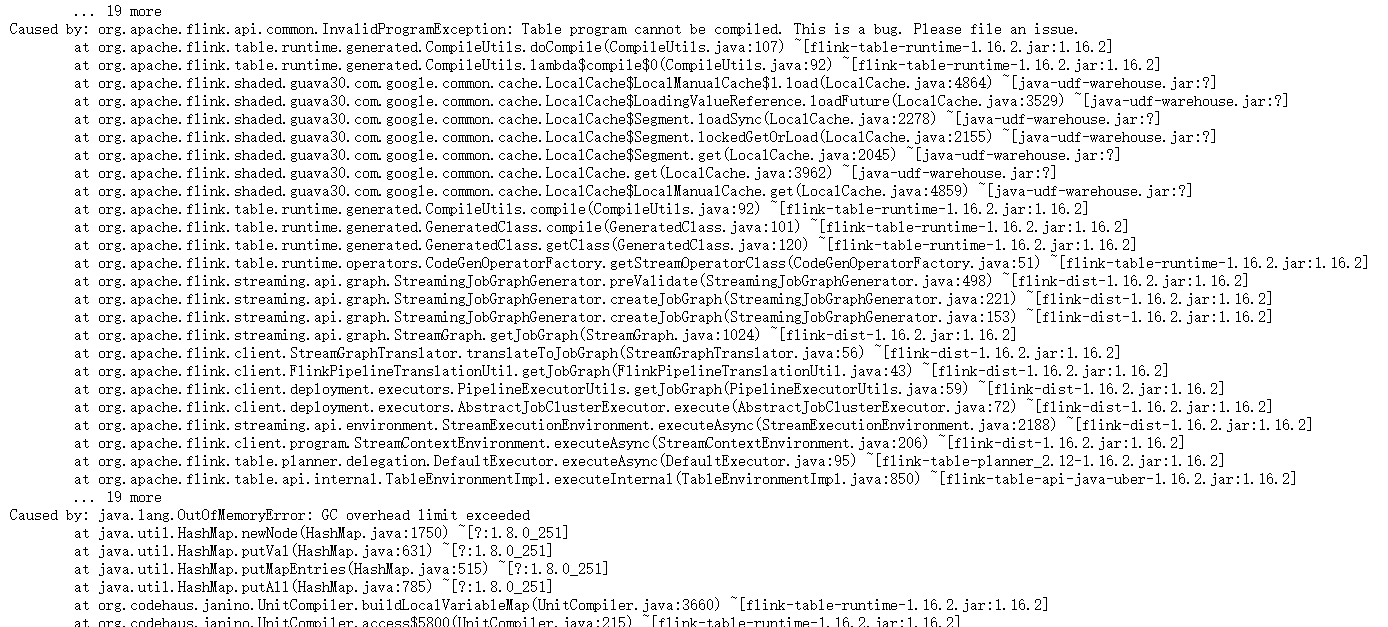

请教一个问题,flink1.16.2 sink doris,使用table api字段数超过100个就会提示如下异常,有哪些参数可以调整优化呀?

错误日志报的是oom,但是没找到参数能优化

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的信息,当使用Flink 1.16.2的Table API将数据sink到Doris时,如果字段数超过100个,会提示异常。这可能是由于Doris对单个查询中的最大字段数有限制导致的。

为了解决这个问题,您可以尝试以下几种方法:

优化查询语句:在查询语句中使用投影操作符(SELECT)来选择需要的字段,而不是选择所有字段。这可以减少查询中的字段数量,从而避免触发异常。

分批处理:如果您的数据量很大,可以考虑将数据分成多个批次进行处理。每个批次包含较少的字段,这样可以避免一次性处理过多的字段导致异常。

调整Doris配置:您可以尝试调整Doris的配置参数,例如增加最大字段数的限制。但是这种方法需要对Doris的配置和优化有一定的了解,并且可能会影响Doris的性能。

使用其他存储系统:如果Doris无法满足您的需求,您可以考虑使用其他支持更多字段的存储系统,例如Apache Kafka或Apache Cassandra。这些存储系统可以更好地处理大量字段的数据。

总之,要解决此问题,您需要根据实际情况选择合适的方法进行优化。

代码编译相关 建议调一下 metadata space 元数据区(Metaspace) ,此回答整理自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。