有没有 知道 flink on k8s operator , operator 默认添加的这个 confimap 我怎么修改啊 ?我重新制作了一个flink 镜像 修改了 log4j-console.properties 但是容器启动后 还是用 原来 的log4j-console.properties

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

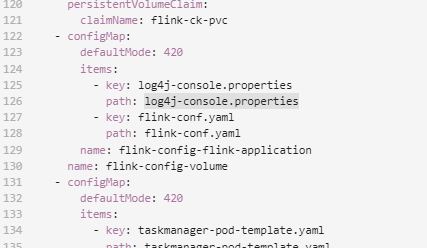

要修改 Flink 在 Kubernetes 上运行的 operator 默认添加的 configmap,你可以按照以下步骤操作:

首先,找到你的 Flink 镜像。如果你已经重新制作了一个镜像并修改了 log4j-console.properties,那么你需要确保这个镜像已经被推送到 Docker Hub 或者其他容器镜像仓库中。

在你的 Kubernetes 集群中,创建一个名为 flink-configmap 的 configmap,并将修改后的 log4j-console.properties 文件作为数据添加到这个 configmap 中。例如:

apiVersion: v1

kind: ConfigMap

metadata:

name: flink-configmap

data:

log4j-console.properties: |

# 在这里添加你的修改内容

flink-conf.yaml)中指定使用这个新的 configmap,如下所示:jobmanager.rpc.address: jobmanager-service

jobmanager.rpc.port: 6123

taskmanager.numberOfTaskSlots: 2

taskmanager.network.numberOfBuffers: 128000

taskmanager.network.memory.min: 64mb

taskmanager.network.memory.max: 1gb

taskmanager.network.memory.fraction: 0.75

taskmanager.network.memory.large.fraction: 0.9

taskmanager.heap.off-heap.size: 1g

taskmanager.heap.off-heap.fraction: 0.2

state.backend: rocksdb

state.backend.rocksdb.localdir: hdfs://namenode:9000/flink/checkpoints

state.backend.rocksdb.async: true

state.backend.rocksdb.writebuffersize: 64mb

state.backend.rocksdb.writebuffercount: 4

state.backend.rocksdb.compactionstyle: level

state.backend.rocksdb.compactionthreshold: 64mb

state.backend.rocksdb.subcompactions: minor

state.backend.rocksdb.avoid-direct-i/o: false

state.backend.rocksdb.use-direct-io-for-column-family: true

state.backend.rocksdb.background-flush: true

state.backend.rocksdb.sync: true

state.backend.rocksdb.lock-on-bulkload: false

state.backend.rocksdb.rocksdb-version: 6.24.0

state.backend.rocksdb.native-lib-path: /usr/lib/librocksdb.so

state.backend.rocksdb.localdb-dir: hdfs://namenode:9000/flink/localdb

state.backend.rocksdb.localdb-async: true

state.backend.rocksdb.localdb-writebuffersize: 64mb

state.backend.rocksdb.localdb-writebuffercount: 4

state.backend.rocksdb.localdb-compactionstyle: level

state.backend.rocksdb.localdb-compactionthreshold: 64mb

state.backend.rocksdb.localdb-subcompactions: minor

state.backend.rocksdb.localdb-avoid-direct-i/o: false

state.backend.rocksdb.localdb-use-direct-io-for-column-family: true

state.backend.rocksdb.localdb-background-flush: true

state.backend.rocksdb.localdb-sync: true

state.backend.rocksdb.localdb-lock-on-bulkload: false

state.backend.rocksdb.localdb-rocksdb-version: 6.24.0

state.backend.rocksdb.localdb-native-lib-path: /usr/lib/librocksdb.so

logger.file: hdfs://namenode:9000/flink/logs/flink-%d{yyyy-MM-dd-HH-mm}.log

flink-conf.yaml 文件中,添加以下配置:env.java.opts: "-Dlog4j.configuration=file:/etc/flink/conf/log4j-console.properties"

这样,你的 Flink 作业或任务应该能够使用你修改后的 log4j-console.properties 文件了。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。