启动的时候加载模型提示错误,加了ignore_mismatched_sizes=True对modelscope解析结果产生影响?

启动的时候加载模型提示错误,加了ignore_mismatched_sizes=True对modelscope解析结果产生影响?

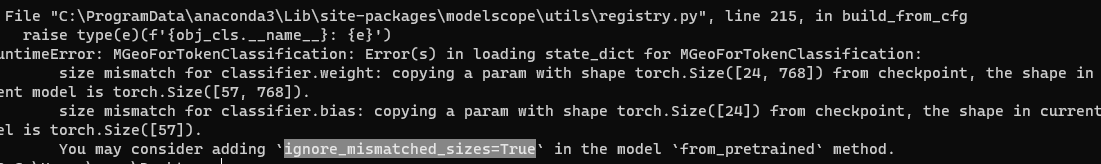

在使用ModelScope加载模型时,如果启动时提示错误,并通过添加ignore_mismatched_sizes=True参数来解决,可能会对模型的解析结果产生一定影响。以下是详细分析和解决方案:

当加载预训练模型时,如果模型权重文件中的某些层或参数与当前模型定义不匹配(例如,模型结构被修改或部分参数缺失),PyTorch会抛出错误。为了解决这一问题,可以通过设置ignore_mismatched_sizes=True来忽略这些不匹配的部分。

然而,这种操作可能会导致以下影响: - 部分参数未加载:模型中与权重文件不匹配的层将不会加载预训练权重,而是使用随机初始化。 - 性能下降:由于部分参数未经过预训练,模型在推理或微调时的表现可能不如预期。 - 潜在的推理错误:如果未加载的参数对模型的关键功能有重要影响,可能会导致推理结果不符合预期。

在ModelScope中,模型加载通常依赖于预定义的模型结构和权重文件。如果启用了ignore_mismatched_sizes=True,可能会出现以下情况: - 模型输出偏差:未加载的参数可能导致模型输出的结果与标准预训练模型存在偏差。 - 特定任务表现下降:对于需要高精度的任务(如问答、生成等),未加载的参数可能会影响模型的推理能力。 - 日志警告信息:ModelScope可能会记录相关警告信息,提示哪些参数未被加载。

为了避免ignore_mismatched_sizes=True对模型解析结果的影响,可以采取以下措施:

ignore_mismatched_sizes=True,可以手动初始化未加载的参数,以减少随机初始化带来的影响。例如:

for name, param in model.named_parameters():

if param.requires_grad and param not in loaded_params:

torch.nn.init.xavier_uniform_(param)

这段代码会对未加载的参数进行Xavier初始化,从而提高模型的稳定性。

input_text = "什么是人工智能?"

output = model.generate(input_text)

print(output)

如果输出结果异常,可能需要重新检查模型加载过程。

ModelScope提供了标准化的模型加载流程,建议优先使用其默认加载方式,避免手动调整参数。例如:

from modelscope import AutoModel, AutoTokenizer

model = AutoModel.from_pretrained("qwen/Qwen1.5-4B-Chat", ignore_mismatched_sizes=False)

tokenizer = AutoTokenizer.from_pretrained("qwen/Qwen1.5-4B-Chat")

通过设置ignore_mismatched_sizes=True可以解决模型加载时的不匹配问题,但可能会对模型的解析结果产生一定影响。建议优先确保模型结构与权重文件的一致性,并在必要时手动初始化未加载的参数。同时,验证模型输出和检查日志信息是确保加载成功的重要步骤。

如果您仍有疑问或需要进一步的帮助,请提供更多上下文信息,我们将为您深入分析并提供支持。