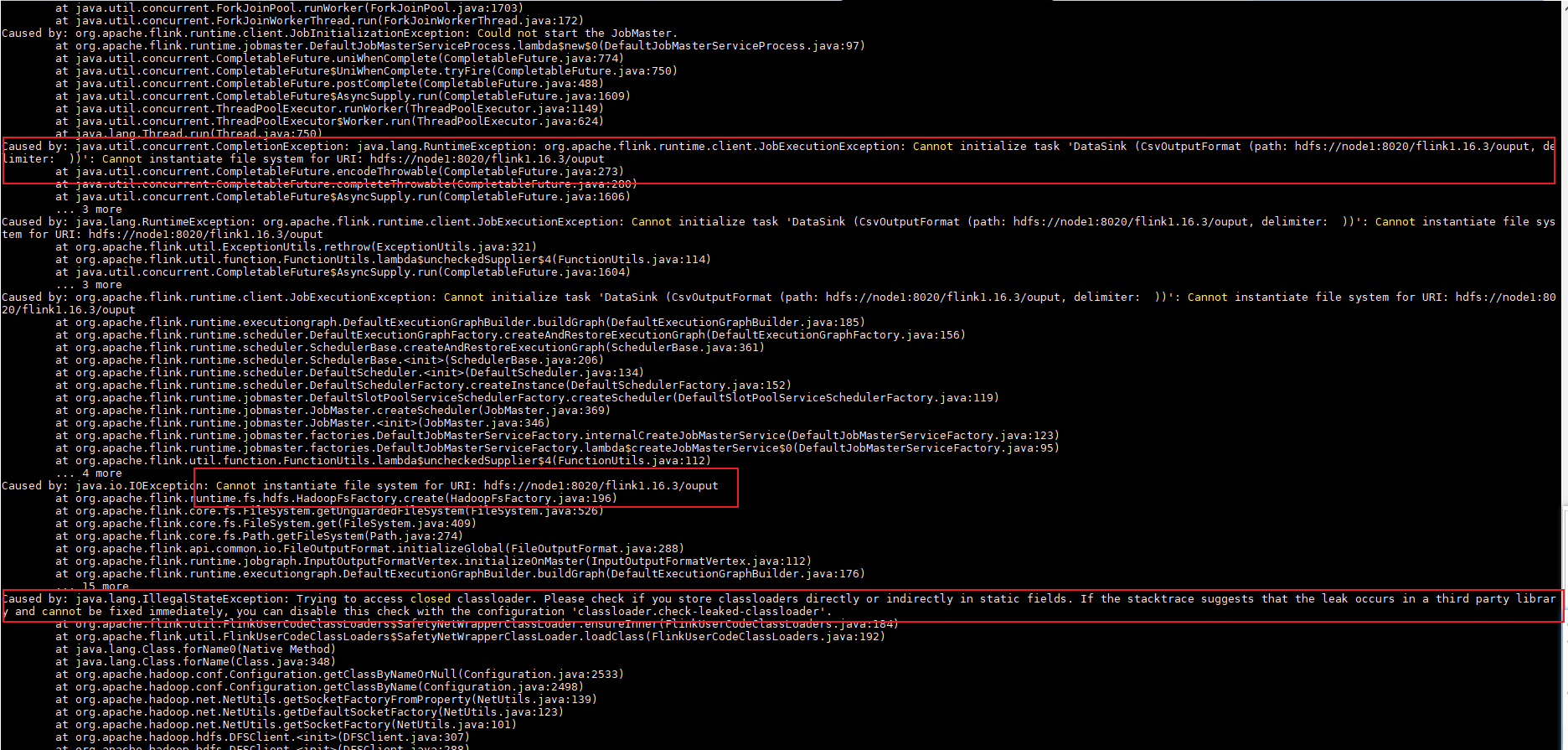

Flink报错怎么解决?flink on yarn 模式 跑wordcount run ./examples/batch/WordCount.jar --input hdfs://node1:8020/flink1.16.3/input/wordcount.txt --output hdfs://node1:8020/flink1.16.3/ouput 报错 hdfs dfs -ls 可以正常执行

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink报错可能是由于多种原因导致的,以下是一些建议来解决这个问题:

检查Flink版本是否与Hadoop和YARN版本兼容。确保你使用的Flink版本与你的Hadoop和YARN集群版本兼容。

检查HDFS路径是否正确。确保输入和输出文件的HDFS路径是正确的,并且文件确实存在于该路径下。

检查网络连接。确保你的应用程序可以访问HDFS集群。你可以尝试在本地运行一个简单的HDFS命令,例如hdfs dfs -ls /,以确保HDFS集群正常运行。

检查Flink配置文件。确保你的Flink配置文件(如flink-conf.yaml)中的配置项正确设置。特别是关于HDFS的配置,例如fs.defaultFS、yarn.application-master等。

查看Flink日志。Flink会在运行时生成日志文件,这些日志文件可能会提供有关错误的详细信息。你可以查看这些日志文件以获取更多关于错误的信息。

使用Flink的Web界面。Flink提供了一个Web界面,你可以在其中查看作业的状态、进度和错误信息。这可以帮助你更好地了解问题所在。

如果以上方法都无法解决问题,你可以尝试在Flink社区论坛或GitHub仓库中寻求帮助。在那里,你可以与其他用户交流,分享你的经验和解决方案。

Flink报错可能有多种原因,以下是一些建议的解决方法:

检查Flink配置文件:确保Flink配置文件(flink-conf.yaml)中的配置项正确。例如,检查HDFS的配置是否正确。

检查HDFS状态:使用hdfs dfsadmin -report命令查看HDFS集群的状态,确保所有节点都处于正常状态。

检查网络连接:确保Flink和HDFS之间的网络连接正常。可以使用ping命令测试网络连通性。

检查JAR文件:确保WordCount.jar文件存在且没有损坏。可以尝试从其他节点复制该文件到当前节点。

检查输入输出路径:确保输入和输出路径在HDFS上存在且具有正确的权限。可以使用hdfs dfs -ls命令查看路径是否存在。

查看日志:查看Flink和YARN的日志文件,以获取更多关于错误的详细信息。日志文件通常位于$FLINK_HOME/log目录下。

重启Flink和YARN:如果问题仍然存在,尝试重启Flink和YARN集群。

升级Flink版本:如果以上方法都无法解决问题,可以考虑升级Flink到最新版本,或者降级到一个已知正常工作的版本。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。