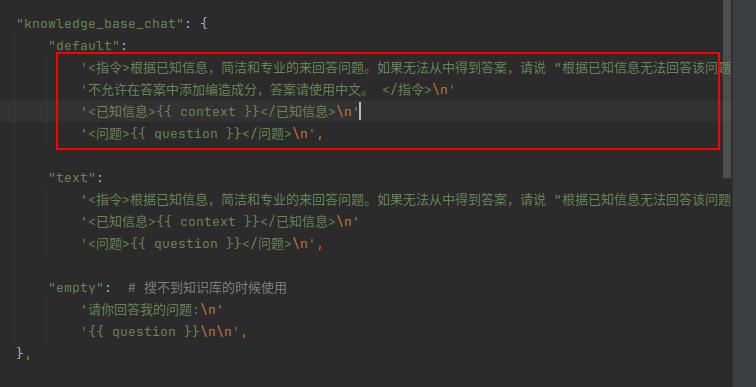

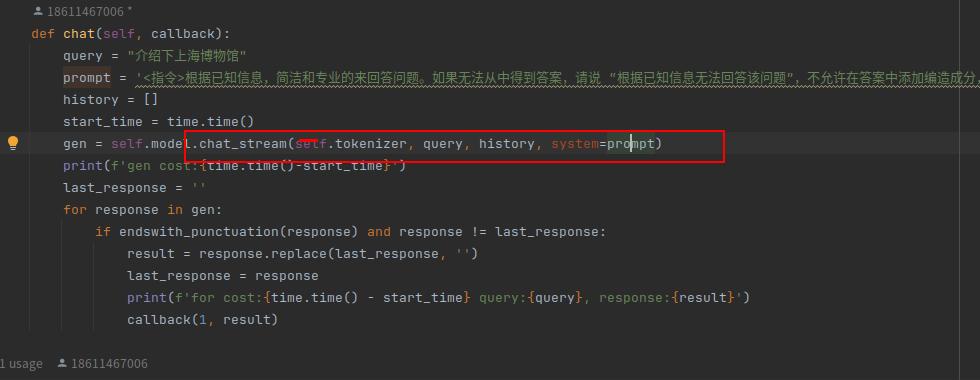

langchain里的prompt,怎么用modelscope实现?有类似第二张图的例子吗?

要在LangChain中使用ModelScope实现Prompt,你可以按照以下步骤进行操作:

安装必要的依赖项:确保你已经安装了LangChain和ModelScope的相关库。你可以使用pip命令来安装它们,例如:

pip install langchain modelscope

导入所需的模块:在你的代码中,导入LangChain和ModelScope的相关模块。例如:

from langchain import PromptTemplate, LLMChain

from modelscope.utils.logger import get_logger

创建PromptTemplate对象:创建一个PromptTemplate对象,用于定义你的Prompt模板。你可以指定模板的名称、问题和回答的格式等。例如:

prompt_template = PromptTemplate(name="my_prompt", question="What is the capital of France?", answer_format="The capital of France is {capital}.")

创建LLMChain对象:创建一个LLMChain对象,并将PromptTemplate对象作为参数传递给它。你还可以指定其他参数,如语言模型名称、模型路径等。例如:

llm_chain = LLMChain(prompt_template=prompt_template, language_model="path/to/your/language/model")

使用LLMChain对象进行推理:现在你可以使用LLMChain对象来进行推理了。调用run()方法并传入一个包含问题的字符串作为参数,它将返回一个包含答案的字符串。例如:

question = "What is the capital of France?"

answer = llm_chain.run(question)

print(answer)

这样,你就可以使用ModelScope在LangChain中实现Prompt了。记得根据你的具体需求修改PromptTemplate和LLMChain对象的参数。

有的, https://github.com/modelscope/modelscope/blob/master/examples/pytorch/application/qwen_doc_search_QA_based_on_langchain.ipynb

此回答整理至钉群“魔搭ModelScope开发者联盟群 ①”