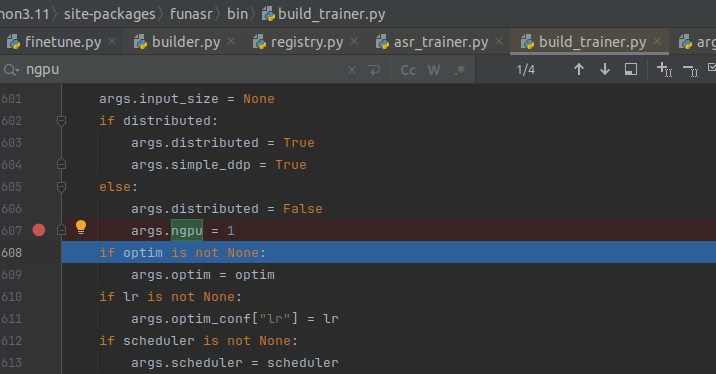

modelscope-funasr这里写死了ngpu=1,是不是只能用n卡训练,不能用CPU来跑了?

根据您提出的问题,关于modelscope-funasr是否只能使用GPU(即ngpu=1)进行训练而不能使用CPU运行,以下是详细解答:

在modelscope-funasr中,代码中写死了ngpu=1,这表明默认情况下模型的训练或推理是基于单张GPU进行的。然而,这并不一定意味着该模型完全无法在CPU上运行。需要进一步分析其底层实现逻辑以及是否支持CPU模式。

从知识库资料和常见实践来看,以下几点可以帮助判断是否可以使用CPU运行:

在PAI平台中,模型训练和推理的资源配置是可以灵活调整的。例如,在模型部署时可以选择不同的实例规格,包括仅使用CPU资源的情况。如果modelscope-funasr的实现允许通过环境变量或配置文件指定设备类型(如device=cpu),则可以在CPU上运行。

在分布式训练场景中,TorchAcc等优化工具通常会针对GPU进行性能优化,但并不完全排除CPU的支持。例如,在某些场景下,可以通过设置-cpu-offload参数来开启CPU负载训练。如果modelscope-funasr依赖类似的机制,则可能支持CPU运行。

如果modelscope-funasr的代码中明确绑定了GPU设备(如torch.cuda.is_available()或device='cuda'),则需要手动修改代码以支持CPU运行。例如,将设备设置改为:

device = 'cpu' if not torch.cuda.is_available() else 'cuda'

这样可以确保在没有GPU的情况下自动切换到CPU。

如果您希望在CPU上运行modelscope-funasr,可以尝试以下步骤:

查看modelscope-funasr的配置文件或启动脚本,确认是否有类似device或ngpu的参数可以调整。如果有,将其设置为cpu或ngpu=0。

如果配置文件中没有相关选项,可以直接修改代码中的设备绑定逻辑。例如: - 将device='cuda'替换为device='cpu'。 - 确保所有涉及CUDA的操作(如.cuda()或.to('cuda'))改为.to('cpu')。

完成上述修改后,尝试在CPU环境下运行模型,并观察是否能够正常执行。如果遇到显存相关的错误(如CUDA out of memory),说明代码仍然存在对GPU的强依赖,需要进一步排查。

modelscope-funasr支持CPU运行,由于CPU的计算能力远低于GPU,训练或推理速度可能会显著下降。建议仅在测试或轻量级任务中使用CPU模式。modelscope-funasr默认设置ngpu=1并不意味着完全无法使用CPU运行。通过调整配置文件或修改代码中的设备绑定逻辑,可以实现CPU模式下的运行。但在实际操作中,需注意性能差异和硬件限制。

如果您需要更具体的代码修改指导或配置示例,请提供modelscope-funasr的相关代码片段或配置文件内容,以便进一步协助您解决问题。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352