在分析 modelscope-funasr 流式模型训练损失异常的原因时,可以从以下几个方面进行排查和分析。以下是基于知识库资料的详细解答:

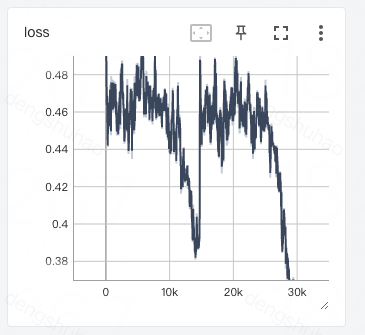

1. 训练损失逐渐减小而验证损失逐渐增大

这种情况通常表明模型已经过拟合训练数据,导致模型在训练集上表现良好,但在验证集上的泛化能力较差。可能的原因及解决方法如下:

可能原因:

- 训练数据不足或多样性不够:模型过度学习了训练数据中的噪声或特定模式。

- 模型复杂度过高:模型参数过多,容易对训练数据进行过度拟合。

解决方法(推荐程度有先后顺序):

- 使用数据增强:通过增加训练数据的多样性和数量,提升模型的泛化能力。

- 收集更多训练数据:扩充训练数据集,确保数据分布更接近真实场景。

- 调整超参数:

- 减少“训练次数”(Epochs)。

- 减小“学习率”,避免模型在训练后期过度优化。

- 减小“批次大小”(Batch Size),以增加梯度更新的随机性。

- 增大“权重衰减”(Weight Decay),限制模型复杂度。

- 提高“LoRA丢弃率”(Dropout Rate),减少过拟合风险。

- 提高“学习率预热比例”(Warmup Ratio),使学习率在训练初期更加平滑。

2. 训练损失没有明显变化或逐渐增大

这种情况通常表明模型欠拟合训练数据,可能是由于模型未能充分学习训练数据中的模式。可能的原因及解决方法如下:

可能原因:

- 数据质量问题:训练数据中存在噪声、错误标注或不一致的数据。

- 模型容量不足:模型复杂度不足以捕捉训练数据中的特征。

- 超参数设置不合理:学习率过低、训练次数不足等。

解决方法(推荐程度有先后顺序):

- 检查数据质量:

- 确保数据清洗充分,去除噪声和错误标注。

- 检查输入数据格式是否符合要求,例如 JSON 或 JSONL 文件格式是否正确。

- 调整超参数:

- 增大“训练次数”(Epochs),让模型有更多机会学习数据。

- 增大“学习率”,提高模型的学习效率。

- 增大“批次大小”(Batch Size),以稳定梯度更新。

- 减小“权重衰减”(Weight Decay),避免过度正则化。

- 降低“LoRA丢弃率”(Dropout Rate),减少信息丢失。

- 降低“学习率预热比例”(Warmup Ratio),使学习率更快达到目标值。

3. 硬件或系统问题导致的训练失败

如果训练任务因硬件或系统问题中断,可能会导致训练损失异常。以下是一些常见问题及其排查方法:

常见问题及解决方法:

- 内存不足(OOM, Out of Memory):

- 错误信息示例:

torch.cuda.OutOfMemoryError: CUDA out of memory。

- 解决方法:选择显存更大的 GPU 机型,或降低涉及显存的相关超参数配置(如 LoRA 维度、批次大小等)。

- 输入/输出路径错误:

- 错误信息示例:

ValueError: output channel ${your OSS uri} must be directory。

- 解决方法:检查输入/输出路径是否为文件夹,确保路径具有正确的读写权限。

- 机型资源不足:

- 错误信息示例:

Exception: Current loss scale already at minimum - cannot decrease scale anymore. Exiting run。

- 解决方法:建议使用 Ampere 或更先进架构的 GPU(如 A10/A100)进行训练。

4. 流式模型特有的问题

对于 modelscope-funasr 流式模型,可能存在以下特有问题需要关注:

数据流处理问题:

- 数据流延迟或中断:流式模型依赖实时数据流,如果数据流出现延迟或中断,可能导致训练损失异常。

- 数据格式不匹配:流式模型对输入数据格式有严格要求,若格式不符合预期,可能导致训练失败。

解决方法:

- 确保数据流的稳定性和连续性。

- 检查输入数据格式是否符合模型要求,例如音频采样率、编码格式等。

5. 其他注意事项

- Checkpoint机制:如果训练任务频繁中断,建议启用高性能 Checkpoint 机制(如 EasyCkpt),以减少重新计算的时间和成本。

- 日志排查:通过查看任务日志,定位具体的错误信息并采取相应措施。

总结

根据上述分析,modelscope-funasr 流式模型训练损失异常的原因可能包括过拟合、欠拟合、硬件问题或数据流处理问题。建议按照以下步骤逐步排查和优化: 1. 检查训练损失与验证损失的变化趋势,判断是否存在过拟合或欠拟合。 2. 调整超参数和数据集,优化模型性能。 3. 排查硬件和系统问题,确保训练环境稳定。 4. 针对流式模型特性,确保数据流的稳定性和格式正确。

如果问题仍未解决,建议进一步查看任务日志或提交工单获取技术支持。