ModelScope如何配置model_config.json?agent里面要是加载本地的模型,是不是需要在model_config.json加入type=custom_llm?

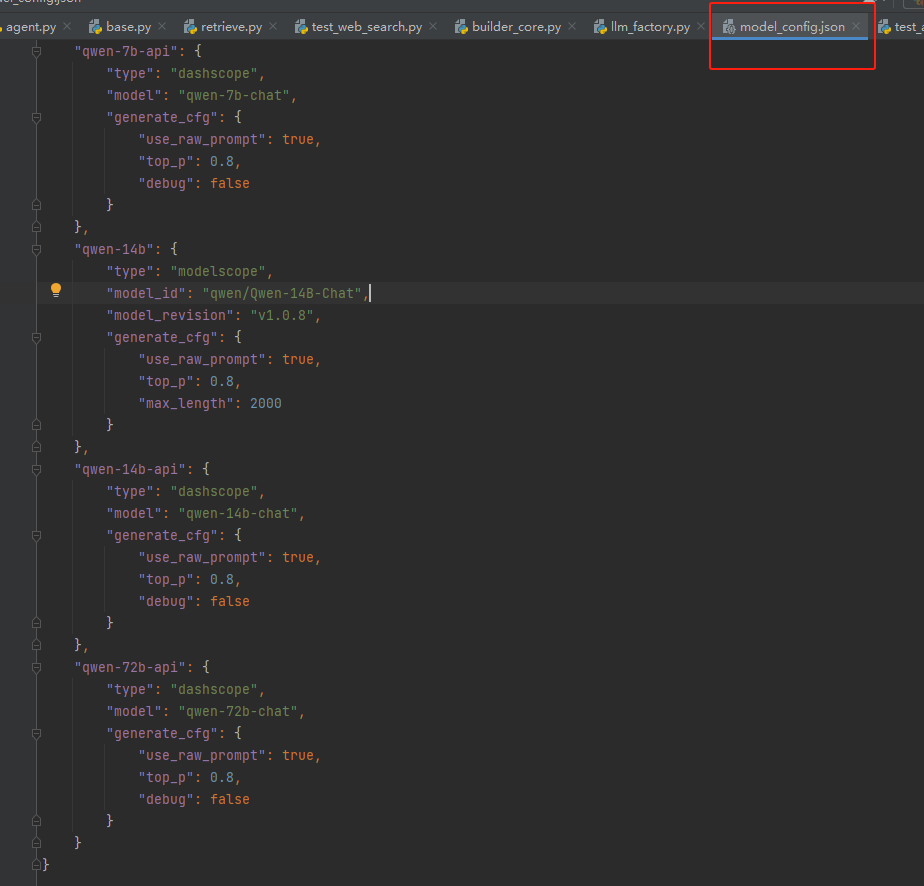

在ModelScope中配置model_config.json文件,你需要根据你所使用的模型类型和需求来定制。以下是一个基本的model_config.json配置文件的示例:

{

"model_type": "custom_llm", // 如果你加载的是自定义的大规模语言模型(LLM),则可以设置为"custom_llm"

"model_name_or_path": "/path/to/your/local/model", // 这里填写你的本地模型路径

"cache_dir": "/path/to/cache", // (可选)如果需要使用缓存,指定缓存目录

"use_cuda": true, // (可选)如果你希望在GPU上运行,设置为true

"device": 0, // (可选)如果你有多块GPU,指定要使用的GPU设备编号

"tokenizer_name": "your_tokenizer_name", // (可选)如果你的模型使用了特定的分词器,指定分词器名称

"config_name": "your_config_name", // (可选)如果你的模型有单独的配置文件,指定配置文件名称

"revision": "your_model_revision", // (可选)如果你的模型有特定的版本或修订,指定版本或修订号

"kwargs": { // (可选)其他特定于模型的参数

"example_key": "example_value"

}

}

请注意以下几点:

model_type: 根据你的模型类型来设置,如果加载的是自定义的大规模语言模型,可以设置为custom_llm,但具体取决于ModelScope支持的模型类型。model_name_or_path: 这里需要填写你的本地模型的实际路径。use_cuda: 如果你想在GPU上运行模型,将此选项设置为true。否则,将其设置为false以在CPU上运行。对于tokenizer_name、config_name、revision和kwargs等其他选项,是否需要以及如何配置取决于你的模型的具体要求和实现。

在配置完成后,你需要确保你的代码正确地加载和使用了这个配置文件。这通常涉及到读取配置文件,并使用这些配置信息来初始化模型和相关组件。具体的加载方式会根据你使用的编程语言和框架有所不同。在Python中,你可能会使用类似以下的代码来加载配置:

import json

from modelscope import initialize

with open("model_config.json") as f:

config = json.load(f)

initialize(**config)