大数据计算MaxComputepyspark3 有案例代码么 ?我看只有1.x和2.x

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

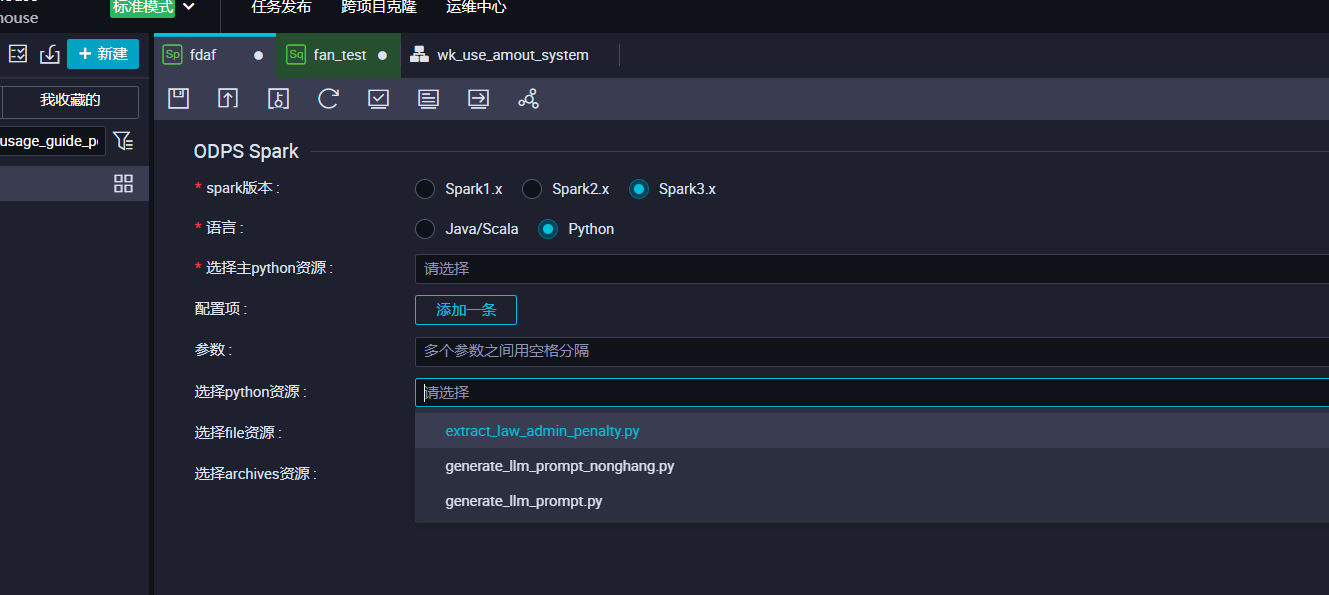

抱歉目前还没有,可以参考2的在开发环境试下。DataWorks里的spark节点环境都是直接能用的。 ,此回答整理自钉群“MaxCompute开发者社区2群”

是的,MaxCompute提供了PySpark3的示例代码。您可以在MaxCompute的控制台中找到相关的示例代码,或者通过访问MaxCompute的官方文档来获取更多信息。

以下是一个简单的PySpark3示例代码,用于读取一个文本文件并计算文件中单词的数量:

from pyspark import SparkConf, SparkContext

# 创建SparkConf对象,设置应用程序名称和运行模式

conf = SparkConf().setAppName("WordCount").setMaster("local")

# 创建SparkContext对象,用于连接Spark集群

sc = SparkContext(conf=conf)

# 读取文本文件

text_file = sc.textFile("hdfs:///user/hadoop/input.txt")

# 将每一行文本分割成单词,并将单词转换为小写

words = text_file.flatMap(lambda line: line.split(" ")).map(lambda word: word.lower())

# 对每个单词进行计数

word_counts = words.countByValue()

# 打印结果

for word, count in word_counts.items():

print("{}: {}".format(word, count))

请注意,上述代码中的文件路径需要根据您的实际情况进行修改。此外,您还需要确保已经正确配置了MaxCompute的环境,以便能够连接到Spark集群。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。