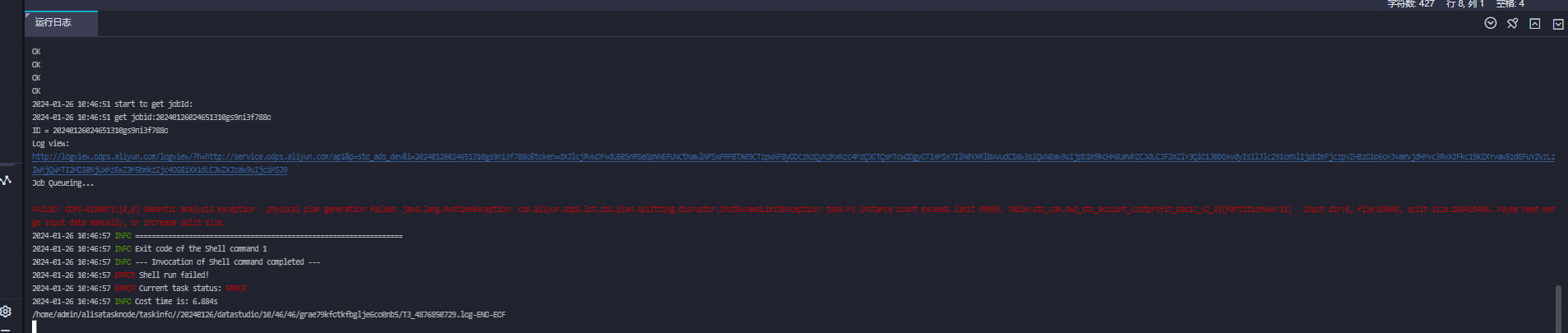

请教个大数据计算MaxCompute问题,报这个错误是啥情况?FAILED: ODPS-0130071:[0,0] Semantic analysis exception - physical plan generation failed: java.lang.RuntimeException: com.aliyun.odps.lot.cbo.plan.splitting.disruptor.InstExceedLimitException: task:M1 instance count exceeds limit 99999. Table:sto_cdm.dwd_sto_account_costprofit_basic_v2_di[PartitionNum:31] . Input dir:0, file:83848, split size:268435456. Maybe need merge input data manually, or increase split size.

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息和知识库中的相关资料,以下是针对该问题的详细分析和解决方案:

错误信息如下:

FAILED: ODPS-0130071:[0,0] Semantic analysis exception - physical plan generation failed: java.lang.RuntimeException: com.aliyun.odps.lot.cbo.plan.splitting.disruptor.InstExceedLimitException: task:M1 instance count exceeds limit 99999. Table:sto_cdm.dwd_sto_account_costprofit_basic_v2_di[PartitionNum:31] . Input dir:0, file:83848, split size:268435456. Maybe need merge input data manually, or increase split size.

此错误表明在执行SQL任务时,单个作业中的instance数量超过了MaxCompute的限制(最大为99,999)。具体原因可能包括以下几点: 1. 输入数据量过大,导致分片数量过多。 2. 分区表的分区数较多,且每个分区内的文件数较多。 3. 当前设置的split size值较小,导致分片数量增加。

根据知识库中的描述,触发此错误的条件是: - 单个作业中的instance数量超过100,000。 - 输入数据的分片数量过多,可能是由于文件数过多或split size设置过小。

从错误信息中可以看出: - 表sto_cdm.dwd_sto_account_costprofit_basic_v2_di有31个分区。 - 每个分区包含83,848个文件。 - 当前split size设置为268,435,456字节(即256MB)。

这些因素共同导致了分片数量过多,从而触发了instance count exceeds limit的错误。

为了解决此问题,您可以尝试以下方法:

split size以降低分片数量通过增大split size,可以减少分片数量,从而降低instance数量。您可以在SQL语句前添加以下设置:

set odps.sql.mapper.split.size=536870912; -- 将split size设置为512MB

说明:odps.sql.mapper.split.size的单位为字节,默认值为256MB(268,435,456字节)。增大该值可以减少分片数量,但可能会增加单个Mapper的处理时间。

如果表中存在大量小文件,建议对输入数据进行合并。可以通过以下方式实现: 1. 使用INSERT OVERWRITE重写表:

INSERT OVERWRITE TABLE sto_cdm.dwd_sto_account_costprofit_basic_v2_di PARTITION (partition_column)

SELECT * FROM sto_cdm.dwd_sto_account_costprofit_basic_v2_di;

此操作会将小文件合并为较大的文件,从而减少分片数量。

ALTER TABLE ... MERGE SMALLFILES命令(如果支持):

ALTER TABLE sto_cdm.dwd_sto_account_costprofit_basic_v2_di MERGE SMALLFILES;

如果表的分区数较多,且每个分区内的文件数较多,建议重新评估分区设计。例如: - 减少分区数量,避免过多的小分区。 - 确保每个分区内的文件大小适中(建议每个文件大小在128MB以上)。

如果SQL查询涉及复杂的计算或多个表的JOIN操作,可能会导致分片数量增加。建议: - 检查SQL逻辑,确保没有不必要的全表扫描。 - 在查询中明确指定分区条件,避免全表扫描。例如:

SELECT * FROM sto_cdm.dwd_sto_account_costprofit_basic_v2_di WHERE partition_column = 'specific_value';

split size时需谨慎:增大split size虽然可以减少分片数量,但可能会增加单个Mapper的内存消耗。如果Mapper内存不足,可能会导致任务失败。通过调整split size、合并小文件、优化分区设计或改进SQL逻辑,可以有效解决instance count exceeds limit的问题。建议优先尝试调整split size,并在必要时对表数据进行合并或优化。

如果您仍有疑问或需要进一步的帮助,请随时联系阿里云技术支持团队。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。