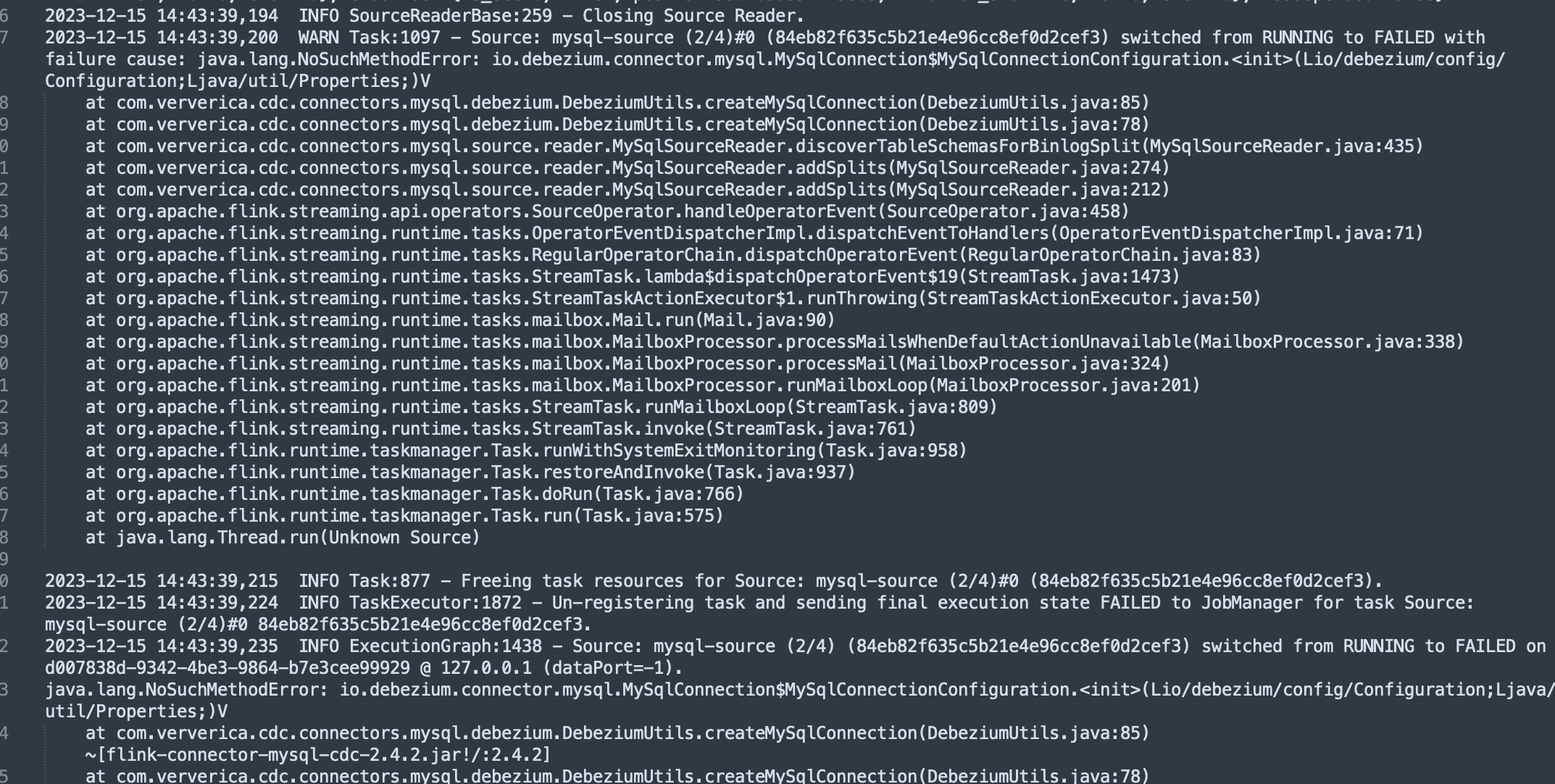

Flink CDC依赖就用了这些,报错这个?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的报错信息和知识库资料,以下是针对Flink CDC依赖冲突问题的详细分析与解决方案:

Flink CDC依赖冲突通常由以下几种情况引起: - 依赖版本不一致:作业JAR包中可能引入了不同版本的Flink、Hadoop或log4j相关依赖,导致类加载冲突。 - Connector依赖未正确打包:Flink CDC Connector所需的依赖未被打入JAR包中,或者被打入了不必要的依赖(如基本配置、Flink核心依赖等)。 - 类加载顺序问题:某些类(如org.codehaus.janino.CompilerFactory)在不同机器上的加载顺序不一致,可能导致类冲突。

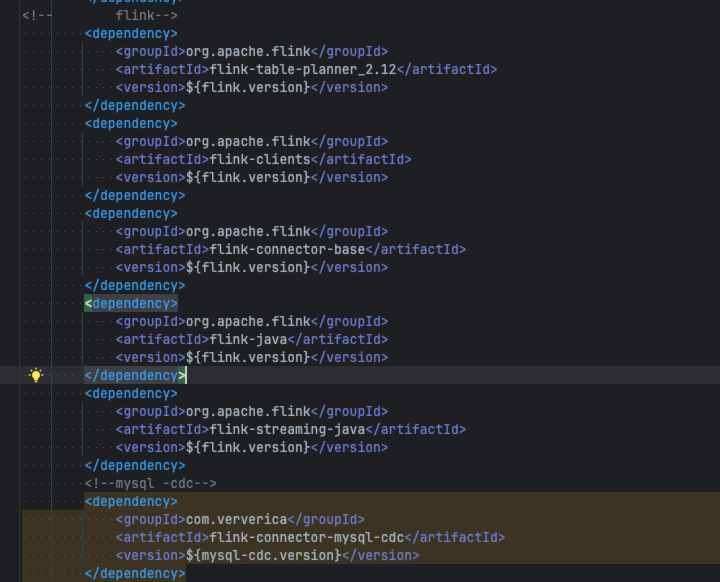

为了准确定位问题,请按照以下步骤进行排查: 1. 检查pom.xml文件

查看作业的pom.xml文件,确认是否存在不必要的依赖。例如,Flink核心依赖(如flink-streaming-java、flink-scala等)应设置为provided作用域,避免被打入JAR包中。

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

查看JAR包内容

使用以下命令检查作业JAR包中是否包含引发冲突的类或配置:

jar tf foo.jar

如果发现重复的类(如log4j相关类),需要通过exclusions排除这些依赖。

分析依赖树

使用Maven命令查看依赖关系,判断是否存在冲突的依赖:

mvn dependency:tree

如果发现冲突,可以通过exclusions移除不必要的依赖。

检查日志

开启Debug日志,确认是否存在RPC调用异常或其他依赖冲突相关的错误信息。例如:

InvocationTargetExceptionNoResourceAvailableException根据排查结果,采取以下措施解决依赖冲突问题:

log4j冲突

如果作业JAR包中引入了log4j相关配置,可以通过exclusions去除冲突的依赖。例如:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_2.11</artifactId>

<version>${flink.version}</version>

<exclusions>

<exclusion>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

</exclusion>

</exclusions>

</dependency>

如果必须使用不同版本的log4j,可以使用maven-shade-plugin对log4j相关的类进行重定位(relocation)。

Flink核心依赖

确保所有Flink核心依赖的作用域设置为provided,避免重复打包。

如果存在类加载冲突(如org.codehaus.janino.CompilerFactory),可以通过以下方式解决: 1. 在运维中心 > 作业运维页面,编辑运行参数配置,添加以下参数:

classloader.parent-first-patterns.additional: org.codehaus.janino

其中,org.codehaus.janino需要替换为实际冲突的类名。

@Public或@PublicEvolving的方法。flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar,改用稳定版本(如flink-sql-connector-mysql-cdc-2.1.0.jar)。Binlog格式要求

如果使用MySQL CDC,确保MySQL服务器的Binlog格式为ROW模式。否则可能会导致binlog probably contains events generated with statement or mixed based replication format错误。

set global binlog_format=ROW;

全量阶段表结构变更

如果在MySQL CDC全量阶段发生表结构变更,可能会导致作业报错或无法同步变更。此时需要停止作业,删除下游表并重新无状态启动。

资源分配不足

如果出现finish split response timeout异常,可能是Task Manager的CPU资源不足。建议增加Task Manager的CPU资源。

通过以上步骤,您可以有效解决Flink CDC依赖冲突问题。如果问题仍未解决,请提供更详细的报错日志,以便进一步分析。

希望以上内容对您有所帮助!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。