modelscope-funasr在运行 7B chat int4模型 时报的错

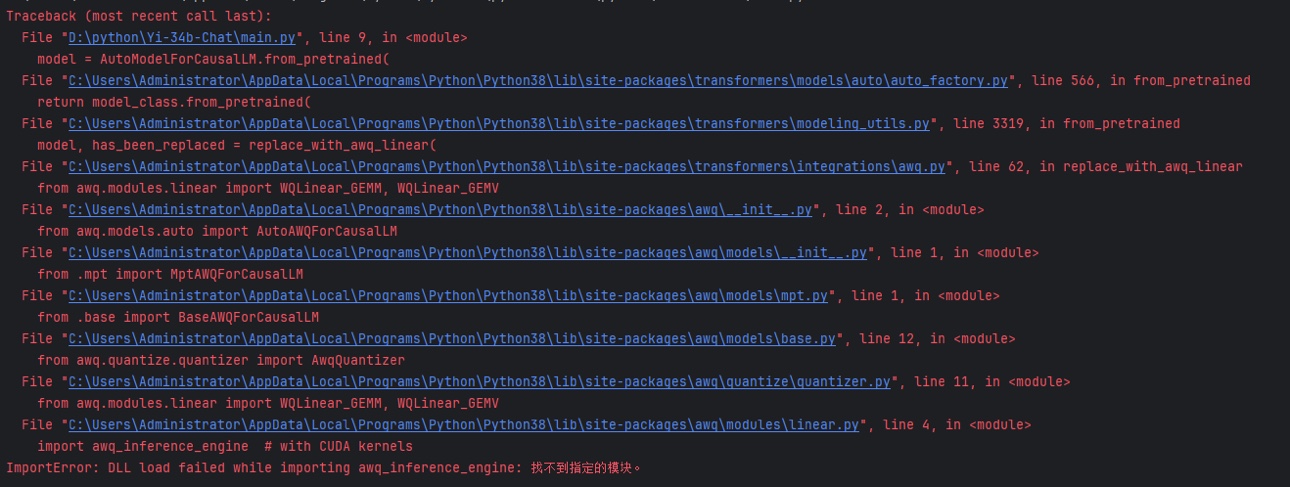

在运行 7B Chat Int4 模型 时,如果使用 ModelScope-FunASR 报错,可能是由于以下原因导致的。以下是可能的原因分析及解决方法:

modelscope://qwen/Qwen-7B-Chat-Int4

该路径需要与任务类型(如问答任务)匹配。

MODEL_ID 和 TASK 环境变量。例如:

MODEL_ID: qwen/Qwen-7B-Chat-Int4

TASK: chat

ACCESS_TOKEN)。modelscope 或 transformers)版本不匹配,可能会导致模型加载失败。pip install modelscope==1.12.0 transformers==4.37.0

v1/chat/completions

根据知识库资料,运行 7B Chat Int4 模型 时的常见问题主要集中在 模型路径配置、硬件资源、依赖库版本、加载超时 等方面。建议按照上述步骤逐一排查问题,并根据实际情况调整资源配置或依赖环境。如果问题仍未解决,可以进一步查看部署任务日志或联系技术支持获取帮助。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352