本地测试可以正常运行,在flink集群上跑就报这个错误?

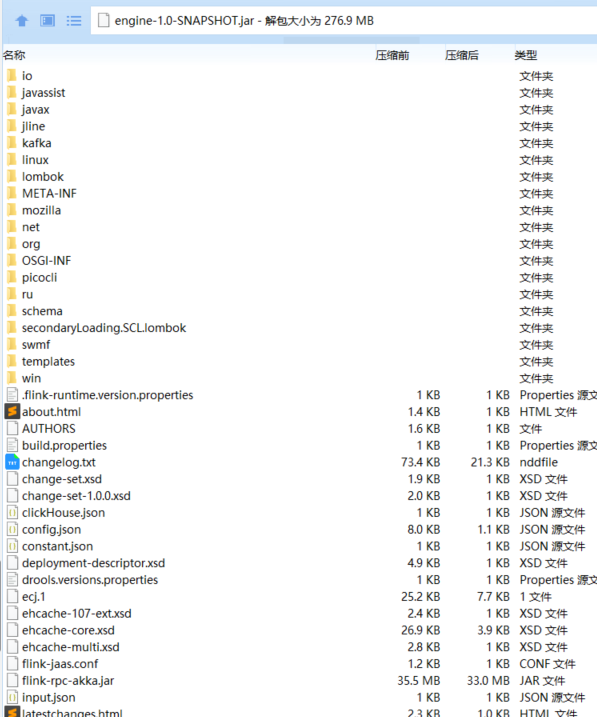

本地测试可以正常运行,在flink集群上跑就报这个错误?是用maven-shade-plugin插件打的,打出来的jar是这样的

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

无所不能的蛋蛋

本地测试可以正常运行,在flink集群上跑就报错误,这个错误大概率是因为环境问题不同导致的,因为不同的环境需要不同的配置,建议楼主多检查一下运行相关的配置

2024-01-28 22:39:50赞同 展开评论 -

coder

没有看到楼主的具体的报错信息但是针对这类问题建议楼主检查一下依赖确保你的Flink集群上的依赖和本地测试环境中的依赖是一致的。检查Flink集群上是否有正确的库和依赖项,包括所需的JAR包和其他相关文件。检查一下版本兼容性确保你的Flink版本与本地测试环境中使用的版本兼容。不同的Flink版本可能具有不同的特性、API和行为,因此需要确保版本一致性。检查在Flink集群上运行时的配置文件,确保没有遗漏或错误的配置项。特别注意与你的应用程序相关的配置项。检查环境差异,Flink集群和本地环境可能存在差异。确保Flink集群的环境能够满足你的应用程序的要求,并检查是否有任何配置或限制导致问题的发生。查看日志分析,在Flink集群上运行时,查看应用程序的日志和错误信息,以了解具体的问题和异常情况。通过详细分析日志,你可能能够更好地定位问题所在,并采取适当的措施来解决它。

2024-01-28 17:25:20赞同 1 展开评论 -

可参考下面的方法:

资源限制:Flink集群可能有资源限制,如内存或CPU。确保任务请求的资源在集群上可用,并适当调整任务资源配置。

网络问题:检查网络连接,确保Flink集群可以正常访问所有必要的服务和资源。

数据量与本地测试不同:本地测试的数据量可能远小于集群上的数据量。这可能导致处理大量数据时出现性能问题。可以考虑在集群上进行基准测试,使用相似规模的数据。

集群状态:检查Flink集群的状态,确保所有节点都运行正常。

Maven shade插件问题:有时,使用Maven shade插件可能会在打包过程中出现问题。尝试使用其他构建工具(如Gradle),或检查shade插件的配置是否正确。

版本兼容性:确保使用的Flink版本与其他组件或依赖库兼容。

查看日志:查看Flink集群的日志,查找错误信息或异常堆栈,这有助于诊断问题。

集群负载:检查集群上的其他任务是否正常,以及是否有高负载或资源争用。

重新构建和部署:尝试清理本地构建并重新构建,然后部署到Flink集群。2024-01-27 21:47:49赞同 展开评论 -

当您在本地测试Flink程序时可以正常运行,但在Flink集群上运行时出现错误,这通常是由于环境差异、配置问题或依赖项不一致等原因引起的。以下是一些建议的解决步骤:

环境一致性检查:

确认本地环境和集群环境的JDK版本是否一致。

检查Flink的版本和配置在本地和集群上是否完全相同。

验证所有依赖的库和版本在本地和集群上都是一致的。

资源分配:

检查集群上分配给Flink任务的资源是否足够(如内存、CPU)。

确保没有资源争用或资源不足导致的问题。

配置检查:

仔细检查Flink的配置文件,确保所有必要的配置都已正确设置。

检查集群的网络配置,包括防火墙设置、端口开放等,确保Flink任务能够正常通信。

日志分析:

查看Flink集群的日志文件,搜索错误信息,了解具体的错误原因。

根据日志中的堆栈跟踪信息定位问题代码。

依赖冲突解决:

如果使用Maven管理依赖,检查是否存在依赖冲突。

使用mvn dependency:tree命令查看依赖树,解决任何潜在的版本冲突。

代码审查:

仔细检查代码,确保没有使用到本地环境的特定配置或资源。

确保代码中所有的文件路径、网络连接等都是相对路径或可配置的,以适应不同环境。

测试不同环境:

尝试在一个与集群环境相似的测试环境中运行程序,看是否能够复现问题。

如果在测试环境中也无法运行,那么问题可能与环境差异有关。

集群状态检查:

确保Flink集群中的所有节点都处于正常状态,没有节点宕机或资源不足的情况。

社区支持:2024-01-27 21:37:02赞同 展开评论 -

本地测试可以正常运行,但在Flink集群上运行时出现错误,可能的原因有很多。以下是一些可能的原因和相应的解决方案:

环境配置问题:确保在Flink集群上的环境配置与本地环境一致。这包括但不限于Java版本、内存设置、依赖库等。

资源限制:Flink集群可能有资源限制,如内存或CPU。确保任务请求的资源在集群上可用,并适当调整任务资源配置。

网络问题:检查网络连接,确保Flink集群可以正常访问所有必要的服务和资源。

数据量与本地测试不同:本地测试的数据量可能远小于集群上的数据量。这可能导致处理大量数据时出现性能问题。可以考虑在集群上进行基准测试,使用相似规模的数据。

集群状态:检查Flink集群的状态,确保所有节点都运行正常。

Maven shade插件问题:有时,使用Maven shade插件可能会在打包过程中出现问题。尝试使用其他构建工具(如Gradle),或检查shade插件的配置是否正确。

版本兼容性:确保使用的Flink版本与其他组件或依赖库兼容。

查看日志:查看Flink集群的日志,查找错误信息或异常堆栈,这有助于诊断问题。

集群负载:检查集群上的其他任务是否正常,以及是否有高负载或资源争用。

重新构建和部署:尝试清理本地构建并重新构建,然后部署到Flink集群。2024-01-27 21:24:01赞同 展开评论 -

十分耕耘,一定会有一分收获!

楼主你好,看了你的描述,这可能是由于打包方式或依赖库冲突导致的。

当使用maven-shade-plugin插件进行打包时,它会将所有依赖库打包到生成的jar文件中,但有时候依赖库的版本可能与集群环境中存在的版本不匹配,从而导致运行时报错。

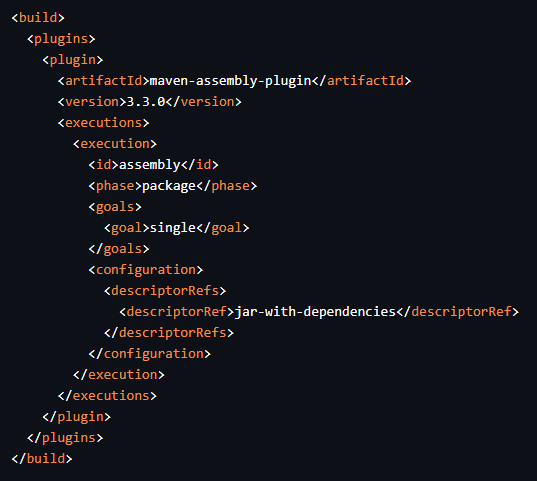

解决这个问题的一种方式是,将打包方式修改为使用maven-assembly-plugin插件,它不会将所有依赖库打包到生成的jar文件中,而是将依赖库与应用程序分开打包,并在集群中配置正确的依赖库路径。

以下是使用maven-assembly-plugin进行打包的示例配置(pom.xml文件中):

<build> <plugins> <plugin> <artifactId>maven-assembly-plugin</artifactId> <version>3.3.0</version> <executions> <execution> <id>assembly</id> <phase>package</phase> <goals> <goal>single</goal> </goals> <configuration> <descriptorRefs> <descriptorRef>jar-with-dependencies</descriptorRef> </descriptorRefs> </configuration> </execution> </executions> </plugin> </plugins> </build>在运行上述配置后,生成的jar文件将包含依赖库,并且可以在集群中正确加载依赖库。

2024-01-27 14:26:25赞同 展开评论 -

天下风云出我辈,一入江湖岁月催,皇图霸业谈笑中,不胜人生一场醉。

检查下使用的connector版本是否和flink集群版本一致。建议在提交作业前,先在本地测试环境中确认作业的运行情况,而且麻烦提供一下报错日志,方便更快速的确认问题原因。

2024-01-25 09:40:32赞同 展开评论 -

-

深耕大数据和人工智能

如果在Flink集群上运行出现错误,可以尝试以下方法:

检查Flink集群的配置。确保Flink集群的配置正确,例如正确的主机名、端口号、资源分配等。

检查Flink作业的配置文件。确保Flink作业的配置文件正确,例如正确的作业配置、连接器配置等。

检查Flink集群的资源使用情况。如果Flink集群的资源不足,可能会导致作业无法正常运行。可以查看Flink集群的资源使用情况,并根据实际情况调整资源分配。

检查Flink集群的版本。确保Flink集群的版本与本地测试时的版本一致,否则可能会出现兼容性问题。

查看Flink集群的日志。查看Flink集群的日志文件,以获取有关错误的详细信息。这可以帮助你更好地了解问题所在。

使用调试模式。在调试模式下,Flink会提供更多的调试信息,例如每个算子的输入输出数据、处理时间等。这可以帮助你更深入地了解作业的执行过程,从而更快地找到问题所在。2024-01-17 17:06:20赞同 1 展开评论 -

某政企事业单位安全运维工程师,主要从事系统运维及网络安全工作,多次获得阿里云、华为云、腾讯云征文比赛一二等奖;CTF选手,白帽,全国交通行业网络安全大赛二等奖,全国数信杯数据安全大赛银奖,手握多张EDU、CNVD、CNNVD证书,欧盟网络安全名人堂提名,联合国网络安全名人堂提名

你的FLINK引擎部署包包含了一个名为.flink-runtime.version.properties文件,该文件似乎是一个属性文件,其中包含了有关 FLINK 运行时版本的相关信息。当你试图在一个没有正确安装 FLINK 的环境中运行此 jar 包时,就会引发 java.lang.RuntimeException: Could not find the runtime version file. 错误。

为了解决这个问题,你可以尝试以下几种方式:

将 .flink-runtime.version.properties 文件添加到类路径

一种简单的方法是在运行时将 .flink-runtime.version.properties 添加到类路径中。这样,FLINK 应用就可以找到正确的运行时版本信息。可以通过修改命令行选项 -cp 来指定类路径的位置,如下所示:

Bash $ java -Xmx<heap-size> -cp <your-classpath>:./engine-1.0-SNAPSHOT.jar com.example.MainClass请替换 为你实际的类库路径列表,注意这里不包含 .flink-runtime.version.properties 文件本身。

在打包阶段合并 .flink-runtime.version.properties 文件

另一种方法是从构建过程开始着手解决问题。你可以尝试使用 Maven 插件(如 maven-shade-plugin)重新打包你的项目,使其将所有的依赖项整合在一起,而不是单独创建每个 JAR 包。这样做可以使最终生成的 JAR 包更加紧凑,同时也更容易管理和分发。

以下是使用 maven-shade-plugin 打包的一个示例:

<!-- pom.xml --> ... <build> ... <!-- Add shade plugin to your build configuration --> <plugins> <plugin> <groupId>org.apache.maven.plugins</groupId> <artifactId>maven-shade-plugin</artifactId> <version>3.x</version> <executions> <execution> <phase>package</ phase> <goals> <goal>shade</ goal> </goals> <configuration> <transformers> <transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer"> <mainClass>com.yourcompany.YourMainClass</ mainClass> </transformer> </transformers> </configuration> </execution> </executions> </plugin> ... </plugins> </build> ... // Your Main Class should be annotated with @ProgrammaticMain or similar annotation. @ProgrammaticMain public class YourMainClass { }这段代码将会把所有依赖项及其相关元数据一起打包进一个新的 JAR 中,使得不需要额外的步骤就能让 FLINK 集群识别到正确的运行时版本信息。

2024-01-12 22:52:29赞同 1 展开评论 -

北京阿里云ACE会长

在Flink集群上运行时出现问题。这可能是由于集群环境与本地环境之间的差异导致的。以下是一些建议,希望对您有所帮助:

- 检查集群环境配置:请确保Flink集群的配置与您的本地测试环境相同。这包括检查Flink版本、集群模式(例如,YARN、Mesos或Standalone)、资源配置(如内存、CPU等)以及提交作业的方式(例如,使用Flink Web界面、命令行或第三方工具)。

- 检查依赖问题:确保您在集群环境中使用的依赖与本地测试环境相同。检查pom.xml文件,确保所有依赖项都正确配置,并且没有版本冲突。

- 检查类路径问题:在Flink集群上运行时,可能会出现类路径问题。请检查集群中的类路径设置,确保没有遗漏或错误的类路径。

- 检查集群节点间通信:如果您的应用程序涉及到集群节点间的通信,请确保集群中的所有节点都可以互相通信,没有防火墙或其他网络障碍阻止通信。

- 检查Flink作业的日志:查看Flink作业的日志,了解在集群上运行时出现的具体错误信息。这将帮助您进一步定位问题。

- 尝试减小问题范围:为了缩小问题范围,您可以尝试在集群上运行一个简单的示例应用程序,以确认问题是否仍然存在。如果简单的示例应用程序在集群上运行正常,那么问题可能出在您的复杂应用程序中。此时,您需要仔细检查您的应用程序代码和依赖项,以找出问题所在。

2024-01-12 21:13:07赞同 1 展开评论 -

看起来你遇到了一些 jar 包冲突的问题。

META-INF/MANIFEST.MF文件包含有关 JAR 文件的信息,而MANIFEST.MF文件通常包含了应用程序的基本描述符,如类路径、主类名称等等。当你打包项目的时候,Maven 使用 maven-shade-plugin 插件压缩你的依赖项,创建一个新的 jar 包。在这个过程中,如果有多个相同名字的类被重复加载,就会产生冲突。此外,如果没有正确地排除掉不需要的依赖,也会导致 jar 包过大并且可能出现 classpath 错误。要解决这个问题,你可以尝试以下几种方式:

- 更新 Maven Shade Plugin 版本:有时候较旧的版本存在 bug 导致 jar 包生成有问题。更新到最新版试试看。

- 添加排除依赖:在 pom.xml 文件里明确声明哪些依赖不应该被打进最终的 jar 包内。例如,如果你知道有一个第三方库 A 已经提供了你需要的功能,就不必再把另一个实现了同样功能的库 B 打进去。

- 使用多模块构建:如果你的应用是一个大型项目,有许多相互独立的部分,可以考虑将其拆分成几个单独的模块,各自负责一部分功能。这样既可以减小单个 jar 包的体积,也可以方便管理和维护各个部分之间相对隔离的关系。

- 对编译后的输出目录进行整理:删除未使用的中间产物,只保留必要的内容。

2024-01-12 15:02:49赞同 1 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。