https://archive.apache.org/dist/flink/flink-1.13.0/

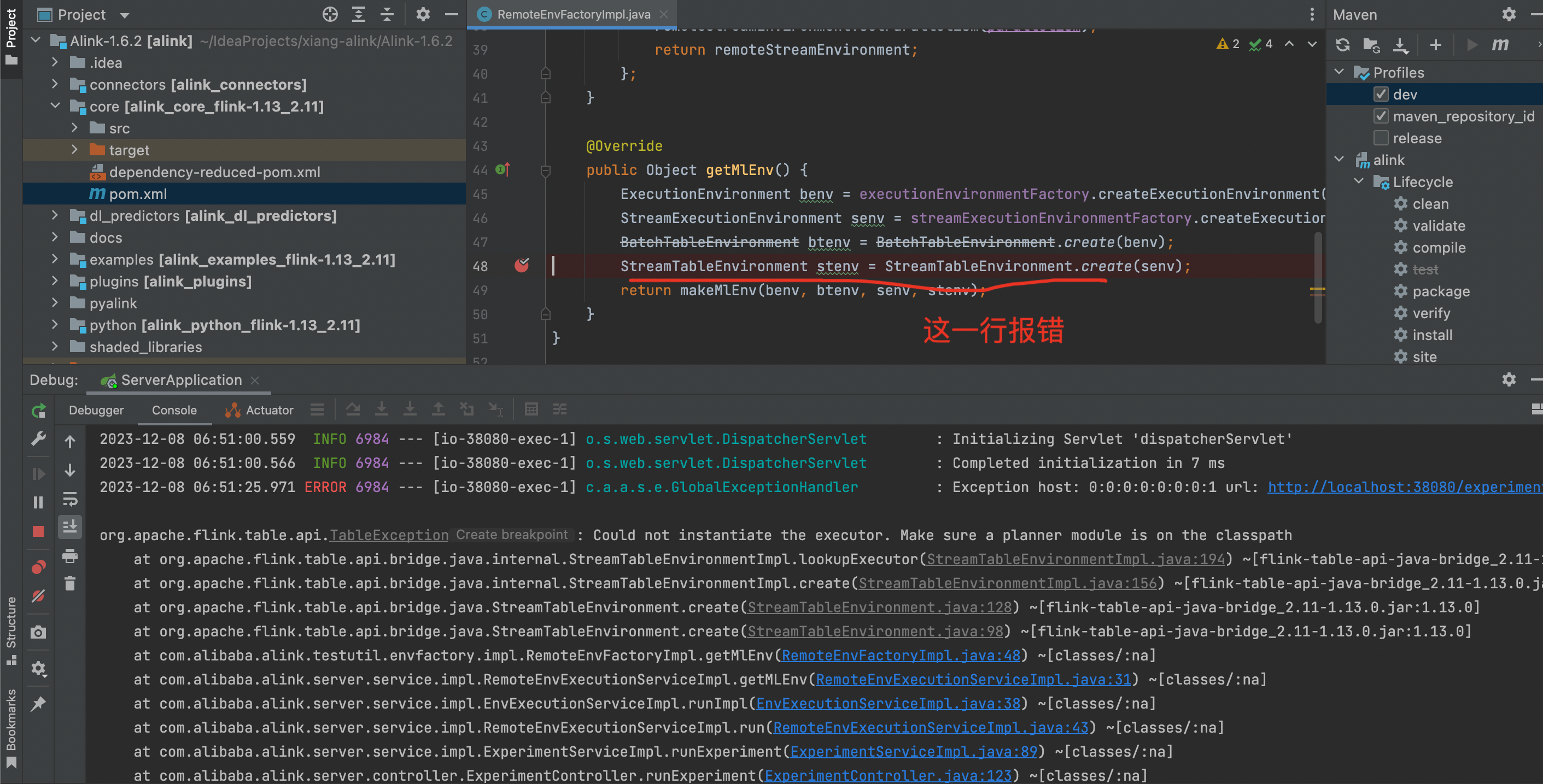

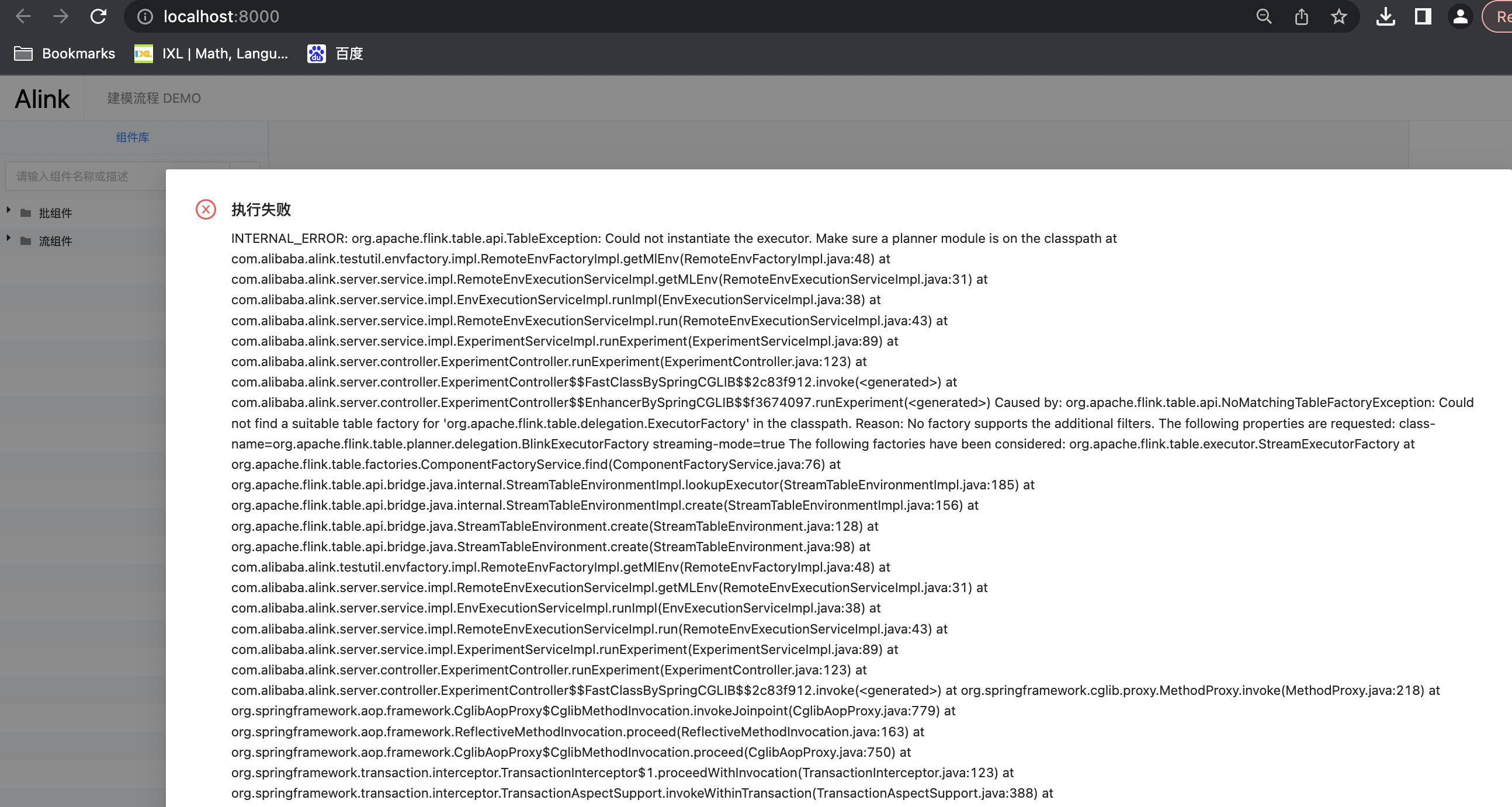

INTERNAL_ERROR: org.apache.flink.table.api.TableException: Could not instantiate the executor. Make sure a planner module is on the classpath at com.alibaba.alink.testutil.envfactory.impl.RemoteEnvFactoryImpl.getMlEnv(RemoteEnvFactoryImpl.java:48) at

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息和知识库中的相关资料,以下是针对问题的详细解答:

错误信息显示:

INTERNAL_ERROR: org.apache.flink.table.api.TableException: Could not instantiate the executor. Make sure a planner module is on the classpath

此错误表明在运行Flink作业时,未能正确加载执行计划模块(planner module)。这通常是由于以下原因之一导致的: 1. 依赖冲突:Flink的某些核心依赖未正确加载或与其他依赖发生冲突。 2. 类路径问题:缺少必要的Flink Planner模块(如flink-table-planner)或其版本不匹配。 3. API调用问题:使用了非公开的内部API(internal API),而这些API在不同版本之间可能存在兼容性问题。

@Public或@PublicEvolving的方法才是公开供调用的,阿里云仅对这些方法的兼容性提供保证。provided,即在Maven依赖中添加如下配置:<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner_2.11</artifactId>

<version>1.13.0</version>

<scope>provided</scope>

</dependency>

这可以避免因重复加载依赖而导致的冲突。

flink-table-planner模块。如果该模块未正确加载,会导致无法实例化执行器。请确保以下依赖已正确添加到项目中:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner_2.11</artifactId>

<version>1.13.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>1.13.0</version>

</dependency>

org.codehaus.janino.CompilerFactory类冲突),可以通过调整类加载顺序解决。根据知识库中的建议,在Flink作业的运行参数中添加以下配置:

classloader.parent-first-patterns.additional: org.codehaus.janino

具体操作步骤如下: 1. 登录Flink控制台,进入目标作业的运维中心 > 作业运维页面。 2. 单击目标作业名称,进入部署详情页签。 3. 在运行参数配置区域,单击右侧的编辑。 4. 在其他配置文本框中输入上述参数后,单击保存。

1.13.0。请确保使用的Flink版本与依赖库版本一致。如果使用的是阿里云实时计算Flink版,建议参考官方文档确认支持的Flink版本范围。@Public或@PublicEvolving)可能在不同版本间发生变化,使用这些API可能导致兼容性问题。provided,以避免类冲突。通过以上步骤,您可以有效解决Could not instantiate the executor的问题。如果仍有疑问,请提供更多上下文信息(如完整的依赖配置或作业代码),以便进一步分析。

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。